股價大幅回呼,輝達遭遇強勁挑戰

作者/ IT時報記者賈天榮

編輯/郝俊慧 孫妍

輝達最近有點「煩」。

一個月前的6月18日,這家AI芯片巨頭以3.34萬億美元的市值擊敗微軟,登頂世界第一。然而,一個月後,當地時間7月17日盤後,輝達以6.6%的跌幅居納斯達克權重股「七巨頭」之首,117.99美元的收盤價較歷史最高位回呼超過12.97%。

事實上,登頂之後,輝達的股價便一直不太穩定。自2022年AI浪潮興起之後,如此顯著的回呼頗為罕見,畢竟作為全球智算芯片的主力廠商,輝達在人工智能(AI)、高效能計算(HPC)、數據中心以及圖形處理單元(GPU)等市場都具有領導地位。

顯然,當狂熱逐漸冷靜之後,GPU的高昂使用成本和高功率能耗等問題逐漸被投資人正視,越來越多GPU之外的AI芯片受到關註。

不久前,2024世界人工智能大會(WAIC2024)RISC-V 和生成式 AI 論壇上,知合計算CEO孟建熠提出, 芯片行業正進入「XPU」時代。

IDC數據顯示,2023年的AI伺服器以GPU伺服器占主導,市場份額92%達87億美元,NPU、ASIC 和 FPGA等非GPU加速伺服器以同比49%的增速占據近8%的市場份額,到2028年中國非GPU伺服器市場規模將超過33%。

XPU:通用與專用之戰

2016年,輝達將第一台DGX-1超級電腦交付給一家舊金山的初創公司——OpenAI,8年後,這家初創公司推出的ChatGPT 3.5震驚全球,並拉開了人類向通用人工智能沖刺的序幕。

DGX-1整合了8塊P100 GPU芯片,算力為170Tflops(每秒170萬億次浮點計算),成功將OpenAI原本需一年完成的大模型訓練周期縮短至一個月。

加速的關鍵原因在於,深度學習需要處理大量非結構化數據和「蠻算」,這對芯片的多核並列運算、片上儲存、頻寬、低延時訪存等提出了較高需求,而GPU擁有大量並列處理單元,能夠同時處理多個任務,可以顯著加速深度學習模型訓練和推理過程,特別是在處理大規模數據集和復雜計算任務時表現尤為突出。

2022年底,隨著OpenAI透過ChatGPT印證,算力超過一定「尺度」後,便會形成人工智能的「智慧湧現」,生成式AI對GPU算力的需求陡增,而輝達則上演了一出「大象轉身」的好戲。

只是,對於「尺度定律」(Scaling Law)的擔憂和質疑一直存在。

隨著行業需求的激增和計算技術的演進,傳統的馮·諾依曼架構面臨記憶體墻和功耗墻的挑戰,儲存與計算的分離導致了數據傳輸瓶頸,限制了計算系統的整體效能。GPU盡管通用性強且生態完善,但在高能耗和較低的算力利用效率面前,也開始顯露疲態。

在中昊芯英創始人、CEO楊龔軼凡看來,GPU的成熟性和廣泛的軟件支持雖是其優勢所在,卻也構成了發展的桎梏。他指出,GPU芯片架構和底層邏輯的固定性,阻礙了大規模的最佳化升級,若要大幅改變,勢必破壞已有的CUDA生態,「它的回溯相容性導致GPU的天花板是比較低的。」

楊龔軼凡認為,隨著產業發展,行業逐步落地,算力規模增加,在成本考量變得更為重要的前提下,軟硬件一體化的設計理念顯得愈發關鍵。這種設計思路強調硬件與軟件的協同最佳化,旨在針對特定演算法和套用場景打造客製化的解決方案,從而實作更高的效能和更低的能耗。

在WAIC2024上,中國RISC-V產業聯盟理事長、芯原微電子創始人戴偉民直言,「 GPU 並不一定是 Transformer 的最優算力芯片,有越來越多的專用芯片正在浮出水面,挑戰輝達最先進的產品,顯示出技術生態的多樣化。 」戴偉民認為,未來的AI時代,隨著基礎大模型市場格局逐步清晰,針對具體套用場景的AI微調將更加普遍,針對特定AI套用的專用芯片將成為主流。

芯片進入「XPU」時代

如戴偉民所言,隨著行業對算力需求的不斷提高,越來越多的計算平台開始引入多種不同計算單元來進行加速計算。在GPU面臨日益明顯的瓶頸之際,專用集成電路(ASIC)和特定領域架構(DSA)的芯片正崛起為潛在的挑戰者。

近期AI芯片兩個備受矚目的融資訊息均與ASIC芯片(專用集成電路)有關。ASIC是一種為特定套用設計的集成電路,它針對某一類運算或功能進行高度最佳化,因此在執行這類特定任務時效率極高,缺點是一旦設計完成並制造出來,其功能和結構基本不能再改變。

6月26日,美國新興的芯片創業公司Etched釋出其首款ASIC AI芯片——Sohu。 這款芯片在執行大模型時展現出了驚人的效能,其速度超輝達p00的20倍 ,即便是與今年3月才面世的輝達頂尖芯片B200相比,Sohu也展現出10倍的優越效能。

Sohu芯片的最大突破在於它直接將Transformer架構嵌入芯片內部。據Etched公司負責人Uberti透露,Sohu采用了台積電的先進4納米工藝制造,不僅在推理效能上遠超GPU和其他通用人工智能芯片,更在能耗控制上達到了新高度。

「 目前,大模型訓練芯片還是以GPU為主,不過NPU和ASIC呈現快速增長的趨勢,而且增速超過了GPU。 」IDC中國分析師杜昀龍在接受【IT時報】記者采訪時表示。

某種意義上,NPU(神經網絡處理單元)是專為處理機器學習和深度學習任務而設計的ASIC芯片,它的工作原理是利用其專門設計的硬件結構來執行神經網絡演算法中的各種數學運算,如矩陣乘法、摺積運算等,這些演算法是神經網絡訓練和推理過程的核心操作。與傳統的中央處理單元(CPU)和圖形處理單元(GPU)不同,由於在硬件層面最佳化了演算法,提升了芯片的整體效能和能效,NPU可以更低的能耗和更高的效率執行這些操作。

記者註意到,不少國內芯片廠商正奮力自研NPU,以把握AI浪潮。今年年初,中星微電子釋出了中國首款嵌入式神經網絡處理器(NPU)「星光智能一號」的最新成果,該芯片已實作量產。華為自研的AI處理器昇騰910B也是一款NPU,專門設計用於加速人工智能計算任務。

國家重點實驗室執行主任張韻東介紹,NPU采用了「數據驅動平行計算」的架構,徹底顛覆了傳統的馮·諾依曼架構。這種數據流(Dataflow)類別的處理器,極大地提升了計算能力與功耗的比例,特別擅長處理影片、影像類的海量多媒體數據,使得人工智能在嵌入式機器視覺套用中可以大顯身手。

當然,「群毆」GPU的還有更多XPU。

由谷歌TPU(張量處理單元)發明者之一Jonathan Ross創立的Groq,於今年2月推出ASIC芯片LPU(語言處理器),宣稱該LPU推理效能是輝達GPU的10倍,成本僅為其十分之一。

誰將成為GPU最終挑戰者?

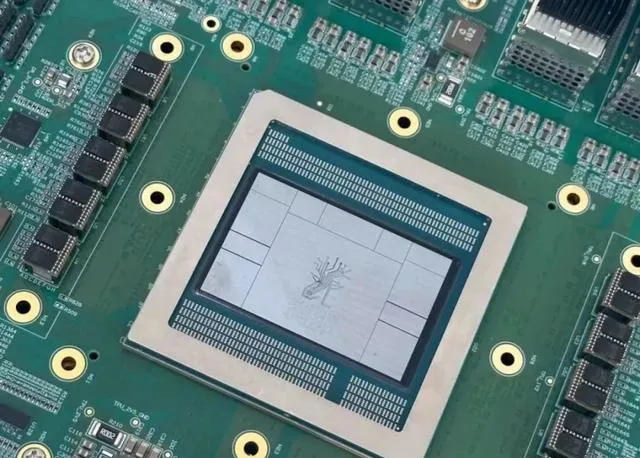

「 我們認為未來AI賽道,一半市場是GPU,一半市場是TPU。 」楊龔軼凡曾在 Google 深度參與 Google TPU 2/3/4 的設計與研發,2018年,楊龔軼凡回國成立中昊芯英,專註於國產TPU芯片的研發。據其介紹,目前中昊芯英是國內唯一掌握 TPU 架構訓推一體 AI 芯片核心技術的公司,公司自研的 TPU 人工智能訓練芯片「剎那®」在處理 AI 計算場景時的算力效能是輝達A100的近1.5倍,在完成相同訓練任務量時的能耗降低 30%,單位算力成本僅為輝達A100的42%。

TPU是一款DSA架構的AI計算芯片,它由谷歌自己設計,並專門用於機器學習工作負載。業界對於TPU的關註,始於Google在2013年的秘密專案。彼時,Google研發 AI機器學習演算法芯片,並用於雲端運算數據中心,取代輝達 GPU。2016年,AlphaGo擊敗了南韓棋手李世石,其「大腦」背後便是48個TPU。

相較於其他XPU,TPU最大的優勢是和目前LLM大模型的底層架構Transformer同出一源。

被稱為人工智能領域「聖杯」的Transformer,源自2017年11月由Google AI研究人員發表的一篇論文【Attention is All You Need】,該模型采用了註意力機制來處理序列數據,從而解決了傳統的RNN(迴圈神經網絡)模型在長距離依賴問題上的困境。

盡管真正讓Transformer成為全球大模型基石的是OpenAI,但谷歌在基於Transformer架構研發的軟硬一體化方案上,始終獨具優勢。

今年5月,Google釋出了第六代TPU,稱為Trillium,並表示將於今年晚些時候交付。Google表示,第六代Trillium芯片的計算效能比TPU v5e芯片提高4.7倍,能效比v5e高出67%。Gemini 1.5 Flash、Imagen 3和Gemma 2等大模型,都經過 TPU 訓練並提供服務。

從谷歌釋出的資訊來看,基於TPU訓練的大模型效果優異。根據Google的基準測試結果,Gemini Ultra版本在許多測試中都表現出了「最先進的效能」,甚至在大部份測試中完全擊敗了OpenAI的GPT-4。

「你可以這麽理解,TPU是通用的Transformer架構AI芯片。」楊龔軼凡解釋,TPU不僅能支持所有Transformer模型,也能支持所有深度學習模型,但它的通用性只體現在基於Transformer的AI賽道裏,但除此之外,在其他賽道的運算效果可能遠遠不如GPU。

無論如何,基於AI芯片的通用和專用之戰已經開打,在這場新的戰爭中,看似「風光無限」的輝達危機四伏,全世界的人工智能企業在「貪婪」地搶購GPU的同時,紛紛「下註」自研芯片。

據不完全統計,包括Groq、特斯拉的Dojo 2、AWS的Trainium、OpenAI新做的芯片等在內,美國現在有數十家企業和初創公司都在推動類TPU架構的芯片研發和套用。業內人士也表示, 大多數廠商的ASIC架構芯片都只支持少數Transformer模型,在專用性上鉆得更深,但通用性差一些,Sohu便是如此。

國產AI芯片的XPU夢想

XPU打敗CPU和GPU的夢想早已有之。

早在2020年,ASIC便被認為是下一代AI芯片主流架構,針對特定任務專門設計框架,ASIC芯片能在快速提升算力的同時降低能耗。最近剛被軟銀收購的英國AI獨角獸Graphcore為AI處理器開發的新型智能處理單元(IPU),更是一度被視作可以與輝達「掰手腕」的秘密武器。

然而,一款芯片從設計到最後大規模生產,是一個漫長的過程,從研發到年產1000片至少需要五年時間,再到年產100萬片則需要更久, 這意味著一家AI芯片公司從成立到成熟量產至少需要十年的時間,在任何一個階段都可能全軍覆沒。

而輝達愈發成熟的CUDA生態,讓產業鏈根本沒有大規模轉移的動力。這也是為何時至今日,輝達依然在全球數據中心市場占據85%以上份額的根本原因。

但對於國產芯片廠商而言,近兩年逐漸落下的「科技鐵幕」卻從另一層面打破了輝達的「軟性封鎖」,當輝達高端算力芯片H系列和B系列無法進入中國時,自研成為唯一的出路,各種芯片架構也呈現出百花齊放的繁榮。

不久前的WAIC 2024上,開源的RISC-V架構被認為是非常適合AI的架構。摩爾執行緒也宣稱具備了萬卡萬P萬億參數通用算力集群能力。

中昊芯英TPU人工智能訓練芯片「剎那®」也於去年成功量產,並已在全國多地千卡集群規模的智算中心交付落地。據介紹,「剎那®」以1024 片芯片高速片間互聯的能力構建了大規模智算集群「泰則®」,系統集群效能遠超傳統 GPU 數十倍,可支撐超千億參數AIGC大模型訓練與推理。但楊龔軼凡也坦言,TPU芯片在目前國內的認知普及程度還比較低,很大程度上是因為現在研發並對外提供類TPU芯片的大多是初創公司,谷歌TPU的大集群也並未對外開放,導致客戶無法大規模采購和使用這類產品。與互聯網服務的即時可延伸性不同,硬件產品的生產需要時間和空間,無法立即響應市場需求的激增。

記者了解到,谷歌可能在今年底停止外部AI算力芯片的采購,轉而完全依賴自研的TPU。谷歌的算力總量,結合自研TPU和先前的芯片采購,預計將在今年達到全球算力總量的25%。

「TPU這個賽道會變得越來越重要。」楊龔軼凡認為,未來在整個大模型的AI賽道裏面,TPU最有機會成為這個賽道的 「X86」。

杜昀龍也告訴【IT時報】記者,AI 大模型市場推動了訓練芯片的需求。推理芯片對技術的要求相對較低,並且推理也是將模型落地實作變現的途徑。在大環境的影響下,同時有政策扶持的情況下,國產芯片廠商遍地開花,從不同技術維度,行業維度都有突破性發展。

對於相對小規模的芯片企業來說,開發推理芯片,針對細分行業的套用場景,能給企業帶來發展。對於技術過硬,資金雄厚的企業來說,高效能的訓練芯片有很大空缺,也是未來發展的良機。

排版/ 季嘉穎

圖片/ 輝達 Etched 中昊芯英 東方IC

來源/【IT時報】公眾號vittimes

E N D