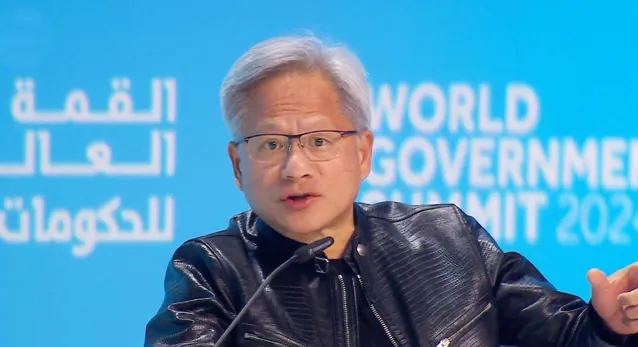

輝達CEO黃仁勛(Jensen Huang)

由於ChatGPT爆火引發 AI 算力需求熱潮,輝達 AI 芯片供不應求、大規模短缺。如今,輝達似乎遭遇到了更多挑戰。

台北時間2月21日,據報道,科技巨頭微軟正在開發一種新的網卡芯片,替代輝達ConnectX SmartNIC智能網卡產品,以確保 AI 模型數據可以在微軟雲伺服器之間快速傳輸。

微軟方面確認了此訊息。該公司在一份聲明中表示,作為微軟Azure基礎設施系統方法的一部份,公司經常開發新技術來滿足客戶的需求,包括網絡芯片。

實際上,作為輝達GPU(圖形處理器)的最大客戶之一,微軟事件是一個重要「訊號」。除了省成本之外,微軟還希望新網卡能夠提高其輝達芯片伺服器的效能,將有助於使用微軟雲的OpenAI 研發更多 AI 大模型。

不止是微軟。

近兩天,一家名為Groq的美國 AI 公司一夜「爆火」,主要因其自研的LPU芯片在 AI 推理技術上,透過最佳化架構和減少記憶體瓶頸,實作了高效率和低延遲,在處理大模型時的速度遠超輝達GPU,每秒生成速度接近500 tokens,而GPT-4僅40 tokens。

因此,Groq LPU被譽為「史上最快的大模型技術」。

受上述訊息以及外部環境影響,截至2月20日美股收盤,輝達單日股價下跌4.35%,創下去年10月以來的最大單日跌幅,一夜之間總市值縮水780億美元(約逾5600億元人民幣)。

2月20日,IDC分析師對鈦媒體App等表示,隨著Sora的推出,多模態大模型對 AI 算力的消耗更高,算力的可獲取性以及成本將是行業挑戰之一。

那麽,面對這種新的競爭局勢,輝達真的危險了嗎?

Groq到底是誰?為什麽這麽強?

據悉,Groq公司成立於2016年,總部位於美國加利福尼亞,創始團隊中有很多人都參與過谷歌TPU專案。

其中,Groq創始人兼 CEO莊拿芬·羅斯(Jonathan Ross)曾設計並制作出了第一代谷歌TPU芯片的核心元件,TPU 20%的研發專案都由他完成。

公司領導層的10人中,有8人都有在谷歌、英特爾等科技巨頭的工作經歷。

Groq創始人兼 CEO莊拿芬·羅斯(Jonathan Ross)

融資方面, 截至目前,Groq共完成了3輪融資,總共融資到了3.67億美元。最後一輪融資在2021年4月完成,融資金額為3億美元,由老虎環球基金(Tiger Global Management)和投資公司D1 Capital領投。

Groq之所以能夠在此次 AI 熱潮中「爆火」,主要得益於其使用了自研芯片LPU(Language Processing Units),而不是輝達的GPU(圖形處理器)芯片,它能實作高速度和低延遲。

據Groq在2024年1月的第一個公開基準測試,由Groq LPU驅動的Meta Llama 2-70B模型,推理效能比其他頂級雲端運算供應商快18倍。

Groq LPU的工作原理與輝達的GPU不同,它采用了名為時序指令集電腦(Temporal Instruction Set Computer)架構,使用記憶體為靜態隨機存取記憶體(SRAM),其速度比GPU所用的高頻寬記憶體(HBM)快約20倍。

從芯片的規格中,SRAM容量是230MB,頻寬80TB/s,FP16的算力是188TFLOPs。

這一區別造成了 LPU和GPU在生成速度的差別。據Groq表示,輝達GPU生成每個tokens需要約10焦耳(J)到30焦耳,而 Groq 僅需1焦耳到3焦耳。

值得註意的是,雖然Groq做到了足夠快,但背後成本卻非常高昂。

2月20日,前阿裏巴巴集團副總裁、Lepton AI創始人兼CEO 賈揚清在社交平台上表示,由於每一張Groq卡的記憶體容量僅為230MB,因此在執行Llama-2 70B模型時,需要305-572張Groq卡才足夠,而用p00則只需要8張卡。

賈揚清認為,如果按未來執行三年的成本算,Groq的硬件采購成本是1144萬美元,營運成本至少要76.2萬美元。從目前的價格來看,這意味著在同等吞吐量下,這幾乎是p00硬件成本的40倍、能耗成本的10倍

據騰訊科技,芯片專家姚金鑫(J叔)表示,Groq對Llama2-7B的Token生成速度是750 Tokens/s。如果從成本的角度,9台的Groq伺服器,也是遠遠貴過2台總共16顆的p00芯片的伺服器,即使目前價格已經非常高了。

「輝達在本次AI浪潮中的絕對領先地位,使得全球都翹首以盼挑戰者。每次吸引眼球的文章,總會在最初被人相信,除了這個原因之外,還是因為在做對比時的‘套路’,故意忽略其他因素,用單一維度來做比較。」姚金鑫表示。

不止是成本高昂。SRAM技術面積大、功耗比較高,早就以IP內核形式整合到SoC(系統級芯片)裏面,並非單獨用,遠不如HBM的未來發展潛力。不管是比單位容量價格、還是效能和功耗,輝達GPU所使用的HBM技術都優於SRAM。

雖然Groq的芯片成本較高,但其創始人Jonathan Ross已表示,隨著GPU短缺和成本上升,Groq的LPU將有巨大的市場潛力。

不僅是Groq。

據The information 2月21日報道,輝達的重要客戶、全球最高市值的科技巨頭微軟計劃設計一款新的網卡芯片,以替代輝達相關產品。

知情人士稱,微軟行政總裁薩蒂亞·納德拉 (Satya Nadella) 已任命網絡器材開發商瞻博網絡 (Juniper Networks) 聯合創始人普拉迪普·辛杜 (Pradeep Sindhu) 來領導網卡工作。據悉,微軟一年前收購了辛杜創立的伺服器芯片初創公司Fungible。

據悉,網卡是數據中心與伺服器內部的一項重要技術,旨在加速伺服器之間的流量,解決大流量網絡封包處理占用CPU的問題。

在此之前,輝達曾釋出NVIDIA ConnectX SmartNIC 智能網卡,最新的ConnectX-7 透過加速交換和封包處理(ASAP2)、高級RoCE、GPUDirect Storage,以及用於TLS、IPsec 和MACsec 加密和解密的行內硬件加速等功能,為敏捷、高效能網絡解決數據傳輸問題。

69億美元收購Mellanox 之後,近兩年,輝達已研發出一種新的DPU(數據處理器)芯片,最新產品為BlueField-3 SuperNIC,將SmartNIC智能網卡整合內部。

據悉,DPU是面向基礎設施層(IaaS)的專用處理器,具備靈活可編程性。BlueField利用輝達DOCA(集數據中心於芯片的架構)軟件開發包的優勢,為開發者提供一個完整、開放的軟硬件平台。除了BlueField,輝達還有NVLink、NVSwitch等多種技術整合,從而增強數據傳輸能力。

報道引述微軟內部人士稱,當微軟在其數據中心使用輝達制造的 AI 芯片時,由於OpenAI等客戶擁有的大量數據傳輸需求,伺服器可能會過載。目前,微軟已釋出了首款Maia AI 伺服器芯片。

The information稱,微軟的網卡芯片與ConnectX-7卡類似,將其與GPU和 AI 芯片「捆綁」銷售。

AI 芯片競爭加劇,輝達真的危險了嗎?

除了微軟,亞馬遜旗下雲端運算部門AWS、Meta等科技巨頭也在自研對標輝達A100的多款 AI 芯片產品。

去年11月,AWS 推出全新基於ARM架構、自研的高效能計算伺服器CPU芯片Graviton 3E,同時釋出第五代Nitro網絡芯片硬件,借此提升雲端虛擬機器的計算效率,並支持天氣預報、基因測序等場景任務;2月5日Meta正式計劃今年部署一款新的自研 AI 芯片,即第二代自研AI芯片Artemis,預計將於2024年正式投產,以減少對輝達芯片的依賴。

如今,奧爾特曼和孫正義也加入到了 AI 算力芯片戰場。

其中,奧爾特曼已公布透過籌集8萬億美元制造 AI 芯片半導體網絡,目前正與日本軟銀集團、阿聯酋政府、美國商務部以及其他中東主權財富基金等投資者洽談,有望擴大OpenAI技術能力;軟銀創始人孫正義被曝正在籌集1000億美元研發 AI 半導體產品。

AWS高級副總裁彼得·德桑蒂斯 (Peter DeSantis) 曾表示,AWS希望客戶用新的Graviton 3E處理器執行更多工,從而獲得高效能計算能力。他認為,與購買英特爾、輝達或AMD芯片相比,亞馬遜自研芯片將為客戶提供更具性價比的算力支持。

研究公司 Dell'Oro Group 的數據中心基礎設施負責人 Baron Fung 表示,微軟和其他雲提供商「不想受制於輝達(Nvidia)生態系」。

OpenAI CEO奧爾特曼(Sam Altman)曾私下表示,與谷歌相比,OpenAI在算力上處於劣勢。

那麽,面對 AI 芯片競爭加劇局面,輝達真的危險了嗎?

輝達曾表示,微軟的網絡元件可能會蠶食其網絡器材每年超過100億美元的銷售規模。

不過,賈揚清認為,如果執行未來三年的話,Grog的硬件采購成本是1144萬美元,營運成本遠高於76.2萬美元,而8卡輝達p00 的硬件采購成本僅30萬美元,營運成本大約為7.2萬美元以內,性價比更高。

整體來看,輝達p00產品在 AI 芯片市場上仍具有很強的競爭能力。

黃仁勛2月中旬表示,每個國家都需要擁有自己的 AI基礎設施,以便在保護自己文化的同時利用經濟潛力。接下來的4到5年裏,我們將擁有價值2萬億美元的數據中心,它將為世界各地的 AI 軟件提供動力,所有 AI 技術都會加速,而輝達正取代通用計算核心,體系結構的效能將同時得到提高。

對於奧爾特曼的7萬億美元計劃,黃仁勛稱,(7萬億美元)顯然能買下所有GPU。

「如果你假設電腦不會變得更快,可能就會得出這樣的結論:我們需要14顆行星、3個星系和4個太陽來為這一切提供燃料。但電腦架構仍在不斷進步。」黃仁勛表示。

黃仁勛曾坦言,這些雲端運算廠商自研 AI 芯片是有一定理由的,主要還是服務自家的數據中心,但這不會影響輝達在全球的 AI 生態系發展。

台北時間2月22日淩晨,輝達預計將釋出2023年財報,根據該公司對上年最後一個季度的預測, 2023財年總營收將達到近590億美元,是2022財年的兩倍多。

據標普全球市場數據,蘋果公司、微軟、亞馬遜以及谷歌的母公司和Facebook的母公司——都從未像輝達一樣,在一年內從類似的起點上實作如此快的收入增長。按年收入計算,輝達將超越英特爾,成為全球第二大芯片公司。

資本市場目前猜測,輝達將預計4月當季收入達到216億美元,是去年同期的三倍。

截至發稿前,輝達市值達到1.72億美元,接近2萬億美元。據FactSet的數據,按這一市值計算,輝達股票的遠期市盈率約為38倍,比其三年平均水平低約9%。

對於3月輝達GTC將釋出B100 AI 芯片,摩根士丹利分析師Joseph Moore在一份最新報告中表示,基於早先有關該系統的一些披露,B100是「最先進技術的巨大進步」。

另外, 面對微軟、AWS的 AI 芯片競爭局面,輝達正推出自己的超算雲服務DGX Cloud,透過在數據中心內執行輝達產品,實作更大的收入規模,以對抗這些舉措。有行業人士向鈦媒體App表示,輝達內部對於DGX Cloud和輝達 A100/p00卡預期營收占比分別為20%、80%。

「AI 算力似乎無處不在。」Rosenblatt Securities分析師漢斯·莫塞曼(Hans Mosesmann)稱。

Meta公司CEO馬克·朱克伯格曾表示,構建「通用人工智能」(AGI)需要的首要條件是「世界級的計算基礎設施」。

支付寶CTO陳亮(花名:俊義)近期對鈦媒體App等表示,目前 AI 大規模套用在實施過程中,依然面臨多個「瓶頸」,包括算力成本高、硬件限制等問題。盡管GPU卡的效率已經非常高,但如何使其適應不同的技術棧(與不同技術相容)依然是一項重要難題。

阿爾特曼曾透露,OpenAI 希望保證到 2030 年都有足夠的 AI 芯片供應。

彭博在一份最新報告中預估,未來10年,生成式 AI 技術有望在硬件、軟件、服務、廣告、遊戲等領域創造1.3萬億美元收入,占科技領域總支出的10%-12%。

其中在硬件領域,基於大數據、機器學習和神經網絡演算法的AI模型訓練將會成為一個巨大市場。到2032年,其銷售規模有望達到4740億美元,年復合增長率達30%,加上 AI 推理,整個全球算力規模屆時將超過6000億美元。

(本文正選鈦媒體App,作者|任穎文、林誌佳,編輯|林誌佳)