來源:財聯社

財聯社8月29日訊(編輯 史正丞) 由AI模型即時生成遊戲的時代,已經悄然來到了我們身邊。

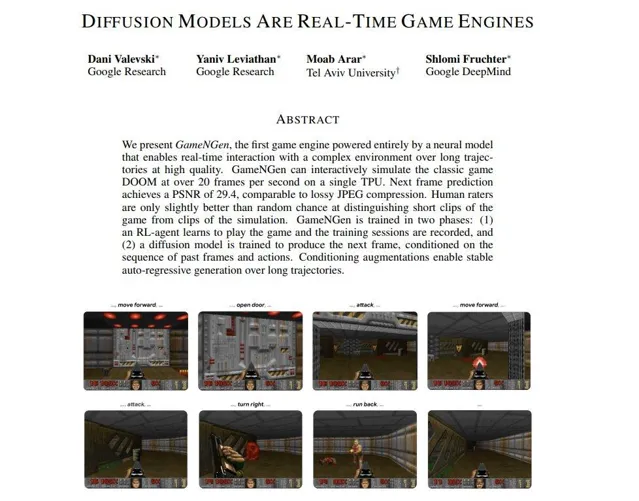

本周來自谷歌公司和特拉維夫大學的研究人員發表了一篇名為【 Diffusion模型是即時遊戲引擎 】的論文,介紹了電腦歷史上第一個完全由神經網絡模型支持的遊戲引擎GameNGen。

研究人員在論文中寫道:「 今天,電子遊戲是由人類編程的,GameNGen是遊戲引擎新範式的部份概念驗證——遊戲將會變成神經模型的權重,而不是程式碼行 。」

換一種更容易理解的說法,目前所有的電子遊戲都是預先設計好的,開發者需要編寫程式碼、準備遊戲文本和貼圖模型,然後放置在遊戲地圖上——遊戲畫面的渲染和狀態更新取決於手動編輯的規則。但GameNGen模型開啟了一個完全不同的思路: 使用AI生成模型,根據玩家的動作和反應,即時演算和生成遊戲畫面 。

在演示中,研究人員透過機器學習,讓GameNGen模型成功即時生成90時代的第一人稱射擊遊戲【淪陷戰士】。影片顯示,在AI生成的遊戲中,玩家可以在場景中轉彎、發射武器,同時能夠準確反映剩余的子彈數量、遭到攻擊後的剩余血量,以及是否滿足開啟下一個關卡所需的條件。

需要註意的是,上面看到的一系列畫面,完全是AI即時生成的影像。 最新的進展也顯示,AI模型繼成功生成文字、影像、音訊和短影片後,可能存在生成遊戲場景的能力,這對邏輯性、連貫性和即時互動的要求明顯高出一大截。

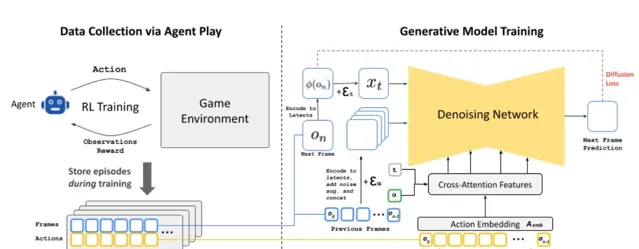

他們是怎麽做到的?

研究團隊介紹稱,為了訓練這個能即時生成遊戲的AI,首先需要訓練一個強化學習(RL)代理來玩遊戲,然後使用錄制下來的片段來訓練生成擴散模型,根據過去的畫面和玩家動作來預測接下來的畫面,這也是為什麽AI生成的遊戲能夠展現生命值和彈藥的變化,以及敵人受到攻擊的動畫。

更大的挑戰在於讓AI生成的影像保持時間和邏輯上的連貫性。為了減輕推理過程中的自回歸漂移,研究人員在訓練期間透過向編碼幀添加高斯雜訊破壞上下文幀,允許AI更正前幾幀中采樣的資訊,從而長時間保持影像生成的穩定性。

研究人員披露, 跑這個模型只需要單個TPU(谷歌自研AI處理器),就能實作每秒20幀的生成速度 。

當然,上面這幾段話也展現出GameNGen的局限性:這個AI必須依靠輸入已有的遊戲(或文字、圖片等材料)來生成遊戲。

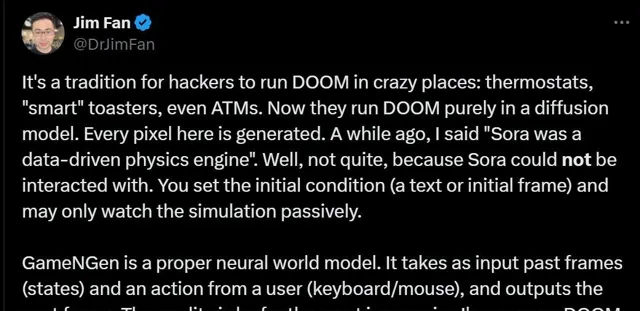

輝達高級研究經理&具身智能集團主管Jim Fan博士在社交媒體上評論稱, GameNGen更像是一個神經輻射場(NeRF),而不是一個影片生成模型。神經輻射場透過從不同角度拍攝場景的影像,從而生成場景的3D展示。但這也意味著模型不具備泛化能力,無法「想象」新的場景。這也是GameNGen與Sora的不同點:它無法生成新的場景或互動機制。

研究人員也在論文中提到這一點,解釋稱借助該技術, 未來的遊戲開發者將能透過「文本描述和範例影像」來建立新遊戲,人們將有可能僅根據範例而不是編程技能,將一組精致的影像轉化為現有遊戲的新可玩關卡或角色。

黃仁勛:5-10年內出現完全由AI生成的遊戲

由AI渲染來進行即時遊戲並不是一個全新的想法。在今年3月釋出最新一代Blackwell架構芯片時,輝達CEO黃仁勛就曾預言, 大概在5-10年內就能看到完全由AI生成的遊戲 。

事實上,朝著這個方向前進的不只是谷歌團隊, OpenAI在今年首次釋出Sora演示時,也曾展現過模擬像素遊戲【我的世界】的能力 。

最新的進展,也恰好迎合了米哈遊前董事長蔡浩宇近期引發熱議的「勸退」言論。

蔡浩宇本周公開發聲稱, AIGC已經徹底改變了遊戲開發,現在只需要時間讓這種現象完全展開 。他認為,未來只有兩種遊戲開發者具有繼續從業的意義——前0.0001%的天才,以及99%的業務愛好者創作滿足自己需求的遊戲。至於剩下的「從普通到專業」的遊戲開發者,大家還是趁早轉行吧。