最新的外媒報道透露,微軟和OpenAI正在籌劃一個宏偉的專案——「星際之門」數據中心,旨在為OpenAI提供前所未有的計算能力。

具體來看:

微軟的高層已經規劃,最早於2028年啟動這個超級計算專案。

這台超級電腦的電力需求將達到史無前例的水平。

OpenAI計劃在明年初推出它的下一個重大升級。

這個「星際之門」超級計算中心,預計將裝備數百萬個專用伺服器芯片!整個專案的預算高達1150億美元。

這筆巨額的資金,將由微軟負責支付。

據報道,「星際之門」預計在2028年推出,並將在2030年前進一步擴充套件。

而它所需的電力,可能高達5000兆瓦。

回顧一下,就在本周三,我們還報道了OpenAI使微軟電網崩潰的新聞。據悉,當時為了部署GPT-6的10萬個p00訓練集群,整個電網都發生了崩潰。

看起來,這個10萬卡集群,可能是「星際之門」早期的雛形。

而GPT-5的不斷延期,也讓人開始質疑,微軟能否在這個專案上收回成本?

當我們對比當前一些最大的數據中心,「星際之門」的成本是它們的100倍!

在未來六年內,微軟和OpenAI計劃建設的這系列超級計算設施中,「星際之門」將是最大的一個。

顯然,微軟和OpenAI對AI技術的未來充滿了信心,這將是他們在未來十年中最重要的合作之一。

但仍然存在一個問題:對於1000億美元的巨額投資,微軟真的能收回成本嗎?

之前,微軟已經向OpenAI投資了超過130億美元,以確保OpenAI能在微軟的數據中心執行ChatGPT。

作為回報,微軟獲得了存取OpenAI核心技術的許可權,並且可以獨家向雲端運算客戶(如摩根士丹利)提供這項技術。此外,微軟的Office、Teams和Bing的AI Copilot也將整合OpenAI的技術。

「星際之門」能否按計劃前進,關鍵看GPT-5的表現。

那些期待已久的GPT-4.5和GPT-5,一次次的傳聞,最終都沒成真。

這也讓OpenAI對微軟的承諾——準時交付新模型——顯得有點不靠譜。

一些人開始懷疑,AI的未來真的能預測嗎?

但是,Sam Altman站出來強烈反駁這個觀點。他認為,GPT-5發展的主要障礙,就是缺乏足夠的伺服器資源。

電力和芯片:成本驚人

如果「星際之門」成為現實,它提供的算力,將遠遠超過現在的微軟鳳凰城數據中心。

不過,這背後的電力和芯片投入也是一筆不小的開銷。

初步估算,「星際之門」要運轉起來,至少需要數千兆瓦的電力,這相當於幾個大型數據中心的電力需求。

再加上,芯片的采購成本也是一大筆開銷。

這麽巨大的投入,能得到什麽樣的回報?

答案是:人工智能的最終形態——AGI(Artificial General Intelligence)。

Digital Realty的技術長Chris Sharp指出,為了實作AGI,這種規模的投資是必不可少的。

雖然投資規模巨大、前所未有,但一旦建成,這種超級電腦的巨額成本也將被大眾接受。

AI超級計算的五個階段:朝向「星際之門」

Altman和微軟團隊將AI超算的發展分成五個階段,其中「星際之門」是最後的階段。

這個名字的靈感源自一部科幻電影,講述的是科學家發明了一種可以實作星系間旅行的裝置。

盡管OpenAI提出了這個代號,但它可能不會被微軟正式采納。

在「星際之門」之前,盡管所需資金相對較少,但仍遠超當前的數據中心建設成本。

目前,微軟和OpenAI正處於第三階段。

第四階段的超級電腦已經開工建設,預計將在2026年左右完工。

據報道,僅微軟擴建數據中心的成本就高達10億美元,最終可能達到驚人的100億美元。

而其中,計劃使用的輝達AI芯片將是主要開銷。

業內人士分析,目前建設中的以AI為核心的數據中心,其芯片成本通常占總投資的一半。

為了實作這個計劃,微軟可能需要花費超過1150億美元。這個數碼,比微軟去年在伺服器和器材上的支出多了3倍還要多。

想象一下,根據2023年下半年的數據,微軟2024年的支出預計會達到約500億美元。

Altman對算力不滿:競爭與成本上升

Altman對手頭的算力感到非常不滿。他公開表示,現有的AI伺服器芯片遠遠不夠用,甚至私下裏抱怨,谷歌在短期內的算力可能會超過OpenAI。

隨著對輝達GPU的需求激增,微軟和OpenAI這樣的大客戶,不得不面臨成本上漲的挑戰。

這也是Altman想要建立自己的公司,研發能與輝達GPU相匹敵的芯片的原因之一。

微軟的多重考慮:超越輝達

除了控制成本,微軟支持Altman開發新芯片還有其他原因。

由於GPU市場的繁榮,輝達成了重要的角色,能決定哪些客戶可以獲得更多的芯片資源。甚至輝達自己也開始提供雲服務了。

因此,「星際之門」計劃不僅是為了給微軟和OpenAI提供更多選擇,比如AMD的GPU或微軟自研的AI芯片,也是為了減少對輝達的依賴。

技術挑戰:芯片、網絡和能源

實作「星際之門」的設想,需要克服多項技術難題。

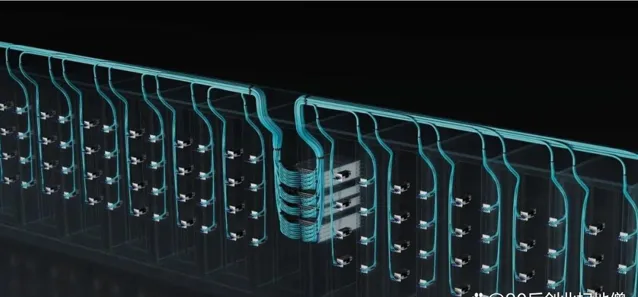

比如,一個提案是在單個機架中安裝更多的GPU,但這就需要有效的冷卻方案,以避免芯片過熱。

此外,如何連線數以百萬計的GPU,選擇合適的網絡電纜,對快速傳輸海量數據至關重要。

目前,微軟在超算中使用的是輝達的InfiniBand,但OpenAI一直在努力減少對輝達的依賴。

據說,OpenAI希望在這個專案中采用更通用的乙太網路電纜,這是為了更高效的連線和傳輸。

再說能源問題,據內部訊息,考慮到巨大的能源需求,公司可能會選擇核能作為替代能源。

不久前,亞馬遜購買了賓夕法尼亞州一個能接入核能的數據中心地塊。微軟也對這個地塊很感興趣,甚至參與了競標。

Altman認為,想要發展超級智能,可能需要在能源領域有所突破。很顯然,能源創新,在追求先進AI的道路上,將扮演關鍵角色,而核能或許是關鍵之一。

AI計算:成本高、復雜度大

AI計算與傳統計算完全不是一個量級,這就是為什麽各大公司對AI數據中心的每個細節都格外關註。GPU如何連線和冷卻,每一個小細節都可能導致巨大的成本變化。

NVIDIA的創始人黃仁勛(老黃)甚至預測,為了滿足未來AI計算的需求,全球在接下來的四到五年內,需要投資高達1萬億美元來建設新的數據中心!

至於芯片的過熱問題、網絡電纜的選擇和能源問題,短期內看起來都還沒有完美的解決方案。

「星際之門」的地理位置和構造

還有一個問題:「星際之門」會建在一個獨立的數據中心,還是由多個數據中心緊密連線而成?

它會具體建在哪裏?

這些問題目前都沒有明確答案。

但有行業人士表示,當GPU集群位於同一個數據中心時,效率會更高。

OpenAI推動微軟不斷前進演化

事實上,自從2019年向OpenAI投資以來,微軟的數據中心就在不斷地前進演化。

為了滿足OpenAI日益增長的算力需求,微軟建造了第一台包含數千個輝達GPU的GPU超算。

僅幾年時間,這台超算就讓微軟花費了12億美元。

而在今年和明年,微軟計劃為OpenAI提供的新伺服器,將包含數十萬個GPU!

下一個裏程碑:GPT-5

微軟和OpenAI的宏大抱負,這些都緊緊圍繞著OpenAI在「超級智能」領域的進展。

想象一下,如果OpenAI能解決像癌癥治療、核聚變、全球暖化或火星殖民這類大問題,那麽金主自然不會吝惜資金支持。

不過,這種級別的成就目前似乎還有些遙遠。

盡管ChatGPT和Sora已經在全球獲得了龐大的使用者群,但OpenAI如何將這些使用者轉化為顯著的收入,這個問題還待解決。這種變現可能需要比預期更長的時間。

對AI產品的銷售預期降低

也正是因為這種情況,像亞馬遜和谷歌這樣的公司已經降低了對AI產品的銷售預期。主要原因之一就是成本實在太高。而且,在大型企業中部署面向百萬使用者的套用,工作量也非常巨大。

Altman上個月表示,隨著研究人員投入更多的算力,AI模型將會變得更好,這被OpenAI稱為對話式AI的「縮放定律」。

據內部訊息人士透露,OpenAI計劃在明年初釋出下一代大型語言模型(LLM)。

在此之前,可能還會推出一些小幅改進的版本。

更多的伺服器將為OpenAI增添底氣,堅信AI模型將取得新的突破。

傳聞中的Q*和自我完善的AI

比如,有傳聞稱Q*模型能夠解決之前沒有經過訓練的數學問題,這一點在面臨人類數據即將耗盡的情況下尤為重要。

此外,還有傳聞稱,這些模型能夠辨識出現有模型的缺陷,例如GPT-4,甚至提出技術改進——換句話說,就是能夠自我完善的AI。

看來,OpenAI越來越接近實作AGI的目標了。