克雷西 發自 凹非寺量子位 | 公眾號 QbitAI

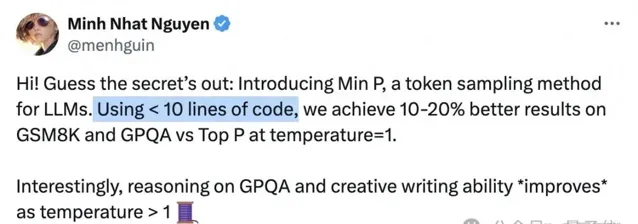

只要不到10行程式碼,就能讓大模型數學能力(GSM8k)提升20%!

幾名獨立學者提出了大模型采樣的改進方案,引起了開源社區的關註。

目前該方法已在Mistral-7B上取得成效,在Llama3-70B上的測試也正在進行。

這種方法叫做最小p采樣(min-p sampling),目的是平衡生成文本的連貫性和多樣性。

簡單說就是讓模型在不同場合發揮不同的特性,例如在事實問題上保持效能穩定,在寫作等場景中又能發揮創意。

目前該方法已在Mistral-7B上取得成效,在Llama-70B上的測試也即將進行。

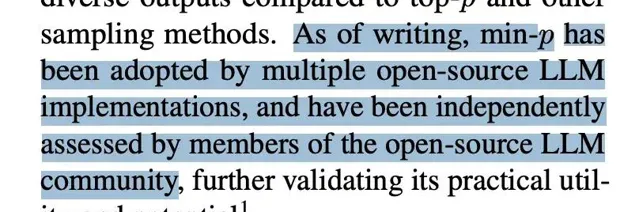

在論文中作者提到,該方法已經獲得了開源社區的廣泛套用。

同時作者還透露,Anthropic和谷歌等閉源模型廠商也已經或正在針對min-p進行測試。

訊息也得到了谷歌方面的確認,從OpenAI跳槽到谷歌的開發者社區負責人Logan Kilpatrick已經回復說「On it」(在做了)。

微軟Copilot的研究人員Abram Jackson看了後表示,這是他看到的首個有關推理過程token采樣的改進,未來還有很大進步空間。

值得一提的是,這項受到廣泛關註的研究,主要作者Minh Nhat Nguyen根本沒系統學過CS,而是靠自學成才。

在一家名為Apart Research的AI安全研究機構幫助下,Minh和團隊其他成員一起完成了該專案。

動態調整抽樣閾值

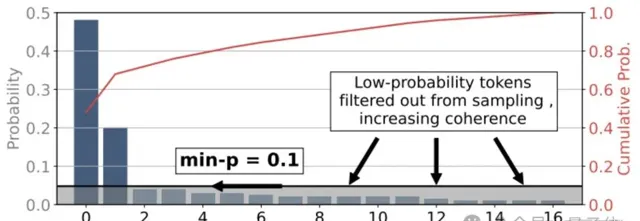

min-p是一種動態截斷抽樣方法,其核心是根據每一步token分布的最大概率,來縮放最小概率閾值。

這樣做的目的,主要在於平衡生成文本的連貫性和多樣性,特別是在temperature較高的條件下。

具體來說,min-p引入了一個基礎概率閾值p_base,表示進入采樣池的最低概率要求。

在每一步生成token時,min-p會將p_base與當前概率分布中最大的token概率p_max相乘,得到一個縮放後的絕對閾值p_scaled。

只有概率大於等於p_scaled的token,才能夠進入采樣池。

當模型對某個token的預測概率非常高(即p_max很大)時,p_scaled的值也會很高,導致采樣池大幅縮小,絕大多數低概率token被過濾,只留下少數高把握的選擇,確保了輸出的連貫性;

而當模型對所有token的預測概率都比較接近(p_max較低)時,p_scaled的值也會相應變低,放寬了對采樣池的要求,納入更多中等概率的token,給予模型更多發揮空間,生成更加多樣化的內容。

在確定采樣池後,min-p會根據temperature對token概率分布進行縮放。

它將token的對數概率除以一個溫度參數τ,並進行歸一化後,就得到了temperature縮放後的概率分布。

大於1的τ值會使概率分布更加平緩,增加低概率token被選中的機會;

τ小於1時則會使分布更加尖銳,強化高概率token的優勢。

最後,min-p從縮放後的采樣池中,按照調整後的概率分布,隨機抽取下一個token。

穩定性和創意,「我全都要」

min-p方法的效果究竟如何呢?作者使用了Mistral-7B作為基礎模型進行了測試,我們來分場景看一下結果。

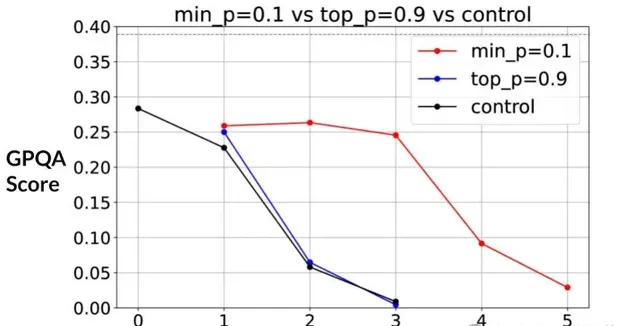

在推理任務中,作者采用了GPQA數據集。當temperature為1時,可以看到min-p相比於過去的top-p顯現出了微小的優勢。

隨著temperature增加,GPQA得分整體上呈現出了下降趨勢,但可以觀察到min-p的下降明顯比top-p更慢。

直到temperature達到3時min-p的下降趨勢才變得明顯,此時top-p的得分已接近0。

也就是說,相比於top-p,min-p在推理任務中更好地保持了所需要的穩定性。

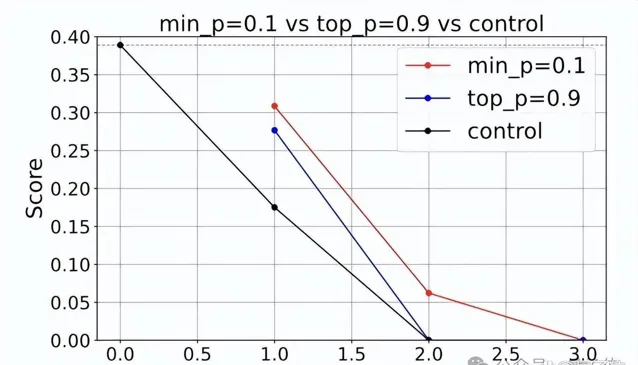

同樣需要保持穩定效能的還有數學類任務,這裏作者使用了GSM8K數據集進行了測試。

結果min-p所對應的分數隨temperature的下降比在GPQA中更快,但仍然緩於top-p方式。

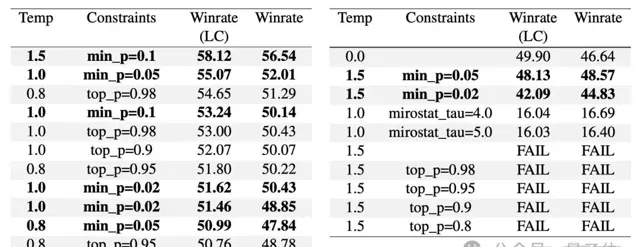

第三類任務是創意寫作,這時對穩定性的要求就不是那麽高了,而是需要模型發揮更多的創意。

這項測試使用AlpacaEval數據集完成,實驗數據是從開源社區的一名獨立評估者那裏獲得的。

實驗結果顯示,在temperature=1.5、min-p=0.1的設定下,min-p的效能尤其突出,可生成top-p方法難以生成的創意寫作內容。

在該參數下,min-p方法得到的文本獲得了58.12%的人類評判優選率,遠高於其他方法在類似設定下的表現。

論文地址:https://arxiv.org/abs/2407.01082GitHub:https://github.com/menhguin/minp_paper/參考連結:https://x.com/menhguin/status/1826132708508213629