隨著AI技術和相關套用的不斷發展,大模型、大數據和AI計算能力在AI發展中的重要性日益凸顯。大模型和數據集構成AI研究的軟件基礎,而AI算力是關鍵的基礎設施。在本文中,我們將探討AI發展對數據中心網絡架構的影響。

Fat-Tree數據中心網絡架構

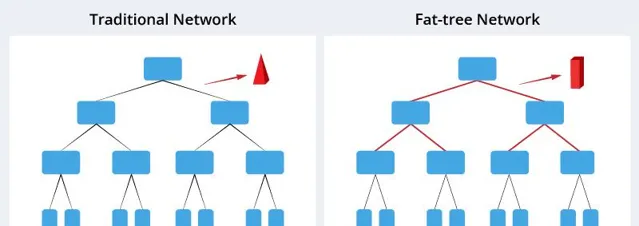

隨著AI大模型訓練在各個行業的廣泛套用,傳統的網絡無法滿足大模型集群訓練的頻寬和延遲要求。大模型分布式訓練需要GPU之間的通訊,且其流量模式與傳統雲端運算不同,這增加了AI/ML數據中心的東西向流量。短期和高量的AI數據導致傳統網絡架構中的網絡延遲和訓練效能降低。因此,為了滿足短期和高量數據處理需求,Fat-Tree網絡的出現是必然的。

在傳統的樹狀網絡拓撲中,頻寬逐層匯聚,樹的底部網絡頻寬遠小於所有葉節點的總頻寬。相比之下,Fat-Tree看起來像一棵真正的樹,靠近根部的分支更粗。因此,網絡頻寬從葉到根部逐漸增加,提高了網絡效率並加速了訓練過程。這是Fat-Tree架構的基本前提,可以實作非阻塞的網絡。

數據中心網絡速率升級演進

隨著數據中心套用復雜性的不斷提高,對網絡速度的需求也在不斷增長。從過去的1G、10G和25G到如今廣泛使用的100G,數據中心網絡升級和演進的速度正在加快。然而,面對大規模的人工智能工作負載,400G和800G傳輸速率已成為數據中心網絡演進的下一個關鍵行程。

AI數據中心推動400G/800G光模組的發展

400G/800G光模組需求不斷增長的原因

大規模數據處理需求

AI演算法的訓練和推理需要大量的數據集,因此,數據中心必須能夠高效處理大量數據的傳輸。800G光模組的出現提供了更大的頻寬,有助於解決這個問題。升級後的數據中心網絡架構通常包括兩個層級,從交換機延伸到伺服器,其中400G作為底層。因此,升級到800G也會推動對400G的需求增長。

即時需求

在某些AI套用場景中,對即時數據處理的需求至關重要。例如,在自動駕駛系統中,傳感器生成的海量數據需要快速傳輸和處理,最佳化系統延遲成為確保及時響應的關鍵因素。高速光模組的引入透過降低數據傳輸和處理的延遲,迅速滿足這些即時需求,從而提高系統的響應能力。

多工並行

現代AI數據中心通常需要同時處理多個任務,包括影像辨識和自然語言處理等活動。采用高速800G/400G光模組可以增強對這種多工工作負載的支持。

400G/800G光模組市場前景廣闊

目前,400G和800G光模組的需求尚未出現顯著增長,但預計2024年將受到AI計算需求增長的推動出現明顯提升。據Dell'Oro預測,2024年400G光模組的需求將有所增加。AI、大數據和雲端運算驅動的高速率數據傳輸需求日益增長,有望加速800G光模組市場的增長。這一趨勢凸顯了800G/400G光模組市場的光明前景,在應對先進計算套用不斷變化需求的過程中,其套用將逐步增多。

典型數據中心的400G/800G光模組解決方案

該圖展示升級至 800G數據中心 的解決方案。飛速(FS) QDD-FR4-400G光模組 和 QDD800-2FR4-C1光模組 在骨幹層中的MSN4410-WS2FC交換機和核心層中的高效能800G交換機之間形成高頻寬鏈路,以400G介面速率執行。

由於這些光模組采用高密度的QSFP-DD封裝,可在高密度配置中部署。這增加了傳輸容量並提供了更大的頻寬速率。此外,透過采用PAM4調制和重定時技術,這些光模組實作了更快的數據傳輸速率,同時顯著降低了延遲,改善了整體系統效能。

800G/400G光模組新時代

隨著對更快、更高效數據傳輸需求的不斷增長,800G/400G光模組的時代已全面來臨。這些光模組以其出色的頻寬能力、LPO技術的進步和經濟效益而備受青睞,有望改變AI領域並重新定義數據中心。利用高速光模組,完全開發和訓練AI已不再只是構想。