明敏 發自 凹非寺

量子位 | 公眾號 QbitAI

超逼真的機器人小鎮來了!

在這裏,機器人可以像人一樣在超市裏購物:

買菜回家做飯:

在辦公室裏接咖啡(旁邊還有人類同事):

不只有人形機器人,機器狗、臂式機器人也在這個「城市」裏穿梭自如。

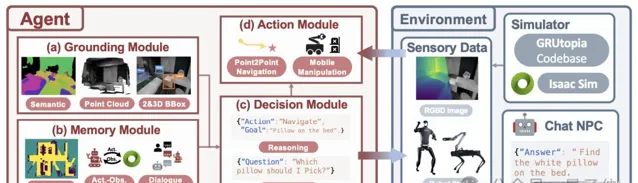

這就是由上海AI實驗室最新提出的首個模擬互動式3D世界:GRUtopia

(中文名:桃源)。

在這裏,由多達100k

個互動式、帶精細註釋的場景自由組合成逼真城市環境。

包含室內室外,餐廳、超市、辦公室、家庭等89個

不同場景類別。

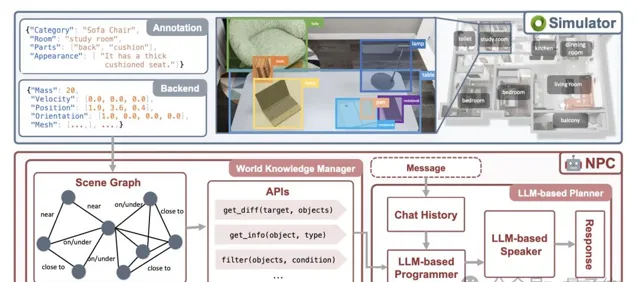

由大模型驅動的NPC

,可以在這個世界裏和機器人對話互動。

這樣一來,各種機器人能在虛擬小鎮裏完成各種行為模擬,也就是最近流行的Sim2Real路線,能大幅降低具身智能現實世界數據收集難度和成本。

該專案計劃開源,現階段在GitHub上已提供demo安裝指南。

安裝成功後,就能在demo裏控制一個人形機器人在房間內活動,並支持調整不同視角。

機器人的虛擬桃源

其核心工作共有三項:

GRScenes

GRResidents

GRBench

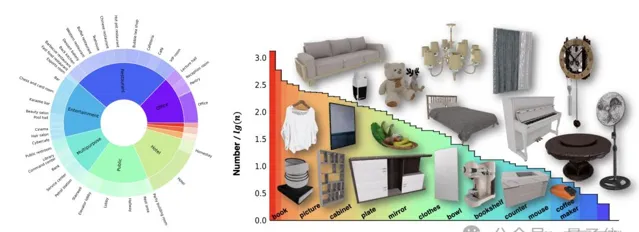

其中,GRScenes是一個包含大規模場景數據的數據集。

它極大程度上擴充套件了機器人可以活動和操作的環境範圍,此前的工作更聚焦於家庭場景。

該研究表示,他們的目標是將通用機器人的能力擴充套件到各種服務場景,比如超市、醫院等。同時覆蓋室內室外環境,包括遊樂園、博物館、展覽館等。

對於各個場景,他們都進行了精細高質素建模,100 個場景包含 96 個類別的 2956 個互動式物體和 22001 個非互動式物體。

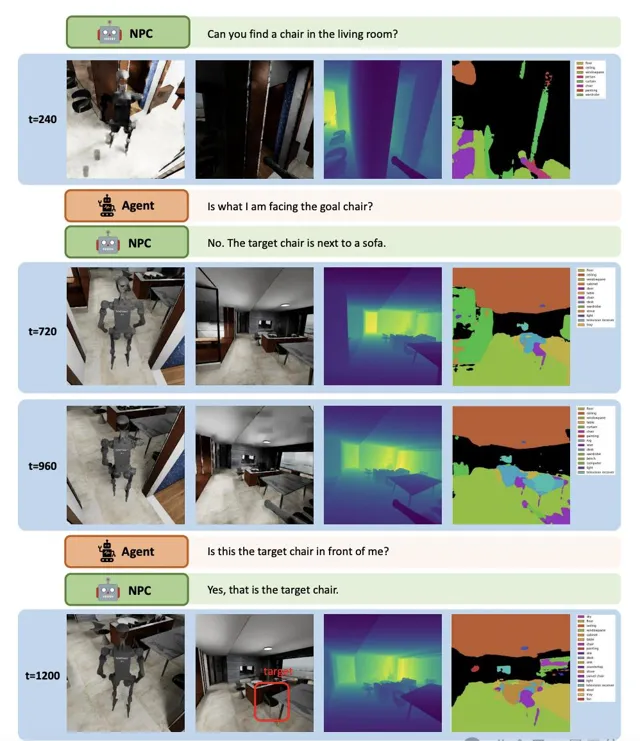

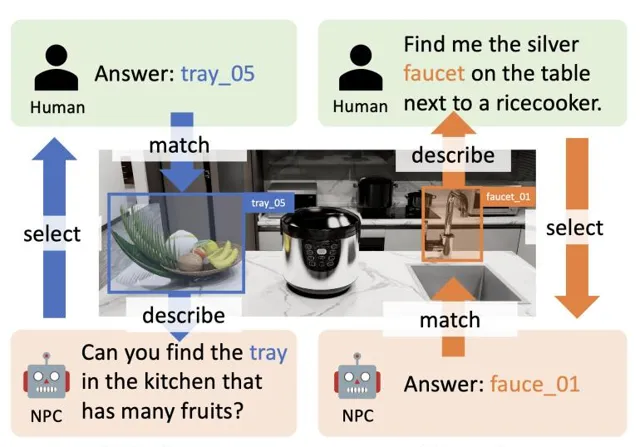

GRResidents是一個NPC系統。

它由大模型驅動,同時對模擬環境中的場景資訊非常了解。因此NPC可以推斷物體之間的空間關系,參與動態對話和任務分配。

借助於這個系統,GRUtopia可以生成海量場景任務供機器人完成。

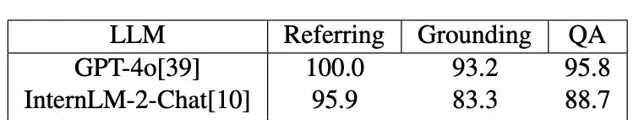

透過與人類進行交叉驗證,NPC系統在描述和定位物件上的準確率都不錯。

在描述實驗中,讓NPC系統隨機選擇一個物體進行描述,人類能找到對應物體就算成功。

在定位實驗中則反過來,如果NPC系統能根據人類給出的描述找到對應物體就算成功。

呼叫不同大模型的成功率不盡相同,綜合來看GPT-4o的表現最好。

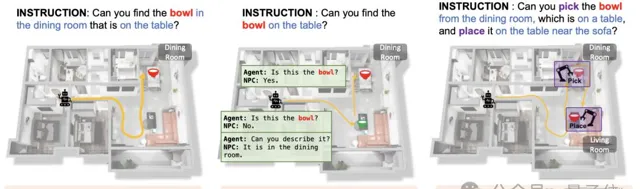

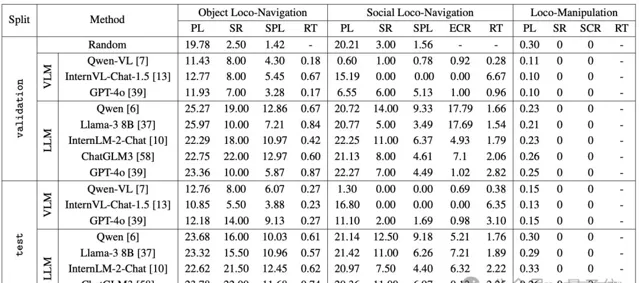

GRBench是一個評估具身智能表現的benchmark。

它包含3個基準,涉及目標定位導航(Object Loco-Navigation)、社交定位導航(Social Loco-Navigation)和定位操作(Loco-Manipulation),這三種評估的難度逐漸遞增。

為了分析NPC和控制API的效能,研究提出了基於LLM和VLM的基線,以驗證基準設計的合理性。

實驗結果表明,與隨機策略相比,在所有基準測試中,使用大型模型作為後端代理的表現都更好。

而且Qwen-VL在對話上的表現超過了GPT-4o

。

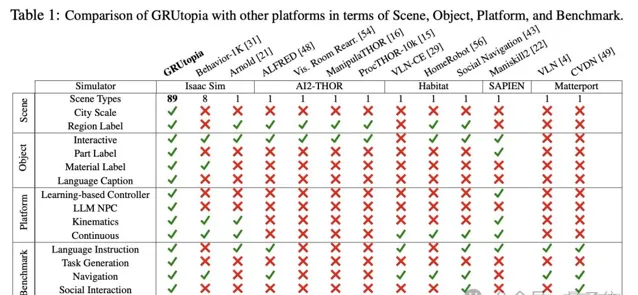

最後整體對比來看,GRUtopia其他平台在各個維度上都更強大。

該研究工作由上海人工智能實驗室OpenRobot Lab領銜。

該實驗室聚焦研究具身通用人工智能,致力於構建軟硬虛實一體化的通用機器人演算法體系。

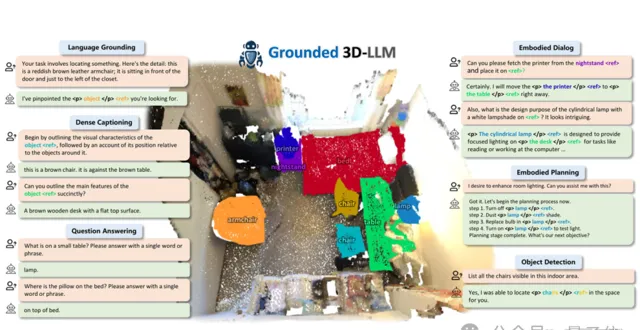

今年5月,該團隊還釋出了具身多模態大模型Grounded 3D-LLM,能夠自動化生成物體到局部區域的場景描述與具身對話數據,有效緩解了目前三維場景理解的局限性。

論文地址:

https://arxiv.org/abs/2407.10943

GitHub地址:

https://github.com/openrobotlab/grutopia?tab=readme-ov-file