本文主要轉譯自Interconnects文章【OpenAI’s Sora for video, Gemini 1.5's infinite context, and a secret Mistral model】,原文作者Nathan Lambert

昨天是AI發展的其中一天,但似乎所有事情都同時發生。簡而言之,你需要了解這些內容:

- OpenAI 釋出了他們的影片生成模型 Sora。它非常出色。

- 谷歌釋出了 Gemini 1.5 Pro,效能接近 1.0 Ultra,並且文本長度幾乎無限(最多可達 1 千萬tokens)。

- 在ChatBot Arena平台中發現了一個名為 Mistral-Next 的模型,暗示其即將釋出。初步測試表明,它至少是一個可靠的模型。

這篇文章將盡量從技術角度總結已知的情況。

Sora:OpenAI 的文生影片模型

我們早就知道它會出現,但還是被它的出色表現震驚了。你需要看一些人工智能生成的影片。OpenAI 釋出了 Sora,山姆·柯曼花了一整天時間在推特上分享其神奇世代的影片。當天晚些時候,OpenAI 釋出了一篇技術性稍強的博文,證實了人們所關註的大部份傳言。

簡而言之,Sora 是視覺轉換器(ViT)和擴散模型的組合。視覺轉換器和 Sora 數據處理背後的核心理念似乎是將影片片段嵌入一個名為 "patch"的潛在空間,然後將其作為一個token。

引自 OpenAI 網誌:

Sora 是一個擴散模型;在輸入雜訊patches(以及文本提示等條件資訊)的情況下,經過訓練,它可以預測原始的 "幹凈 "patches。重要的是,Sora 是一個擴散變換器。變換器在語言建模、電腦視覺和影像生成等多個領域都表現出卓越的擴充套件特性。

在這項工作中,我們發現擴散變換器作為影片模型也能有效擴充套件。

Lambert認為,博文中提到了很多有趣的東西,但都不是真正重要的東西,比如模型大小、架構或數據。數據幾乎肯定是一大堆YouTube和一些程式化生成的影片(來自遊戲引擎或其他自訂的東西,稍後詳述)。需要知道的事情:

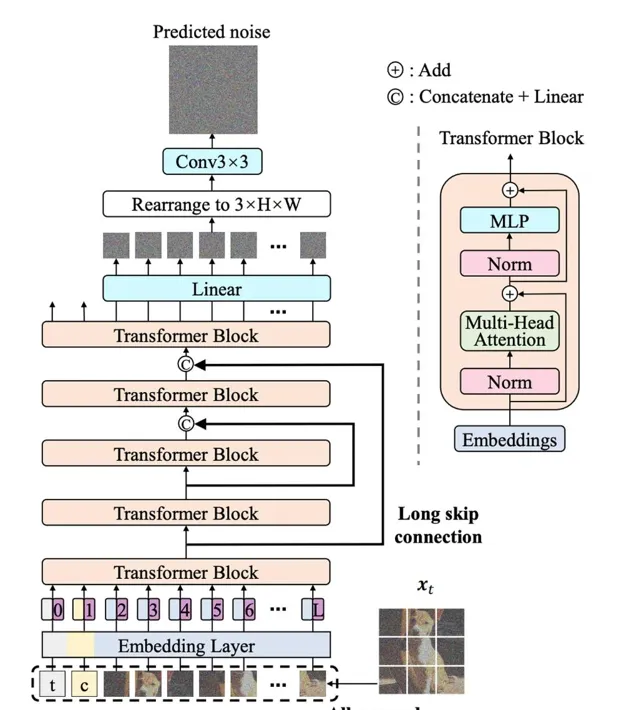

推特上的一個ML 的匿名賬戶挖出了一篇類似架構的論文,架構圖如下。

Sora 最令人印象深刻的特點是它能夠逼真地模擬物理世界 (OpenAI 將其描述為 "新興的模擬能力")。在此之前,還沒有任何文生影片模型能與之相媲美。幾周前,谷歌的 Lumiere 剛剛問世 ,給人留下了深刻印象,但與 Sora 相比,它顯得非常遜色。

有很多傳言說,神經輻射場(NeRFs)是一種流行的影像 3D 重構技術,它可能會根據影片的特征(就像物理世界一樣)在引擎蓋下使用,但我們沒有明確的證據證明這一點。Lambert認為,這是程式生成的遊戲引擎內容。僅僅使用遊戲是不夠的,你需要一種生成數據多樣性的方法,就像所有合成數據一樣。我們在 HuggingFace 為 RL 代理構建的數據就是一個很好的例子。數據的多樣性可能會在生成過程中釋放出另一個層次的效能——我們在大型模型中經常看到這種情況。

所有關於 Pika 和 Runway ML(其他流行的 ML 影片初創公司)死亡的評論都完全是誇大其詞。如果進步的速度如此之快,那麽我們還有很多轉彎。如果最佳模型來得快去得也快,那麽最重要的就是使用者接觸點。這一點在影片領域還沒有建立起來,而且,MidJourney 還在依賴 Discord(不過,使用者體驗還很不錯)!

Gemini1.5:谷歌的有效無上限文本長度

在 Sora 釋出前幾個小時,谷歌已經釋出了 Gemini 的下一個版本,令所有人震驚。這可能會給人們使用 LLMs 的方式帶來的直接變化,可以說比 Sora 影片更有影響力,但 Sora 的視覺演示質素令人著迷。

總結:

谷歌可能找到了某種新方法,將長上下文的架構理念與他們的 TPU 計算堆疊相結合,並取得了很好的效果。 據 Gemini 長語境的負責人之一Pranav Shyam說,這個想法幾個月前才剛剛萌芽。如果以小版本(v1.5)而不是 v2 釋出,肯定會有更大的發展空間。

作為一個思想實驗,圍繞 Gemini 1.5 的交流告訴你,你可以在模型的上下文中包含整個生產程式碼庫(參見 Google 提供的範例)。這對於那些還沒有流行到會為下一個 GPT 版本而被搜刮成百上千次的庫來說,確實能改變它們的命運。作為一款企業工具,它價值連城。他們將一千萬個tokens視覺化為多少內容,這可是一大筆財富。想想 3 小時的影片或 22 小時的音訊在沒有分割或損失的情況下被一個模型處理。

需要明確的是,付費的Gemini使用者很快就能使用 100 萬文本長度(類似於 ChatGPT plus 計劃),而技術報告中也提到了 1000 萬視窗。Lambert認為,目前保留它更多的是出於成本考慮。任何模型的計算量都很大。

這個關於上下文長度的數碼讓我傷透了腦筋。最長的上下文視窗更精確。

看到這一點,我們就會明白,這個模型並不是一個變形器。它有辦法透過非註意力模型路由資訊。很多人提到了 Mamba,但更有可能的是谷歌利用最佳化的 TPU 程式碼實作了自己的模型架構。Mamba 附帶特殊的 Nvidia 內核和整合。

Lambert對此感到非常興奮,因為在未來,我們與之互動的模型會將計算分配給專門從事不同任務的子模型。Lambert預計,如果我們看到 Gemini 1.5 Pro 架構圖,它會更像一個系統,而不是普通的語言模型圖。這就是研發階段的樣子。

著名的快速工程師Riley Goodside曾分享過這種類別的變化:

這裏有很多含義。既然可以 100K-shot,為什麽還要[監督微調]?如果有了語法和字典,它就能轉譯Kalamang語,那麽正確的詞語又能教會它什麽呢?

從根本上說,這意味著我們現在可以直接告訴模型如何在上下文中行動。微調不再需要能力。Lambert認為,這將會產生協同效應,而且當推理達到一定規模時,微調的成本會更低,但這還是令人興奮的。

更多資訊,請參閱谷歌Gemini 1.5 網誌文章或技術報告。

最後,Perplexity 公司的行政總裁在接受采訪時說,谷歌把他想聘用的人的待遇提高了四倍。這太瘋狂了,我不知道這對谷歌來說是看漲還是看跌的訊號。

Mistral-next: 另一種有趣的釋出方式

如果這還不夠的話,在 LMSYS 競技場上,還有另一款 Mistral 型號在偷偷地聊天。我聽說過另一款機型即將推出的傳言,但這款機型顯然更加真實。基本測試表明它是一款強大的機型。當然,Twitter 的暴民們現在會去舉辦更多的 vibes-evals 活動,但 Mistral 會很快告訴我們的。我猜這就是他們基於 API 的 GPT4 競爭對手。

原來它是一周前添加的,所以隱藏得很好。