近日,第三屆清華大學汽車芯片設計及產業套用研討會暨校友論壇在蕪湖成功舉行。作為本次活動的特邀嘉賓,超星未來聯合創始人、CEO梁爽博士出席並行表主題演講【軟硬件協同最佳化,賦能AI 2.0新時代】。

大模型是AI 2.0時代的「蒸汽機」

AI+X套用落地及邊緣計算將成為關鍵

自ChatGPT釋出以來,大模型引爆「第四次工業革命」,成為AI2.0時代的「蒸汽機」,驅動著千行百業智能化變革。保爾·芒圖曾說:「蒸汽機並不創造大工業,但是它卻為大工業提供了動力」,大模型也是如此,本身不會直接創造新的產業,而是與已有的行業套用場景及數據結合創造價值。

WAIC 2024落幕後,有媒體評論:大模型再無新玩家,AGI下半場是計算與套用。梁爽認為,AGI下半場將是AI+X套用落地和邊緣計算。AI 1.0時代,伺服器側的神經網絡模型,在安防、智能駕駛等套用領域裏逐步下沈到邊緣端,這一趨勢也一定會在AI 2.0的時代再演繹一次,並且將在智慧城市、汽車、機器人、消費電子等領域創造出更為廣闊的增量市場。

回顧AI的演進歷史,可以看到,AI1.0時代的主要模式是透過單一模型完成單一任務,例如安防、人臉辨識、語音辨識,以及基於感知-決策-控制分模組的智能輔助駕駛方案。梁爽認為,現在正進入一個「AI1.5時代」,在智能駕駛、機器人等復雜系統中,統一用神經網絡完成各個模組功能的實作,盡量減少人工規則,並透過數據驅動的範式提升效能,大幅降低人工處理各種長尾問題的難度。在AI2.0時代,系統將由一個統一的通用基礎大模型來應對多源數據輸入,完成多種復雜任務,這一基礎模型應該具備感知萬物、知曉常識和理解推理的能力,智能駕駛、機器人的基礎模型本質上是同一類基礎模型。

端到端與大模型上車進行時

智能汽車是邁向通用機器人的必要階段

近年來,智駕系統正在從傳統的單傳感器CNN感知,逐步升級到多傳感器CNNBEV,基於Transformer的BEV和Occupancy方案,並正在向端到端大模型演進。隨著規控部份逐步模型化,中間沒有規則介入,因而在海量高質素數據驅動下,效能天花板會大幅提升,並大幅降低了應對長尾問題的人工參與度,使得軟件工程量最多可下降99%。此外,視覺大模型的上車,幫助智駕系統進一步增加了對物理世界復雜語意的理解,使駕駛的行為更接近於人,提升了對未知場景的泛化處理能力。

梁爽指出,智能汽車將是未來邁向通用機器人的一個必要階段,例如TESLA的Optimus機器人和智能汽車采用了同樣的FSD平台,並且在系統設定、功能任務上相同。雖然兩者的系統組成和叠代升級高度相似,但機器人的維度更高、任務更復雜,大模型下沈部署到邊緣側的器材裏,形成一個「Robot-Brain」,會成為行業發展的關鍵。

大模型落地邊緣側存在較大挑戰

軟硬件協同最佳化是現實可行的落地路徑

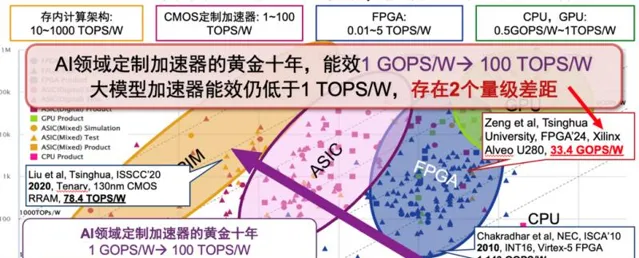

過去十年被稱為AI加速器的黃金十年,CNN加速器的能效已經提升到了100TOPS/W級別。大模型的規模以及參數增長速度遠超CNN時代,大幅超出了傳統計算硬件的增長速度。而當前大模型的處理器能效仍小於1TOPS/W,與邊緣側套用需求存在兩個數量級的差距,嚴重限制了大模型的落地。

(摘選自汪玉教授發表於2024年1月的報告【端側大模型推理,智能芯片的現狀與展望】)

目前很多手機端本地部署的2B以內的「小」模型,在套用到邊緣側場景時,通常會出現歷史資訊遺忘等能力限制,而需求量更大、效果顯著提升的7B量級以上的大模型,通常難以部署到現有的邊緣側芯片上,主要原因包括:(1)傳統架構矩陣算力缺口明顯,大模型中50-80%算力需求在Attention層中的各類矩陣計算,並且KV矩陣有明顯稀疏性,需要專項支持;(2)大模型的參數量和頻寬需求巨大,單7B級別的浮點模型就需要28GByte的儲存空間,且權重的局域性比較低,所以大模型計算處理的過程需要頻繁地對外存進行讀取,每個Token的頻寬需求都會大於10GB/s;(3)當前架構精度類別不足,計算精度傳統的CNN網絡通常可以用INT8實作較好的處理效果,而大模型中的各類算子會需要諸如INT4/FP8/BF16等不同精度的計算支持,並且像啟用層、Norm層等的數據動態範圍大,導致很多已有的量化演算法也不能很好地支持。

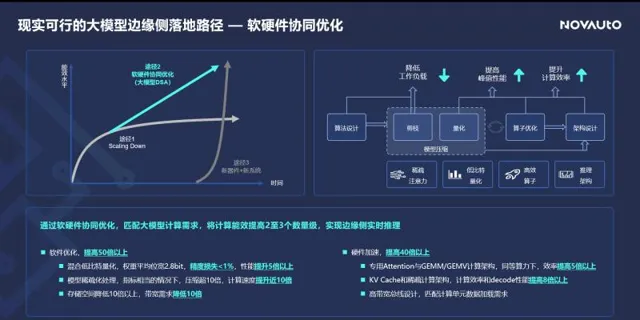

從提升大模型在邊緣側處理能效的方法來看,一種是透過提升工藝水平scaling down,但受摩爾定律和國際形勢的影響,很難再繼續持續;另一種是透過新器件和新系統,但套用的成熟度還有待技術上的進一步提升與完善。但在當下來看最為現實的實作手段,就是針對大模型套用來做軟硬件協同最佳化,軟件上透過新的混合量化方法以及稀疏化處理,硬件上則針對大模型中常見的演算法結構進行加速設計,從而整體上實作2-3個數量級的能效提升。

針對大模型任務新需求深度最佳化

超星未來實作邊緣側AGI計算行業領先

超星未來主要面向各類邊緣智能場景,提供以AI計算芯片為核心、軟硬件協同的高能效計算方案,致力於成為邊緣側AGI計算的引領者。

「平湖/高峽」NPU : 團隊十年磨一劍,實作效能行業天花板

針對智能駕駛及大模型所需要的神經網絡計算任務,超星未來自研了高效能AI處理核心「平湖」和「高峽」。「平湖」NPU主要針對以CNN和少量Transformer的感知類任務提供高效的計算,「高峽」NPU則是面向高階智駕以及大模型的即時處理專門設計的加速核心。

其中「平湖」NPU針對主流CNN/Transformer模型的推理延遲以及幀率均為行業最領先水平,與某款市場上被廣泛認可的競品相比,單位算力的推理幀率在CNN任務上提高10倍,Transformer任務提高25倍。

「高峽」NPU架構采用了混合粒度的指令集設計,單Cluster可實作40TOPS算力,支持INT4/INT8/FP8/BF16多種不同計算精度,並且在內部緩存設計上做了最佳化設計,另外針對Sparse Attention和三維稀疏摺積,設計了專用的加速結構。透過這些最佳化設計,「高峽」NPU實作了對典型的生成式大模型的即時計算支持,LLaMA3-8B生成速度最高可達60tokens/s。此外,「高峽」NPU可以用相較NVIDIA Orin芯片1%的計算邏輯面積,來實作近乎等同的三維稀疏摺積處理速率。

「驚蟄」系列芯片 : 已於多領域批次落地,最新產品實作大模型邊緣側即時計算

基於自研的NPU核心,超星未來在2022年底釋出了邊緣側AI計算芯片「驚蟄R1」,NPU算力為16TOPS@INT8,典型功耗僅7-8W,從而可以支撐起各類系統方案的自然散熱設計。「驚蟄R1」目前已在汽車、電力、煤礦以及機器人等領域實作了批次落地。

超星未來也即將釋出「驚蟄」系列下一代芯片,可實作對大模型的即時處理,在12nm制程下將等同於驍龍8Gen3、天璣9300等SOTA手機芯片的處理效果。按照超星未來的芯片產品發展路徑圖,公司將繼續保持產品矩陣的可延伸性,從邊緣感知到智駕升級,逐步邁向「Robot-Brain」。

「魯班」模型部署工具鏈 : 整合大模型最佳化新方法,軟件協同實作40倍效能提升

在高效硬件架構的基礎上,超星未來面向神經網絡套用打造深度最佳化的「魯班」工具鏈,可使邊緣側推理速度提高40倍以上,具體包括:

(1)業內領先的混合精度量化工具 ,支持PTQ/QAT/AWQ功能,支持INT4/INT8/FP8/BF16精度,量化損失小於1%;

(2)高效模型最佳化工具 ,支持敏感度分析、蒸餾、Lora,在精度損失小於1%的情況下,模型壓縮率超10倍;

(3)高效能編譯工具 ,提供豐富的計算圖最佳化技術及面向異構核心的高效指令排程,推理效率可提高4-5倍以上。

特別針對大模型任務,「魯班」透過特有的稀疏離群點保持和混合位寬量化的方法,可將權重位寬下探到平均2.8bit。基於稀疏掩膜的方法,可實作在模型處理能力相當的情況下,將LLaMA3-8B壓縮90%以上,大幅縮減了模型的參數和計算量。

「倉頡」數據閉環平台 : 實作數據自動化生產,構建套用叠代閉環

在大模型時代,高質素演算法叠代需要功能強大的數據閉環工具。因此超星未來打造了「倉頡」平台,包括數據管理、資料探勘、數據增強、真值生產、模型生產和演算法評測等功能,並且在多個環節都套用了大模型來提供功能上的增強。

基於該平台,透過構建完整流程,客戶可以從環境中獲取有效數據,並盡可能降低人工的參與程度,實作自動的資料探勘和標註,從而助力客戶實作數據驅動演算法的叠代。目前「倉頡」平台已為車企、Tier1等客戶提供了服務,同時也在延伸為機器人客戶提供支持的能力。

腳踏實地,快步向前

為客戶提供高效的「AI+」

基於團隊在AI領域十余年的研發與實踐經歷,超星未來緊跟AI 1.0到AI 2.0的發展路徑,不斷打磨核心產品,實作AI+X套用落地。

在邊緣側場景,超星未來已在電力、煤礦等泛安防領域實作了芯片產品的批次落地,實作了規模化的營收回報,並透過落地,持續叠代產品相關生態,形成對智能駕駛與AGI等長周期方向的反哺。「在當前惡劣的市場環境下,實作快速的落地才是生存的王道。」

在智能駕駛場景,「驚蟄」系列芯片可支持多維智駕解決方案,如智能前視一體機、雙目前視方案、5-7V高性價比行泊一體、11V1L高效能行泊一體等,並涵蓋主流的行車、泊車以及智能駕駛和機器人通用的雙目功能。相關產品的參考解決方案已基於實車完成了打通和工程最佳化。目前,超星未來已與某行業頭部商用車OEM合作上車,同時與多家乘用車OEM客戶達成業務合作,預計最早於2025年實作批次上車。

在邊緣側大模型推理場景,基於「魯班」工具鏈的軟硬件協同最佳化能力,超星未來最新芯片產品在驗證平台上實測ChatGLM-6B可以達到超過15tokens/s的生成速度,10W量級的芯片即可支持高效能大模型的邊緣落地;「高峽」NPU平台Stable Diffusion 1.5版本可以在3.5s內完成圖片生成。基於以上能力,超星未來已與行業頭部的機器人客戶、大模型廠商等達成合作。

道阻且長,行則將至

共同構建AI 2.0新時代

「我們對技術發展的預估和意識通常是低估和滯後的,技術的發展一旦突破某個閾值,就會爆炸式地增長、覆蓋,比如從ChatGPT的釋出到現如今的‘千模大戰’。不論是高階的智能駕駛,還是通用機器人套用,只要技術範式是正確的,人員與資金持續投入,‘ChatGPT時刻’就一定會到來,而且這個時刻或許會比我們想象得來得更快。」梁爽表示,「超星未來期待與各位合作夥伴攜手,從AI 1.0時代逐步邁進,共建AI 2.0的新時代。」