最近這兩年,隨著AIGC大模型的崛起,整個社會掀起了一股強勁的AI浪潮。

人們在關註AI,企業在擁抱AI,資本在追逐AI。凡是和AI有關的概念,都會吸引大量的目光。

那麽,AI是如何一步一步走到今天的呢?它經歷了哪些發展階段,又發生過哪些精彩的故事?

今天這篇文章,我們就來仔細回顧一下,人類AI的發展歷程。

█ 萌芽階段

人類對人造智能體的追求和暢想,最早可以追溯到古希臘時代。

在古希臘神話中,火與工匠之神赫菲斯托斯,曾經制作了一組金制的女機器人,「有心能解意,有嘴能說話,有手能使力,精通手工制造」。

在中國的古代史籍中,也出現過「人工智能」的影子。

【列子·湯問篇】中,偃師向周穆王進獻了一個機械人,會唱歌、會跳舞,還會挑逗

周

穆王的嬪妃。周穆王醋意爆發,認為機械人是真人假扮,要殺掉偃師。偃師趕緊將機械人拆散,周穆公才罷休。

上面的這些文字記載,顯然都不靠譜。在遙遠且漫長的古代,以人類當時的技術水平,肯定是造不出智能體的。能造出一些簡單的機械(例如諸葛亮的木牛流馬),都已經很了不起了。

人們對智能體的寄望,很多都依托於鬼神等宗教信仰——將人的靈魂附身於機械,才能夠實作「人工智能」。

到了近現代,隨著工業革命的爆發,人類開始逐漸進入機械計算、電氣計算時代。計算能力的不斷增長,使得透過「算力 」 來驅動「智能」,成為一種可行選項。

17世紀,萊布尼茨、杜文·霍布斯和笛卡兒等率先提出:是否可以將人類理性的思考系統,轉化為代數學或幾何學體系?

萊布尼茨認為:「人類的思想,可以簡化成某種運算。 」

霍布斯也提出:「推理就是計算。」

這些偉大的思想,為後來的電腦和人工智能發展指明了方向。

再後面的事情,大家都比較清楚了——

在卓思·巴貝奇(Charles Babbage)的分析機、赫爾曼·何樂禮(Herman Hollerith)的制表機、 阿蘭·圖靈(Alan Turing)的圖靈機,以及Z3、珍納機、Mark I、ENIAC等一系列發明的接力推動下,人類終於進入了數碼電子電腦時代,也開啟了波瀾壯闊的資訊科技革命。(不清楚的,看這裏: 算力簡史 )

█ 第一次高潮階段 (1950年-1973年)

圖靈測試

數碼電子電腦正式誕生之後,很快就有科學家開始探索,是否可以透過電腦來實作「智能」。

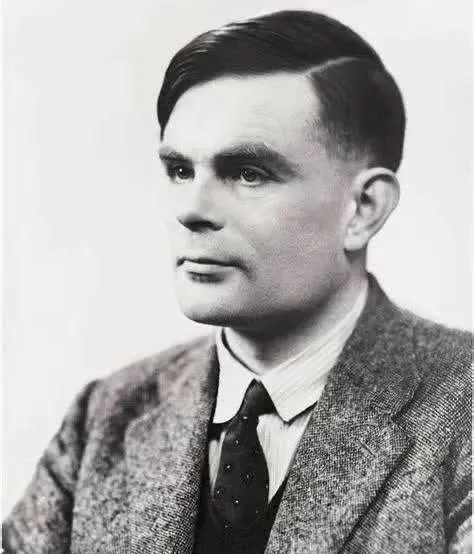

1950年,阿蘭·圖靈在【心靈(Mind)】雜誌上發表了一篇非常重要的論文,名叫【電腦器與智能(Computing Machinery and Intelligence)】。

阿蘭·圖靈(1912-1954)

在論文開頭,他就提出了一個靈魂之問:

「I propose to consider the question, ‘Can machines think?’"

「我提議思考這樣一個問題:‘機器可以思考嗎?’」

圖靈在論文中仔細討論了創造「智能機器」的可能性。由於「智能」一詞很難定義,他提出了著名的圖靈測試(以下為大致意思):

「一個人在不接觸對方的情況下,透過一種特殊的方式和對方進行一系列的問答。如果在相當長時間內,他無法根據這些問題判斷對方是人還是電腦,那麽,就可以認為這個電腦是智能的。 」

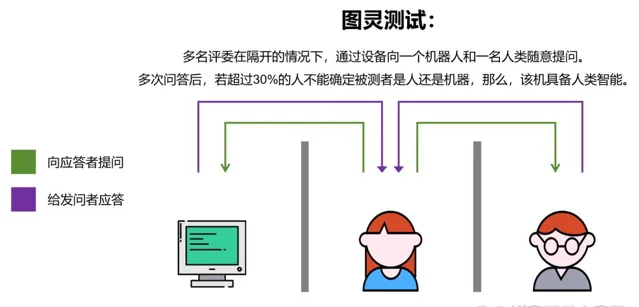

圖靈測試

圖靈的論文,在學術界引起了廣泛的反響。越來越多的學者被這個話題所吸引,參與到對「機器智能」的研究之中。其中,就包括達特茅斯學院的年輕數學助教約翰·麥卡錫(J. McCarthy),以及哈佛大學的年輕數學和神經學家馬文·明斯基(M. L. Minsky)。

達特茅斯會議

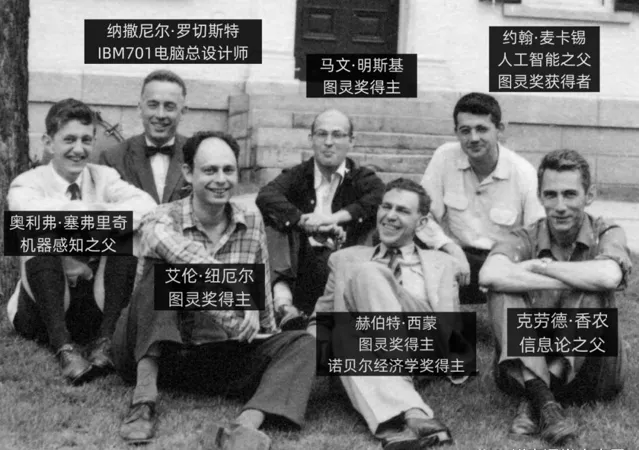

1955年9月, 約翰·麥卡錫、馬文·明斯基、克勞德·山農(C. E. Shannon)、尼森尼爾·羅切斯特(N. Rochester)四人,共同提出了一個關於機器智能的研究專案。在專案中,首次引入了「Artificial Intelligence 」這個詞,也就是人工智能。

1956年6月,在剛才那4個人的召集下,在洛克菲勒基金會的資助下,十余位 來自不同領域的 專家,聚集在美國紐咸西州漢諾威鎮的 達特茅斯學院,召開了一場為期將近兩月的學術研討會,專門討論機器智能。

這次研討會,就是著名的 達特茅斯 會議(Dartmouth workshop)。

參加會議的部份大佬

達特茅斯會議並沒有得出什麽重要的結論或宣言,但是認可了 「人工智能( Artificial Intelligence )」的命名,也大致明確了後續的研究方向。

這次會議,標誌著人工智能作為一個研究領域正式誕生,也被後人視為現代人工智能的起點。

AI三大學派

達特茅斯會議 之後,人工智能進入了一個快速發展階段。參與研究的人變得更多了,而且,也逐漸形成了幾大學術派系。

在這裏,我們要提到人工智能最著名的三大學派——符號主義、聯結主義(也叫聯接主義、連結主義)、行為主義。

符號主義 是當時最主流的一個學派。

他們認為,世界中的實體、概念以及它們之間的關系,都可以用符號來表示。人類思維的基本單元,也是符號。如果電腦能像人腦一樣,接收符號輸入,對符號進行操作處理,然後產生符號輸出,就可以表現出智能。

這個思路,關鍵在於把知識進行編碼,形成一個知識庫,然後透過推理引擎和規則系統,進行推斷,以此解決復雜的問題。

符號主義早期的代表性成果,是1955年赫伯特·西蒙(Herbert A. Simon,也譯為司馬賀)和艾倫·紐維爾(Allen Newell)開發的一個名為「邏輯理論家(Logic Theorist) 」 的程式。

「 邏輯理論家 」被認為是人類歷史上第一個人工智能程式,並且在達特茅斯會議上進行了演示。它將每個問題都表示成一個樹形模型,然後選擇最可能得到正確結論的那條線,來求解問題。

1957年, 赫伯特·西蒙 等人在「邏輯理論家 」 的基礎上,又推出了通用問題解決器 (General Problem Solver,GPS) ,也是符號主義的早期代表。

進入1960年代,符號主義也進入了一個鼎盛時期。在自然語言理解、微世界推理、專家系統(註意這個詞,後面會再次提到它)等領域,人工智能取得了突破性的進展,也逐漸成為公眾關註的物件。

1958年, 約翰·麥卡錫 正式釋出了自己開發的人工智能程式語言——LISP( LIST PROCESSING,意思是"表處理") 。後來的很多知名AI程式,都是基於LISP開發的。

約翰·麥卡錫(1927-2011)

1966年, 美國麻省理工學院的魏澤鮑姆(Joseph Weizenbaum),釋出了世界上第一個聊天機器人——ELIZA。

ELIZA的名字源於蕭伯納戲劇作品【賣花女】中的主角名。它 只有200行程式程式碼和一個有限的對話庫,可以 針對提問中的關鍵詞,進行答復。

ELIZA其實沒有任何智能性可言。它基於規則運作,既 不理解對方的內容,也不知道自己在說什麽 。但即便如此,它還是在當時引起了轟動。 ELIZA 可以說是現在Siri、小愛同學等問答互動工具的鼻祖。

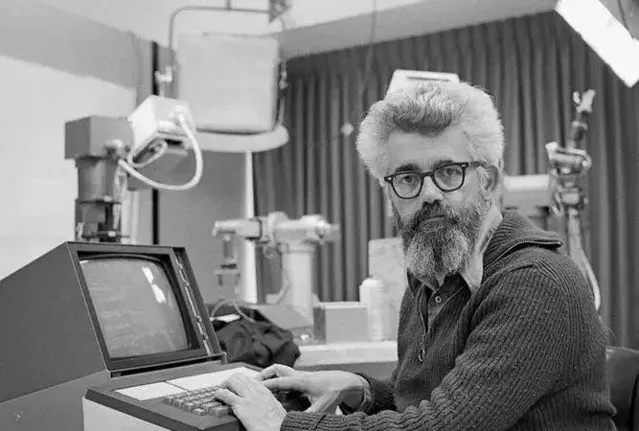

魏澤鮑姆(坐者)正在與ELIZA對話

再來看看 聯結主義 。

聯結主義, 強調模仿人腦的工作原理,建立神經元之間的聯結模型,以此實作人工神經運算。

大家可能會有點激動。沒錯,這就是現在非常熱門的神經網絡模型。

神經網絡的概念其實誕生得很早。 1943年,美國神經生理學家沃倫·麥卡洛克(Warren McCulloch ) 和數學家禾特·皮茨(Walter Pitts ) ,基於人類大腦的神經網絡,建立了一個 形式神經元的 電腦模型,並將其取名為MCP( McCulloch&Pitts )模型。

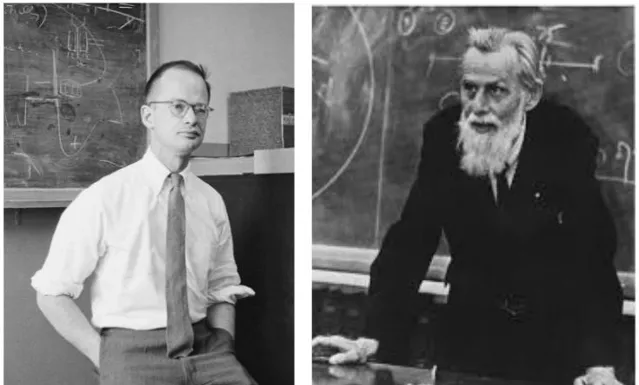

禾特·皮茨(左)和沃倫·麥卡洛克(右)

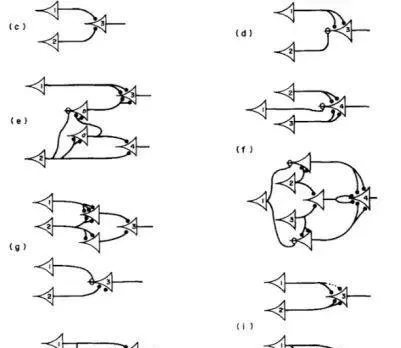

MCP模型

1951年,馬文·明斯基(就是前面提到的那個)和 他的同學鄧恩·艾德蒙(Dunn Edmund), 建造了第一台神經網絡機SNARC。

1957年,美國康奈爾大學的心理學家 和電腦科學家 法蘭·羅森布拉特(Frank Rosenblatt),在一台IBM-704電腦上,模擬實作了一種他發明的叫「感知機 (Perceptron) 」的神經網絡模型。

法蘭·羅森布拉特和他的感知機

這個 「感知器」 包括三層結構,一端是 400個光探測器,模擬視網膜。 光探測器 多次連線一組512個電子觸發器。 當它透過一個特定的可調節的興奮閥值時,就會像神經元一樣激發。這些觸發器連線到最後一層,當一個物體與感知器受訓見過的物件相互匹配時,它就會發出訊號。

感知機的工作原理

「感知機 」是聯結主義的一項重要成果,在人工智能發展史上具有裏程碑式的意義。但是,後來的一盆冰水,徹底澆滅了聯結主義的熱情。

1969年,馬文·明斯基和西蒙·派珀特(Seymour Papert)寫了一本書【感知機: 計算幾何學導論】的書,對羅森布萊特的感知器提出了質疑。馬文·明斯基認為:

「神經網絡具有很大的局限性(單層感知機無法解決線性不可分問題),沒有實際研究價值。」

馬文·明斯基(1927-2016)

來自大神的否定,等於直接宣判了神經網絡(聯結主義)路線的死刑。於是,這個非常有價值的研究方向,被中止了。

羅森布萊特後來死於意外(也有人說是自殺),馬文·明斯基也因為這個錯誤的判斷,被一些學者抨擊。 (需要註意,馬文·明斯基雖然有誤判,但他對人工智能事業的功遠大於過,甚至也被譽為「人工智能之父」。)

等到神經網絡(聯結主義)重新崛起,已經是十多年後的事情了。我們待會再詳細說。

最後,說說 行為主義 。

行為主義,也稱為前進演化主義或控制論學派。他們認為, 透過與環境的互動來學習和適應,從而改進自身行為,就是行為主義認為的智能。 智能取決於感知和行動,不需要知識、表示和推理,只需要將智能行為表現出來就好。

簡單來說,行為主義AI系統基於「感知-動作 」 的閉環控制, 強調即時反饋和適應力學習 。智能體透過感知環境資訊,基於這些資訊執行動作,並根據動作結果調整後續行為。

行為主義在後來的機器人學、自動化控制、遊戲AI、自動駕駛汽車等領域有著重要套用。

好了,以上是AI三大重要學派的介紹,作為學習AI的知識鋪墊,也有助於閱讀後面的文章。

請大家註意,AI的學派和思想路線並不止這三個,還有一些小學派,例如前進演化計算、模糊邏輯、貝葉斯網絡等。它們雖不構成獨立的大學派,但在AI的某些子領域內有著重要的套用和影響。而且,AI學派之間,邊界也比較模糊,有時候會互相融合。

其它重要成果

再簡單介紹一下當時另外幾項重要的研究成果。

首先必須是亞瑟·山緲(Arthur Samuel)的跳棋程式。

1959年,IBM科學家 亞瑟·山緲 在自家首台商用電腦IBM701上,成功編寫了一套西洋跳棋程式。 這個程式具有「學習能力」,可以透過對大量棋局的分析,逐漸辨識出「好棋」和「壞棋」,從而提高自己的下棋水平。

這個程式 很快就下贏了森姆自己,後來,它還 戰勝了當時的西洋跳棋大師羅拔尼賴。

因為首次提出了「機器學習(Machine Learning)」的概念, 亞瑟·山緲 被後人譽為「機器學習之父」。

亞瑟·山緲(1901-1990)

1959年,美國發明家喬治·德沃爾(George Devol)與約瑟夫·英格伯格(Joseph Engelberger)發明了人類首台工業機器人——Unimate。

Unimate重達兩噸,安裝執行於通用汽車生產線。它可以 控制一台多自由度的機械臂,搬運和堆疊熱壓鑄金屬件。

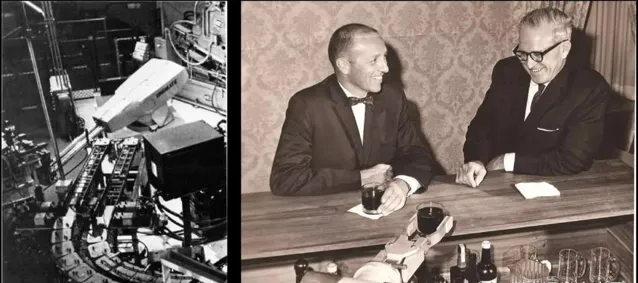

左圖為 Unimate

右圖是 約瑟夫·英格伯格(左)、 喬治·德沃爾(右)

1966年, 查理·羅森(Charlie Rosen)領導的 美國史丹佛研究所(SRI),研發成功了 首台人工智能機器人—— Shakey。

Shakey全面套用了人工智能技術,裝備了電子攝影機、三角測距儀、碰撞傳感器以及驅動電機,能簡單解決感知、運動規劃和控制問題。它 是第一個通用移動機器人,也被稱為「第一個電子人 」 。

研究人員正在調測Shakey

█ 第一次低谷階段 (1974年-1979年)

剛才說了,1960年代是符號主義的鼎盛時期。其實,在符號主義的帶動下,當時整個人工智能研究都進入了一個高速發展的階段,也被稱為AI的 黃金時代(Golden Time,1960-1973年)。

那時,除了定理證明、人機互動、 遊戲博弈 和 機器人 之外,人工智能很多領域都產出了不錯的成果。加上冷戰時期,美國政府願意掏錢資助,使得AI研究變得異常火爆。

在這一背景下,學術界對AI的預期,開始變得盲目樂觀。有些研究者認為:

「二十年內,機器將能完成人能做到的一切工作。」

1970年,馬文·明斯基甚至放言:

「在未來3-8年內,會誕生和人類智慧相當的機器人,可能我們人類會成為AI的寵物。」

盲目的樂觀,肯定不會有什麽好結果。

隨著時間的推移,學者們逐漸發現,基於推理規則的「智能」,實際上能力非常有限。加上當時電腦的算力和存力尚處於早期階段,系統根本達不到預期的效果。

之前介紹的那些AI程式和工具,陸續開始出現瓶頸,甚至鬧出笑話。

以機器轉譯為例。當時美國 政府投入了2000多萬美元作為機器轉譯的經費,結果相關團隊研發多年,發現完全低估了這個專案的難度。

轉譯工具經常出現一些低階錯誤。例如,將「Out of sight,out of mind(眼不見,心不煩)」轉譯成「又瞎又瘋」,把「 The spirit is willing but the flesh is weak( 心有余而力不足 ) 」轉譯成「酒是好的,但肉變質了」,把「 Time flies like an arrow( 光陰似箭 ) 」轉譯成「蒼蠅喜歡箭」。

接二連三的失敗,慢慢耗盡了政府金主的耐心。加上不久後美國經濟出現了一些問題(1974-1975年出現歷史上罕見的連續兩年GDP負增長),政府開始決定「斷糧」。

1973年,數學家萊特希爾(Lighthill)向英國政府送出了一份關於人工智能的研究報告(著名的【萊特希爾報告】)。報告對當時的機器人技術、語言處理技術和影像辨識技術進行了嚴厲且猛烈的批評,指出人工智能那些看上去宏偉的目標根本無法實作,研究已經徹底失敗。

很快, 英國政府、美國國防部高級研究計劃局( DARPA )和美國國家科學委員會等,開始 大幅削減甚至終止了對人工智能的投資。

人工智能進入了第一個發展低谷,也被稱為「AI Winter(AI之冬)」。

█

第二次高潮階段(1980年-1987年)

AI之冬的持續時間其實並不是很久。六年後, 1980年,第二次AI發展高潮開始了。

第二次浪潮,其實還是符號主義掀起的。這次的主角,是符號主義的一個新階段——專家系統 (Expert System) 。

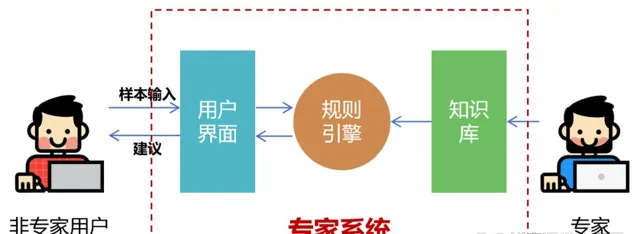

專家系統

專家系統,就是一個面向專業領域的超級「知識庫+推理庫 」 。

它找來很多人,對大量的專家知識和經驗進行整理 ,分析並編寫出海量的規則,匯入系統。然後,系統根據這些基於知識整理出來的規則,進行邏輯推理,來模擬和延伸人類專家的決策能力,解決復雜的問題。

大家能看出來,專家系統 走的 仍然 是符號主義的 「規則」路線。所以,專家系統, 也叫做規則基礎系統。

1968年,美國科學家愛德華·費根鮑姆(Edward Feigenbaum)提出了第一個專家系統——DENDRAL,並對知識庫給出了初步的定義。這標誌著專家系統的誕生。

愛德華·費根鮑姆(坐著的那位)

DENDRAL 面向的是化學行業。它可以幫助化學家判斷物質的分子結構。系統推出之後,因為能夠減少人力成本並且提升工作效率,受到了化學行業的歡迎和認可。

和DENDRAL差不多時間出現的 專家系統 ,還有 威廉·馬丁( William A. Martin )開發的 Macsyma,以及 安東尼·赫恩(Anthony C. Hearn )開發的 「Reduce」。

這兩套都是數學領域的專家系統(用於求解數學問題),都采用了約翰·麥卡錫的LISP語言進行開發。

1972年,美國醫生兼科學家愛德華·H·肖特利夫(Edward H. Shortliffe)建立了 可以幫助進行醫學診斷的專家系統—— MYCIN。

愛德華·H·肖特利夫

MYCIN也是基於LISP語言編寫,擁有500多條規則,能夠辨識51種病菌,正確地處理23種抗菌素。

它能夠協助醫生診斷、治療細菌感染性血液病,為患者提供最佳處方。當時,它 成功地處理了數百個病例,並透過了嚴格的測試,顯示出了較高的醫療水平。

1977年, 愛德華· 費根鮑姆在第五屆國際人工智能聯合會議上,提出了「知識工程(Knowledge Engineering)」的概念,進一步推動了專家系統的普及。

進入1980年代, 隨著技術的演進, 電腦的計算和儲存能力增加, 專家系統 開始 在各個行業爆發。

1980年,卡耐基梅隆大學研發的專家系統XCON(eXpertCONfigurer)正式商用,為當時的電腦巨頭公司DEC每年省下數千萬美金。

1983年,通用電氣公司搞出了柴油電力機車維修專家系統(DELTA)。這個系統封裝了眾多GE資深現場服務工程師的知識和經驗,能夠指導員工進行故障檢修和維護。

當時,美國運通公司也搞了一個信用卡認證輔助決策專家系統,據說每年可節省2700萬美金。

總而言之,那時候的專家系統,是大公司趨之若鶩的神器。它能夠帶來實實在在的經濟效益,所以,行業使用者願意為之投資。這是第二次AI浪潮的根本原因。

我們也可以這麽說,第一次AI浪潮,是政府投資帶動的。第二次AI浪潮,是企業投資帶動。AI,開始進入產業化的階段。

企業投資的成效,反過來又讓各國政府對AI恢復了一些信心。

1981年,經濟高速增長的日本,率先 開始 對AI進行投入。

那一年,日本經濟產業省撥款8.5億美元,支持第五代電腦專案。這個專案的最終目的,是造出一台 人工智能電腦 ,能夠與人對話、轉譯語言、解釋影像、完成推理。

美國和英國政府,也很快采取了行動。

1983年,美國國防部高級研究計劃局(DARPA ) 透過「戰略計算促進會(Strategic Computing Initiative )」,重新開機對 人工智能研究的資助。

同年,英國投資3.5億英鎊,啟動了Alvey(阿爾維)計劃,全面推進軟件工程、人機介面、智能系統和超大規模集成電路等領域的研發。

關於專家系統,還有一個雄心勃勃的專案值得一提。那就是 1984年啟動的 Cyc專案。

Cyc專案由美國微電子與電腦技術公司發起,是一個「超級百科全書 」 專案。它試圖將人類擁有的所有一般性知識都輸入電腦,建立一個巨型數據庫。

這個專案,據說到現在還在進行之中。

█ 第二次低谷階段(1987年-1993年)

好景不長,到了1980年代的後半段,人工智能又開始走下坡路了。

原因是多方面的。

首先,專家系統(符號主義)基於規則和已有知識的「檢索+推理」,面對復雜的現實世界,顯然還是有能力瓶頸。

它的套用領域狹窄、缺乏常識性知識、

知識獲取困難、推理方法單一、缺乏分布式功能、難以與現有數據庫相容等……所有這些問題,都給它的進一步發展造成了困擾。

其次, 80年代PC(個人電腦)技術革命的爆發,也給專家系統造成了沖擊。

當時專家系統基本上都是用LISP語言編寫的。系統采用的硬件,是 Symbolics等廠商生產的人工智能專用電腦(也叫LISP機)。

LISP系列主機

1987年,蘋果和IBM公司生產的桌上型電腦,在效能上已經超過了 Symbolics的AI電腦,導致AI硬件市場需求土崩瓦解。

專家系統的維護和更新也存在很多問題。不僅操作復雜,價格也非常高昂。

結合以上種種原因,市場和使用者逐漸對專家系統失去了興趣。

到了80年代晚期,戰略計算促進會大幅削減對AI的資助。DARPA的新任領導也認為AI並非「下一個浪潮」,削減了對其的投資。

AI,進入了第二次低谷階段。

█ 第三次高潮階段(1994年-現在)

在進入1990年代之前,小棗君還是要再講講1980年代。

1980年代,專家系統掀起了第二次AI浪潮,也推動了AI技術的發展。但從上帝視角來看,真正對後來的AI發展產生深遠影響的,其實不是專家系統,而是另外一個被遺忘了二十多年的賽道。

沒錯,這個賽道,就是當年被馬文·明斯基一句話給幹廢的「神經網絡 」 賽道。

機器學習和神經網絡

前文我們提到,神經網絡是聯結主義的一個代表性研究方向。但是,因為

馬文·明斯基的否定,這個方向在1969年被打入冷宮。

1980年,越來越多的科學家意識到專家系統存在不足。符號主義這條路,很可能走不通。人們認為,人工智能想要實作真正的智能,就必須擁有自己的感知系統,能夠自主學習。

於是,倡導讓 機器「自動地從數據中學習,並透過訓練得到更加精準的預測和決策能力 」 的研究思想,開始逐漸活躍起來。這就是前面提到過的機器學習。

機器學習包含多種方法和理論學派。源於聯結主義學派的神經網絡,就在這一時期開始「復活」。

1982年,約翰·霍普菲爾德( John Hopfield )在自己的論文中重點介紹了Hopfield網絡模型(模型原型早期由其他科學家提出)。這是一種具有記憶和最佳化功能的迴圈(遞迴)神經網絡。

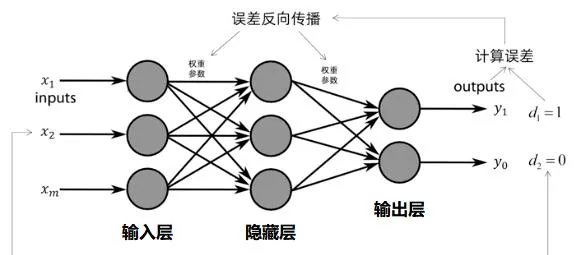

1986年,戴維·魯梅爾哈特(David Rumelhart)、 謝菲·辛頓(Geoffrey Hinton,記住這個名字!) 和朗奴·威廉士(Ronald Williams)等人共同發表了一篇名為【Learning representations by back-propagation errors(透過反向傳播演算法的學習表征)】的論文。

在論文中,他們提出了一種適用於多層感知器(MLP ) 的演算法,叫做 反向傳播演算法(Backpropagation,簡稱BP演算法)。

該演算法透過在輸入層和輸出層之間設定一個中間層(隱藏層),以反向傳播的方式實作機器的自我學習。

演算法咱們以後再研究。大家只需要記住,BP演算法不僅 為多層神經網絡的發展奠定了基礎,也打破 了馬文·明斯基當年提出的「神經網絡具有局限性 」 魔咒 ,意義非常重大。

1980年代是人工智能研究方向發生重大轉折的時期。機器學習和神經網絡(聯結主義)加速崛起,逐漸取代 專家系統(符號主義),成為人工智能的主要研究方向 。

我們也可以理解為,人工智能原本由知識驅動的方式,逐漸變成了由數據驅動。

這張圖,先劇透一下

機器學習的代表性演算法包括決策樹、支持向量機、隨機森林等。

1995年,克里娜·曲特斯(Corinna Cortes ) 和維拉迪摩·萬普尼克(Vladimir Vapnik ) 開發了支持向量機(Support Vector Machine,SVM)。 支持向量機是一種對映和辨識類似數據的系統, 可以視為在感知機基礎上的改進。

神經網絡方面,非常重要的CNN (Convolutional Neural Network,摺積神經網絡) 和RNN (Recursive Neural Networks,遞迴神經網絡) ,也在那一時期崛起了。

1988年,貝爾實驗室的Yann LeCun(他是法國人,網上轉譯的中文名有很多:楊立昆、楊樂春、燕樂存、揚·勒丘恩)等人,提出了摺積神經網絡。大家應該比較熟悉,這是一種專門用於處理影像數據的神經網絡模型。

Yann LeCun

1990年,美國認知科學家、心理語言學家謝菲·艾爾曼(Jeffrey Elman)提出了 首個遞迴神經網絡—— 艾爾曼網絡模型。遞迴神經網絡能夠在訓練時維持數據本身的先後順序性質,非常適合於自然語言處理領域的套用。

1997年,德國電腦科學家瑟普·霍克韋特( Sepp Hochreiter )及其導師 于爾根·施密德胡伯(Jürgen Schmidhuber ) 開發了用於遞迴神經網絡的LSTM(長短期記憶網絡)。

1998年,Yann LeCun等人提出了LeNet,一個用於手寫數碼辨識的摺積神經網絡,初步展示了神經網絡在影像辨識領域的潛力。

總而言之,20世紀90年代, 神經網絡在開始商用於文字影像辨識、語音辨識、資料探勘以及金融預測。在模式辨識、訊號處理、控制工程等領域,也有嘗試套用,盡管當時受到計算資源限制,套用範圍和規模有限。

想要推動人工智能技術的進一步爆發,既需要演算法模型的持續演進,也需要算力的深入增強。此外,還有一個短板,也需要補充,那就是數據。

大家應該看出來了,AI的三要素,就是演算法、算力和數據。

深藍

1990年代最重要的AI事件,當然是1997年IBM超級電腦「深藍(DEEP BLUE) 」 與國際象棋大師卡斯巴洛夫(KASPAROV)的世紀之戰。

此前的1996年2月,深藍已經向 卡斯巴洛夫發起過一次挑戰,結果以2-4敗北。

1997年5月3日至11日, 「深藍」 再次挑戰 卡斯巴羅夫 。在經過六盤大戰後,最終「深藍」以2勝1負3平的成績,險勝卡斯巴羅夫,震驚了世界。

這是AI發展史上,人工智能首次戰勝人類。

作為80後的小棗君,對這件事情也印象深刻。當時「深藍 」 所引起的熱潮,絲毫不亞於後來的ChatGPT。幾乎所有的人都在想——人工智能時代是否真的到來了?人工智能,到底會不會取代人類?

深度學習

進入21世紀,得益於電腦算力的進一步飛躍,以及雲端運算、大數據的爆發,人工智能開始進入一個更加波瀾壯闊的發展階段。

2006年,多倫多大學的謝菲·辛頓(就是1986年發表論文的那個大神)在science期刊上,發表了重要的論文【Reducing the dimensionality of data with neural networks( 用神經網絡降低數據維數 )】,提出深度信念網絡(Deep Belief Networks,DBNs)。

謝菲·辛頓

深度學習 (Deeping Learning) ,正式誕生了。

2006年被後人稱為深度學習元年,謝菲·辛頓也因此被稱為「深度學習之父 」 。

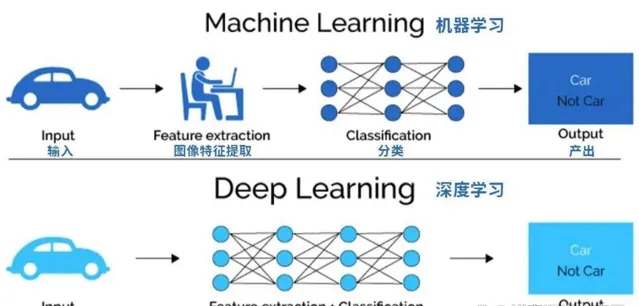

深度學習是機器學習的一個重要分支。更準確來說,機器學習底下有一條「神經網絡」路線,而深度學習,是加強版的「神經網絡」學習。

經典機器學習演算法使用的神經網絡,具有輸入層、一個或兩個「隱藏」層和一個輸出層。數據需要由人類專家進行結構化或標記(監督學習),以便演算法能夠從數據中提取特征。

深度學習演算法使用「隱藏」層更多(數百個)的深度神經網絡。它的能力更強,可以自動從海量的數據集中提取特征,不需要人工幹預(無監督學習)。

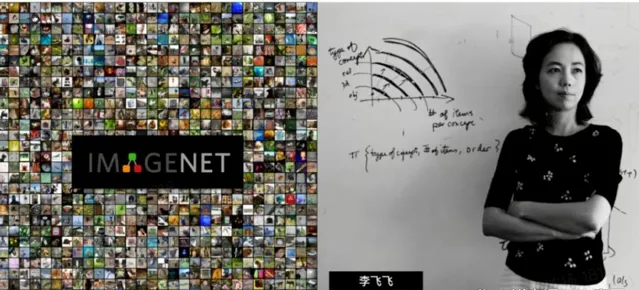

2006年, 在史丹佛任教的華裔科學家李飛飛, 意識到了業界在研究AI演算法的過程中,沒有一個強大的圖片數據樣本庫提供支撐。於是,2007年,她 發起建立了ImageNet專案,號召 民眾上傳影像並標註影像內容。

2009年, 大型影像數據集——ImageNet ,正式釋出。這個數據庫包括了 1400萬張圖片數據,超過2萬個類別,為全球AI研究(神經網絡訓練)提供了強大支持。

李飛飛和 ImageNet

從2010年開始,ImageNet每年舉行大規模視覺辨識挑戰賽,邀請全球開發者和研究機構參加,進行人工智能影像辨識演算法評比。

2012年, 謝菲·辛頓 和他的學生 伊利亞·蘇茨克沃(Ilya Sutskever)和艾力斯·克里切夫斯基(Alex Krizhevsky)參加了這個比賽。

師徒三人

他們設計的 深度神經網絡模型 AlexNet在這次競賽中大獲全勝, 以壓倒性優勢獲得第一名( 將Top-5錯誤率降到了15.3%,比第二名低10.8% ),引起了業界轟動,甚至一度被懷疑是作弊。

值得一提的是,他們三人用於訓練模型的,只是2張輝達 GTX 580 顯卡。GPU在深度神經網絡訓練上表現出的驚人能力,不僅讓他們自己嚇了一跳,也讓黃仁勛和輝達公司嚇了一跳。

作為對比,2012年的早些時候,谷歌「Google Brain」專案的研究人員吳恩達(華裔美國人,1976年生於倫敦)、傑夫·迪恩( Jeff Dean )等人,也搗鼓了一個神經網絡(10億參數),用來訓練對貓的辨識。

他們的 訓練數據是來自youtube的1000萬個貓臉圖片,用了1.6萬個CPU,整整訓練了3天。

吳恩達

「深度神經網絡+GPU 」 的優勢,顯露無疑。很多人和很多公司的命運,從此改變了。

2013年,辛頓師徒三人共同成立了一家名為DNNresearch的公司。後來,這個只有三個人且沒有任何產品和計劃的公司,被谷歌以幾千萬美元的價格競購(百度也跑去買,和谷歌爭到最後,沒成功)。

AlphaGo

2013年-2018年,谷歌是人工智能領域最活躍的公司。

2014年,谷歌公司收購了 專註於深度學習和強化學習技術的人工智能公司—— DeepMind公司。

2016年3月, DeepMind開發的人工智能圍棋程式 AlphaGo(Alpha狗),對戰世界圍棋冠軍、職業九段選手李世石,並以4:1的總比分獲勝,震驚了全世界。

AlphaGo 具有很強的自我學習能力, 能夠搜集大量圍棋對弈數據和名人棋譜,學習並模仿人類下棋。

一年後, AlphaGo的第四代版本 AlphaGoZero問世。 在無任何數據輸入的情況下,僅用了3天時間自學圍棋,就以100:0的巨大優勢,橫掃了第二代版本AlphaGo。學習40天後, AlphaGoZero 又戰勝了第三代版本AlphaGo。

當時,全世界都在熱議 AlphaGoZero的強悍自學能力,甚至一度引起了人類的恐慌情緒。

谷歌在AI圈出盡風頭,但他們估計也沒有想到,一家在2015年悄然成立的公司(確切說,當時是非營利性組織),會很快取代他們的主角地位。這家公司(組織),就是如今大紅大紫的OpenAI。

OpenAI的創始人,除了埃隆·馬斯克(Elon Musk)之外,還有山姆·奧爾特曼(Sam Altman)、彼得·泰爾(Peter Thiel)、列特·霍夫曼(Reid Hoffman)。辛頓的那個徒弟, 伊利亞·蘇茨克沃,也跑去當了研發主管。

AIGC

深度學習崛起之後,大家應該註意到,都是用於一些判別類的場景,判斷貓、狗之類的。那麽,深度學習,是否可以創造(生成)一些什麽呢?

2014 年, 蒙特利爾大學博士生 伊恩· 古德費洛( Ian Goodfellow ),從博弈論中的 「 二人零和博弈 」 得到啟發,提出了生成對抗網絡(GANs,Generative Adversarial Networks)。

生成對抗網絡 用兩個神經網絡即生成器(Generator)和判別器(Discriminator)進行對抗。在兩個神經網絡的對抗和自我叠代中,GAN會逐漸演化出強大的能力。

生成對抗網絡的出現,對無監督學習、圖片生成等領域的研究,起到極大的促進作用,後來也拓展到電腦視覺的各個領域。

2017年12月,Google機器轉譯團隊在行業頂級會議NIPS上,丟下了一顆重磅炸彈。他們發表了一篇裏程碑式的論文,名字叫做【Attention is all you need(你所需要的,就是註意力)】。

論文提出只使用「自我註意力(Self Attention) 」 機制來訓練自然語言模型,並給這種架構起了個霸氣的名字——Transformer(轉換器、變壓器,和「變形金剛」是一個詞)。

所謂"自我註意力"機制,就是只關心輸入資訊之間的關系,而不再關註輸入和對應輸出的關系, 無需再進行昂貴的人工標註。 這是一個革命性的變化。

Transformer的出現,徹底改變了深度學習的發展方向。它不僅 對序列到序列任務、機器轉譯和其它自然語言處理任務產生了深遠的影響,也為後來AIGC的崛起打下了堅實的基礎。

終於,AIGC的時代,要到來了。

2018年6月,年輕的OpenAI,釋出了第一版的GPT系列模型——GPT-1。同時,他們還發表了論文【Improving Language Understanding by Generative Pre-training(透過生成式預訓練改進語言理解)】。

GPT,就是 Generative Pre.trained Transfommer的縮寫, 生成式預訓練變換器 。

Generative(生成式),表示該模型 能夠生成連續的、有邏輯的文本內容,比如完成對話、創作故事、編寫程式碼或者寫詩寫歌等。

Pre.trained(預訓練),表示該模型會先在一個大規模未標註文本語料庫上進行訓練,學習語言的統計規律和潛在結構。

Transfommer,剛才說過了,就是那個很厲害的轉換器模型。

谷歌緊隨其後。2018年10月,他們釋出了有 3億參數的BERT(Bidirectional Encoder Representation from Transformers)模型,意思是「來自Transformers的雙向編碼表示 」 模型。

GPT-1和BERT都使用了深度學習和註意力機制,具備較強的自然語言理解能力。兩者的區別是,BERT使用文本的上下文來訓練模型。而專註於 「 文本生成 」 的GPT-1,使用的是上文。基於 「 雙向編碼 」 的能力,BERT的效能在當時明顯優異於GPT-1。

谷歌的領先是暫時的。2019年和2020年,OpenAI接連釋出了GPT-2和GPT-3。2022年11月,OpenAI釋出了基於GPT模型的人工智能對話套用服務——ChatGPT(也可以理解為GPT-3.5),徹底引爆了全世界。

ChatGPT 結合了人類生成的對話數據進行訓練,展現出豐富的世界知識、復雜問題求解能力、多輪對話上下文追蹤與建模能力,以及與人類價值觀對齊的能力。

它在人機對話方面的出色表現,引發了社會的高度關註, 在全球範圍內掀起了一股AI巨浪。

後面的事情,大家都比較清楚了。

繼ChatGPT後,OpenAI又釋出了GPT-4、 GPT-4V、GPT-4 Turbo 、GPT-4o,形成了如今難以撼動的領導者地位。谷歌雖然也釋出號稱最強AI大模型的Gemini,但仍然難以在風頭上蓋過OpenAI。

除了文本生成,生成式AI也積極向多模態發展,能夠處理影像、音訊、影片等多種媒體形式。

例如DALL-E、Stable Diffusion、 Midjourney 等影像生成模型,Suno、Jukebox音樂生成模型,以及 SoRa影片生成模型。

全球面向各個垂直領域的「大模型之戰 」 ,仍在硝煙彌漫地進行之中。。。

█ 結語

寫到這裏,這篇洋洋灑灑一萬多字的文章,終於要結束了。

我總結一下:

人工智能起步於1950年代,早期主要是符號主義占主流,並引發了第一次(政府投資)和第二次AI浪潮(企業投資)。

到1980年代,符號主義逐漸走弱,機器學習和神經網絡開始崛起,成為主流。

1994-現在,雖然叫做第三次AI浪潮,但也分兩個階段。1994-2006(其實是1980-2006),是機器學習、神經網絡的早期積累階段,打基礎。

2006年,神經網絡進入深度學習階段,就徹底開始了AI的爆發。

從2018年開始,人工智能逐漸進入了 Transformer和 大模型時代,能力有了巨大的提升,也掀起了AI巨浪。

如今的人工智能,已經是全世界關註的焦點,也處於一個前所未有的白金發展階段。

隨著深度學習、神經網絡、生成式AI等技術的不斷突破,人工智能已經在工業、教育、醫療、金融、交通、娛樂等幾乎所有領域實作了落地。人工智能在電腦視覺、自然語言處理、機器人等方面所具備的能力,已經被套用到大量的垂直場景,並產生了可觀的經濟效益。

在人工智能熱潮的帶動下,軟件、半導體、通訊等ICT產業,都獲得了不錯的商業機會。圍繞人工智能的幾家大公司,包括輝達、微軟、蘋果、Alphabet(谷歌母公司)、亞馬遜、Meta、特斯拉,目前在股票市場被譽為「七巨頭」,市值屢破紀錄。

當然了,這股熱潮究竟會走向何方,我們還不得而知。也許,它會繼續增長一段時間,甚至長期持續下去,將人類徹底帶入智能時代。也許,我們會進入第三次AI低谷,泡沫破碎,一地雞毛,又進入一個新的周期。

未來如何,就讓時間來告訴我們答案吧。

參考文獻:

1、【人工智能簡史】,尼克;

2、【人工智能發展簡史 】 孫淩雲、孟辰燁、李澤健;

3、【人工智能 60 年技術簡史】,李理;

4、【深度學習簡史】,Keith D. Foote;

5、【 AI是什麽 將帶我們去哪兒? 】 ,李開復;

6、【 人工智能的五個定義:哪個最不可取? 】 ,李開復;

7、【 一文讀懂人工智能發展史:從誕生,到實作產業化 】 ,李彎彎;

8、【 你一定愛讀的人工智能簡史 】 ,山本一成;

9、【 AlphaGo背後:深度學習的勝利 】 ,曹玲;

10、【三張圖講述一部AI前進演化史 】,產品二姐(知乎 ) ;

11、【GPT的背後,從命運多舛到顛覆世界,人工神經網絡的跌宕80年 】,孫睿晨;

12、百度百科、維基百科等。