輝達推出了自家版本的ChatGPT,名字很有GPU的味道——

Chat With RTX。

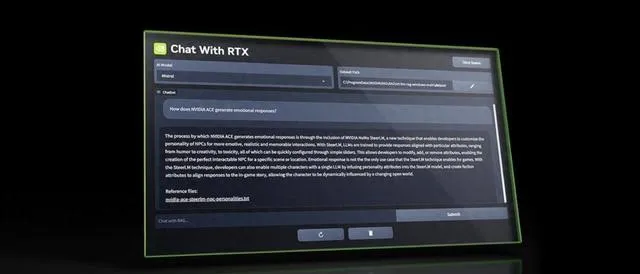

輝達的這款AI聊天機器人和目前主流的「選手」有所不同。它並非是在網頁或APP中執行,而是需要下載安裝到個人電腦中。這波操作,不僅是在執行效果上會更快,也就意味著Chat With RTX在聊天內容上或許並沒有那麽多限制。

網友們也紛紛對這一點發出了感慨:

哇~這是本地執行的耶~

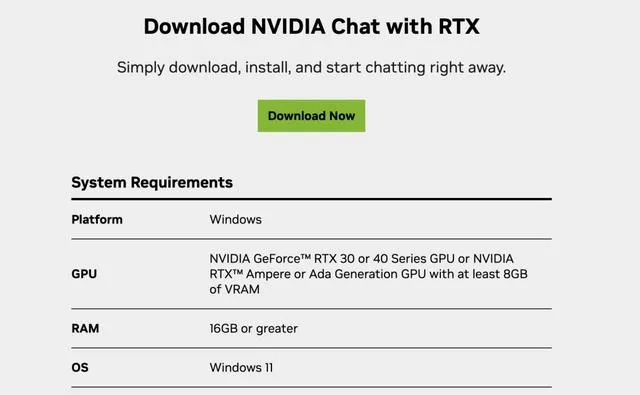

當然,在配置方面也是要求的,只需要至少8GB的RTX 30或40系列顯卡即可。

那麽Chat With RTX的實際效果如何,我們繼續往下看。

輝達版ChatGPT

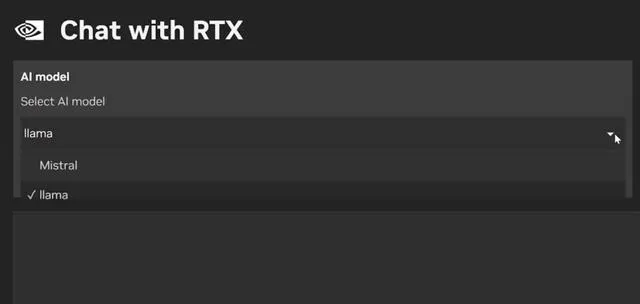

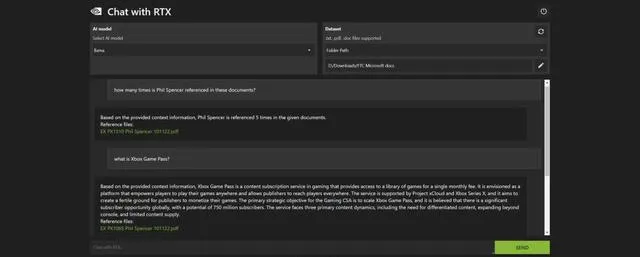

首先,值得一提的是,Chat With RTX並非是輝達自己搞了個大語言模型(LLM)。它背後所依靠的仍是兩款開源LLM,即Mistral和Llama 2,使用者在執行的時候可以根據喜好自行選擇。

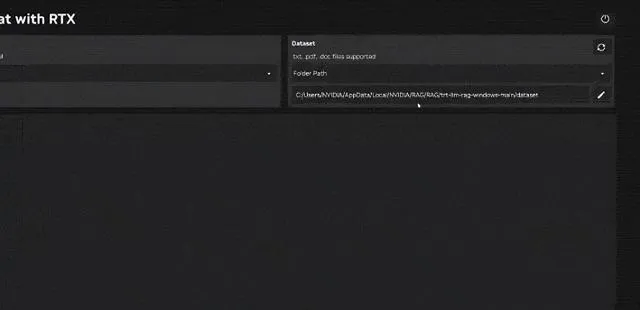

Pick完LLM之後,就可以在Chat With RTX中上傳本地檔。支持的檔類別包括txt,.pdf,.doc/.docx和.xml。

然後就可以開始提問了,例如:

Sarah推薦的餐廳名字是什麽?

由於是在本地執行,因此Chat With RTX生成答案的速度是極快的,真真兒的是「啪的一下」:

Sarah推薦的餐廳名字叫做The Red Le Bernardin。

除此之外,Chat With RTX另一個亮點功能,就是可以根據線上影片做回答。例如把一個油管影片的連結「投餵」給它:

然後向Chat With RTX提問:

輝達在CES 2024上宣布了什麽?

Chat With RTX也會以極快的速度根據影片內容作答。至於其背後用到的技術方面,輝達官方只是簡單提了一句:「用到了檢索增強生成 (RAG)、NVIDIA TensorRTLLM軟件和NVIDIA RTX等。」

如何食用?

正如我們剛才提到的,Chat With RTX的用法很簡單,只需一個下載安裝的動作。不過在配置上,除了GPU的要求之外,還有一些條件,例如:

系統:Windows 10或Windows 11

RAM:至少16GB

驅動:535.11版本或更新

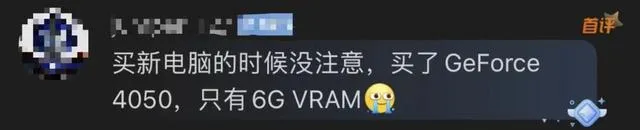

不過Chat With RTX在大小上並沒有很輕量,共計大約35G。因此在下載它之前,務必需要檢查一下Chat With RTX所需要的安裝條件。不然就會出現各種各樣的悲劇了:

不過實測被吐槽

The Verge在輝達釋出Chat With RTX之後,立即展開了一波實測。不過結論卻是大跌眼鏡。例如剛才提到的搜尋影片功能,在實際測試過程中,它竟然下載了完全不同影片的文字記錄。

其次,如果給Chat With RTX「投餵」過多的檔,例如讓Chat with RTX為25000個文件編制索引,它就直接「罷工」崩潰了。以及它也「記不住」上下文,因此後續問題不能基於上一個問題。

最後還有個槽點,就是下載Chat with RTX消耗了測試人員整整半個小時……不過槽點之外,The Verge也比較中立地肯定了Chat with RTX的優點。例如搜尋電腦上的文件,其速度和精準度是真香。

並且做總結也是Chat with RTX較為擅長的內容:

更重要的是,在本地執行這樣的機制,給使用者檔的安全性帶來了保障。那麽你會pick輝達版的ChatGPT嗎?