自動化整合系統配套服務商-日弘智能今天為大家講講視覺定位系統如何讓導航精準定位?視覺定位系統與影像處理,現如今,因為影像處理和人工智能演算法技術性的快速發展趨勢,愈來愈多的學者選用監控網絡攝影機做為全獨立用搬運機器人的認知感應器。這關鍵是由於原先的超聲波或紅外線傳感器認知數據量比較有限,可延伸性差,而視覺辨識系統則能夠 填補這種缺陷。而現實世界是三維的,而投影於拍攝攝像鏡頭(CCD/CMOS)上的影像則是二維的,視覺效果解決的最後目地便是要從認知到的二維影像中獲取相關的三維世界資訊內容。

簡單說來就是對機器人周邊的環境進行光學處理,先用網絡攝影機進行影像資訊采集,將采集的資訊進行壓縮,然後將它反饋到一個由神經網絡和統計學方法構成的學習子系統,再由學習子系統將采集到的影像資訊和機器人的實際位置聯系起來,完成機器人的自主導航定位功能。

(1)網絡攝影機標定演算法:2D-3D對映求參。

傳統攝影機標定主要有 Faugeras 標定法、Tscai 兩步法、直接線性變換方法、張正友平面標定法和 Weng叠代法。自標定包括基於 Kruppa 方程式自標定法、分層逐步自標定法、基於絕對二次曲面的自標定法和 Pollefeys 的模約束法。視覺標定有馬頌德的三正交平移法、李華的平面正交標定法和 Hartley 旋轉求內參數標定法。

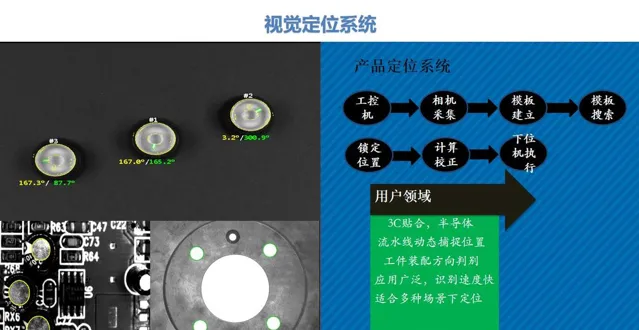

(2)視覺定位系統與影像處理:

a.預處理:灰化、降噪、濾波、二值化、邊緣檢測。。。

b.特征提取:特征空間到參數空間對映。演算法有HOUGH、SIFT、SURF。

c.影像分割:RGB-HIS。

d.影像描述辨識

(3)定位演算法:基於濾波器的定位演算法主要有KF、SEIF、PF、EKF、UKF等。

也可以使用單目視覺和裏程計融合的方法。以裏程計讀數作為輔助資訊,利用三角法計算特征點在當前機器人座標系中的座標位置,這裏的三維座標計算需要在延遲一個時間步的基礎上進行。根據特征點在當前網絡攝影機座標系中的三維座標以及它在地圖中的世界座標,來估計網絡攝影機在世界座標系中的位姿。這種降低了傳感器成本,消除了裏程計的累積誤差,使得定位的結果更加精確。此外,相對於立體視覺中攝影機間的標定,這種方法只需對攝影機內參數進行標定,提高了系統的效率。

4.定位演算法基本過程:

簡單的演算法過程,可基於OpenCV進行簡單實作。

輸入

透過網絡攝影機獲取的影片流(主要為灰度影像,stereo VO中影像既可以是彩色的,也可以是灰度的 ),記錄網絡攝影機在t和t+1時刻獲得的影像為It和It+1,相機的內參,透過相機標定獲得,可以透過matlab或者opencv計算為固定量。

輸出

關於視覺定位系統如何讓導航精準定位?視覺定位系統與影像處理的知識點,想要了解更多的,可關註日弘智能官網,如有需要了解更多運動控制卡,運動控制器,Ethercat總線控制器,Codesys,視覺系統,視覺運動控制系統,視覺激光打標機系統,視覺點膠機系統,五軸聯動系統,振動刀切割系統,裁布切割系統的相關技術知識,歡迎留言獲取!