這兩天,Apple Intelligence 的上線成為了最大的科技新聞之一。

雖然相比 1 個多月前公布的完整版 Apple Intelligence,蘋果 iOS 18.1 beta 1 中引入的 Apple Intelligence 功能並不完整,Image Playground、Genmoji、優先通知、具有螢幕感知功能的 Siri 和 ChatGPT 整合……這些統統都還沒有。

但總的來說,蘋果還是帶來了 Writing Tools(寫作工具)、通話錄音(含轉錄)以及全新設計的 Siri。

其中,Writing Tools 支持重寫、專業化、簡略等功能,可以用於聊天、發朋友圈、小紅書筆記以及文本寫作等場景;通話錄音不僅可以記錄通話,還能自動轉錄成文本,方便使用者回顧。

此外,Siri 也得到了「升級」,可惜目前還僅限於設計,包括全新的「跑馬燈」特效以及鍵盤輸入支持。

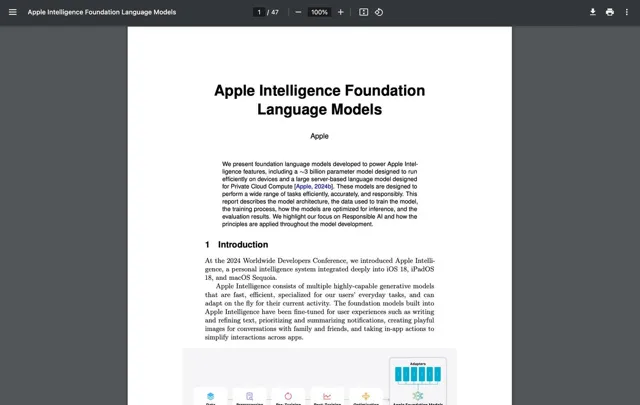

但引人註目的是,蘋果在一篇名為【Apple Intelligence Foundation Language Models】的論文中披露, 蘋果並沒有采用常見的輝達 p00 等 GPU,而是選了「老對手」谷歌的 TPU,訓練 Apple Intelligence 的基礎模型。

圖/蘋果

用谷歌 TPU,煉成 Apple Intelligence

眾所周知,Apple Intelligence 總共分成三層:一層是執行在蘋果器材原生的端側 AI,一層是基於「私有雲端運算」技術執行在蘋果自有數據中心的雲端 AI。按照供應鏈傳出的訊息,蘋果將透過大量制造 M2 Ultra 來構建自有數據中心。

此外還有一層,則是接入第三方雲端大模型,比如 GPT-4o 等。

不過這是推理端,蘋果是如何訓練出自己的 AI 模型,一直是行業內關註的焦點之一。而從蘋果官方的論文來看,蘋果是在 TPUv4 和 TPUv5p 集群的硬件上訓練了兩個基礎模型:

一個是參數規模達到 3 億的器材端模型 AFM-on-device,使用 2048 塊 TPU v5p 訓練而成,本地執行在蘋果器材上;一個是參數規模更大的伺服器端模型 AFM-server,使用 8192 塊 TPU v4 芯片訓練,最終執行在蘋果自有數據中心裏。

圖/蘋果

這就奇怪了,畢竟我們都知道,輝達 p00 等 GPU 才是目前訓練 AI 的主流選擇,甚至會有「AI 訓練只用 Nvidia GPU」的說法。

與之相對,谷歌的 TPU 就顯得有些「名不見經傳」。

但事實上,谷歌的 TPU 是專為機器學習和深度學習任務設計的加速器,能夠提供卓越的效能優勢。憑借其高效的計算能力和低延遲的網絡連線,谷歌的 TPU 在處理大型模型訓練任務時表現出色。

例如,TPU v4 就能提供了每個芯片高達 275 TFLOPS 的峰值算力,並透過超高速互連將 4096 個 TPUv4 芯片連線成一個大規模的 TPU 超算,從而實作算力規模的倍增。

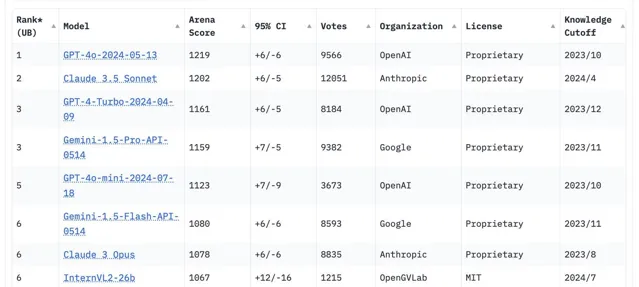

而且不僅是蘋果,其他大模型公司也采用了谷歌的 TPU 來訓練他們的大型模型。 Anthropic 公司的 Claude 就是一個典型的例子。

聊天機器人競技場排行,圖/LMSYS

Claude 如今可以說是 OpenAI GPT 模型最強大的競爭對手,在 LMSYS 聊天機器人競技場上,Claude 3.5 Sonnet 與 GPT-4o 始終是「臥龍鳳雛」(褒義)。而據披露,Anthropic 一直沒有購買輝達 GPU 來搭建超算,就是使用 Google Cloud 上 TPU 集群來訓練和推理。

去年底,Anthropic 還官宣率先使用 Google Cloud 上的 TPU v5e 集群來訓練 Claude。

Anthropic 的長期使用,以及 Claude 表現出來的效果,都充分展示了谷歌 TPU 在 AI 訓練中的高效性和可靠性。

此外,谷歌的 Gemini 也是完全依賴於自研的 TPU 芯片進行訓練。Gemini 模型旨在推進自然語言處理和生成技術的前沿,其訓練過程需要處理大量的文本數據,並進行復雜的模型計算。

而 TPU 的強大計算能力和高效的分布式訓練架構,使得 Gemini 能夠在相對較短的時間內完成訓練,並在效能上取得顯著突破 。

但如果說 Gemini 尚可理解,那從 Anthropic 到蘋果又為什麽選擇谷歌 TPU,而不是輝達 GPU?

TPU 和 GPU,谷歌和輝達的暗戰

在本周一舉辦的電腦圖形學頂級會議 SIGGRAPH 2024 上,輝達創始人兼 CEO 黃仁勛透露,本周輝達就將發送 Blackwell 架構的樣品,這是輝達最新一代的 GPU 架構。

2024 年 3 月 18 日,輝達 GTC 大會上釋出了其最新一代 GPU 架構——Blackwell,以及最新一代 B200 GPU。在效能上,B200 GPU 在 FP8 及新的 FP6 上可以達到 20 petaflops(每秒千萬億次浮點運算)的算力,使其在處理復雜 AI 模型時表現出色。

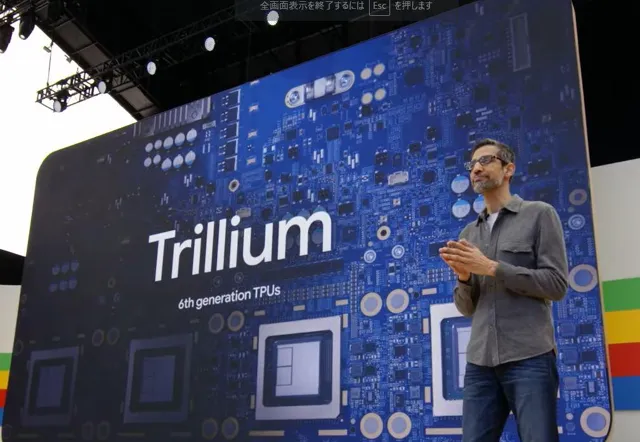

Blackwell 釋出的兩個月後,谷歌也釋出了其第六代 TPU(Trillium TPU) ,每塊芯片在 BF16 下可以提供接近 1000 TFLOPS(每秒萬億次)的峰值算力,谷歌也將其評價為「迄今為止效能最高、最節能的 TPU」。

圖/谷歌

對比谷歌的 Trillium TPU,輝達 Blackwell GPU 在高頻寬記憶體(HBM3)和 CUDA 生態系的支持下,在高效能計算中仍然有著一定的優勢。在單個系統中,Blackwell可以並列連線多達 576 個 GPU,實作強大的算力和靈活的擴充套件性。

相比之下,谷歌的 Trillium TPU 則註重在大規模分布式訓練中的高效性和低延遲。TPU 的設計使其能夠在大規模模型訓練中保持高效,並透過超高速網絡互連減少通訊延遲,從而提高整體計算效率。

而不僅是在最新一代的 AI 芯片上, 谷歌與輝達之間的「暗戰」實際已經存在了 8 年,從 2016 年谷歌自研 AI 芯片 TPU 就開始。

到今天,輝達的 p00 GPU 是目前主流市場上最受歡迎的 AI 芯片,不僅提供了高達 80GB 的高頻寬記憶體,還支持 HBM3 記憶體,並透過 NVLink 互連實作多 GPU 的高效通訊。基於 Tensor Core 技術,p00 GPU 在深度學習和推理任務中具有極高的計算效率。

但同時,TPUv5e 在性價比上具有顯著優勢,特別適合中小規模模型的訓練。TPUv5e 的優勢在於其強大的分布式計算能力和最佳化的能耗比,使其在處理大規模數據時表現出色。此外,TPUv5e 還透過谷歌雲平台提供,便於使用者進行靈活的雲端訓練和部署。

谷歌數據中心,圖/谷歌

整體來說,輝達和谷歌在 AI 芯片上的策略各有側重:輝達透過提供強大的算力和廣泛的開發者支持,推動 AI 模型的效能極限;而谷歌則透過高效的分布式計算架構,提升大規模 AI 模型訓練的效率。這兩種不同的路徑選擇,使得它們在各自的套用領域中都展現出了獨特的優勢。

不過更重要的是,能打敗輝達的,也只有采用軟硬件協同設計策略,同時擁有強大的芯片能力和軟件能力的對手。

谷歌就是這樣一個對手。

輝達霸權的最強挑戰者

Blackwell 是繼 Hopper 之後輝達的又一重大升級,具有強大的計算能力,專為大規模語言模型(LLM)和生成式 AI 而設計。

據介紹,B200 GPU 采用了台積電 N4P 工藝制造,擁有多達 2080 億個晶體管,由兩塊 GPU 芯片采用互連技術「組成」,並且配備了高達 192GB 的 HBM3e(高頻寬記憶體),頻寬可達 8TB/s。

而在效能上,谷歌的 Trillium TPU 相比上一代 TPU v5e 在 BF16 下提升了 4.7 倍,HBM 容量和頻寬、芯片互連頻寬也都翻了一番。此外,Trillium TPU 還配備了第三代 SparseCore,可以加速訓練新一代基礎模型,延遲更低,成本也更低。

Trillium TPU 特別適合大規模語言模型和推薦系統的訓練,可以擴充套件出數百個 集,透過每秒 PB 級別的網絡互連技術連線數以萬計的芯片,實作另一種層面的超級「電腦」,大幅提升計算效率和減少網絡延遲。

圖/谷歌

從今年下半年開始,Google Cloud 使用者就能率先采用這款芯片。

總的來說,谷歌 TPU 的硬件優勢在於其高效的算力和低延遲的分布式訓練架構。這使得 TPU 在大規模語言模型和推薦系統的訓練中表現出色。然而,谷歌 TPU 的優勢還在於獨立於 CUDA 之外另一個完整的生態,以及更深度的垂直整合。

透過 Google Cloud 平台,使用者可以靈活地在雲端進行訓練和部署。這種雲端服務模式不僅減少了企業在硬件上的投入,還提高了 AI 模型的訓練效率。Google、 Cloud 還提供了一系列支持 AI 開發的工具和服務,如 TensorFlow 和 Jupyter Notebook,使開發者能夠更加便捷地進行模型訓練和測試。

蘋果用上的谷歌 TPU v5p,圖/谷歌

谷歌的 AI 生態系中還包含了多種開發工具和框架,如 TensorFlow,這是一個廣泛使用的開源機器學習框架,能夠充分利用 TPU 的硬件加速功能。谷歌還提供了其他支持 AI 開發的工具,如 TPU Estimator 和 Keras,這些工具的無縫整合大大簡化了開發流程。

此外,谷歌的優勢還在於:谷歌自己就是對 TPU 算力需求最大的客戶。從 YouTube 海量影片內容的處理,到 Gemini 的每一次訓練和推理,TPU 早就融入谷歌的業務體系之中,也滿足了谷歌的巨量算力需求。

可以說,谷歌的垂直整合遠比輝達來得徹底,幾乎完全掌握了從模型訓練到套用,再到使用者體驗的關鍵節點,這實際也給了谷歌更大的可能,可以根據技術和市場趨勢從底層開始最佳化效率。

所以盡管在芯片的效能指標上,Trillium TPU 依然難以和 Blackwell GPU 相抗衡,然而具體到大模型的訓練上,谷歌仍能透過系統性地最佳化效率,比肩甚至超越輝達 CUDA 生態。

在 Google Cloud 用 TPU,是蘋果最好的選擇

簡言之,谷歌 TPU 集群效能、成本和生態的優勢,使其成為大規模 AI 模型訓練的理想選擇。反過來,在 Google Cloud 用 TPU 也是蘋果現階段最好的選擇。

基於 TPU v4 的超算,蘋果也用到了。圖/谷歌

一方面是效能和成本。 TPU 在處理大規模分布式訓練任務時表現出色,提供高效、低延遲的計算能力,滿足蘋果在 AI 模型訓練中的需求。而透過使用 Google Cloud 平台,蘋果可以降低硬件成本,靈活調整計算資源,最佳化 AI 開發的總體成本。

另一方面是生態。 谷歌的 AI 開發生態系也提供了豐富的工具和支持,使得蘋果能夠更高效地開發和部署其 AI 模型,再加上 Google Cloud 的強大基礎設施和技術支持也為蘋果的 AI 專案提供了堅實的保障。

今年 3 月,曾經任職於輝達、IBM 和谷歌的 Sumit Gupta 加入了蘋果,領導雲基礎設施。根據報道,Sumit Gupta 於 2021 年加入谷歌的 AI 基礎設施團隊,並最終成為了谷歌 TPU、自研 Arm CPU 等基礎設施的產品經理。

Sumit Gupta 比蘋果內部絕大部份人都更了解谷歌 TPU的優勢所在。

2024上半年,科技圈風起雲湧。

大模型加速落地,AI手機、AI PC、AI家電、AI搜尋、AI電商……AI套用層出不窮;

Vision Pro開售並登陸中國市場,再掀XR空間計算浪潮;

HarmonyOS NEXT正式釋出,移動OS生態生變;

汽車全面進入「下半場」,智能化成頭等大事;

電商競爭日益劇烈,卷低價更卷服務;

出海浪潮風起雲湧,中國品牌邁上全球化征程;

……

7月流火,雷科技·年中回顧專題上線,總結科技產業2024上半年值得記錄的品牌、技術和產品,記錄過去、展望未來,敬請關註。