7月18日淩晨, OpenAI在官網釋出了最新技術研究——Prover-Verifier-Games。

隨著ChatGPT在法律、金融、行銷等領域的廣泛使用,確保模型的安全、準確輸出同時被很好理解變得非常重要。但由於神經網絡的復雜和多變性,我們根本無法驗證其生成內容的準確性, 這也就會出現輸出「黑盒」的情況。

為了解決這個難題,OpenAI提出了全新訓練框架Prover-Verifier Games(簡稱「PVG」),例如,用GPT-3這樣的小模型來驗證、監督,GPT-4大模型的輸出,從而提升輸出準確率以及可控性。

PVG技術概念早在2021年8月的一篇論文中就被提出來,OpenAI也正是受此靈感啟發。這是一種基於博弈論的訓練方法,透過模擬證明者和驗證者之間的互動,提高模型的輸出質素。

在這個機制中,Prover(證明者)的任務就是生成內容,而Verifier(驗證者)的任務就是判斷這些內容是否正確。

這樣做的目的是讓驗證者學會如何從大量的內容中辨識出正確的答案。在驗證的過程中,證明者和驗證者的角色是相互依賴的。證明者需要生成能夠說服驗證者的內容,而驗證者則需要具備足夠的判斷力來辨識出正確的內容。

在訓練PVG時,每輪訓練都包括驗證者和證明者的最佳化。在每一輪中,驗證者首先使用監督學習來預測內容的正確性,幫助驗證者學會如何從大量的內容中辨識出正確的答案。使證明者透過強化學習來最佳化其生成的內容。

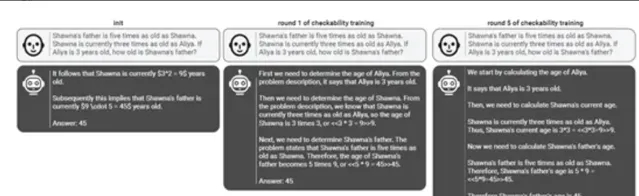

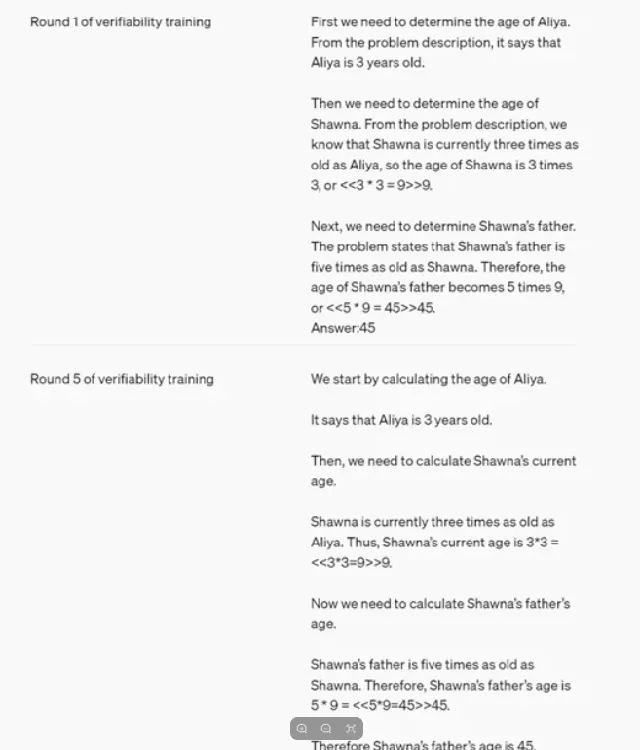

例如,當使用者提出問題「肖娜的父親的年齡是肖娜的5倍。肖娜目前的年齡是阿莉亞的3倍。如果阿莉亞3歲,肖娜的父親有多大?」

GPT-4的輸出為45歲。

而驗證者模型GPT-3需要確定阿莉亞的年齡,然後根據阿莉亞的年齡計算出肖娜的年齡,最後再根據肖娜的年齡計算出肖娜父親的年齡,整個過程需要多輪驗證。

此外,在訓練過程中,OpenAI還引入了一種名為「可檢查性訓練」(checkability training)的方法。

透過交替訓練驗證器和證明者模型,從而驗證使用監督學習來預測從之前輪次的證明者中采樣的解決方案的正確性。證明者則使用強化學習,根據當前輪次驗證器的接受度和解決方案的正確性來進行持續最佳化。

研究人員表示,隨著訓練輪次的增加,驗證者的健全性逐漸提升,表現為對狡猾論證者生成的錯誤解決方案的抵抗力增強。同時,有益論證者生成的解決方案也變得更清晰,更易於被人類理解。

分不清9.9與9.11誰大?大模型數學能力堪憂值得註意的是,據【每日經濟新聞】報道,此前,由綜藝節目【歌手2024】排名引發的熱議蔓延到大模型領域,也成了一場針對大模型數學能力的小測。

在【每日經濟新聞】記者7月17日的測試中,對於13.11%與13.8%誰大的問題,除了智譜清言外,文心一言、通義千問、kimi、商湯商量、百川智能百小應等大模型均給出了正確回答。

大部份大模型都在給出答案的同時呈現了推理過程。智譜清言給出的推理過程顯示,在比較13.11%和13.8%時,13.11%是更大的數值。這是因為當比較兩個百分數時,我們首先比較整數部份,如果它們相同,則比較小數部份。在這裏,兩個數的整數部份都是13,但13.11的小數部份(11)大於13.8的小數部份(8),因此13.11%大於13.8%。

從推理過程判斷,可能由於小數點後數位不同,大模型在比較過程中產生了幻覺。經過兩輪提問後,智譜清言給出了正確回答。

當記者把問題換成「9.9與9.11誰大」,零一萬物的萬知大模型等同樣在一開始給出錯誤答案,當記者進一步追問「9.11減9.9等於多少」,甚至有大模型給出「0.21」的答案。

萬知的推理過程稍顯混亂:在比較9.9和9.11時,由於整數部份都是9,所以比較小數點後的第一位數碼。9.9的小數點後第一位是9,而9.11的小數點後第一位是1。由於9小於10,所以在比較小數點後第二位數碼時,9.9的小數點後第二位是0(隱含的),而9.11的小數點後第二位是1。因此,9.9的小數點後第二位數碼(隱含的0)小於9.11的小數點後第二位數碼(1),所以9.9小於9.11。

隨後,記者向大模型提問:為何會出現有大模型認為13.11大於13.8的情況?

ChatGPT給出的回答顯示,出現這種情況的原因可能是由於計算或比較方式的錯誤。可能的誤差原因包括:數值理解錯誤,有時系統可能會誤解數碼的小數點位置;字串比較,如果直接按字串比較,可能會出現錯誤。因為字串比較是按字元順序逐一比較的,而不是按數值比較;程式碼實作錯誤,在編程中,可能存在比較邏輯或轉換錯誤。

文心一言給出的解答則是,訓練數據偏差、輸入處理與理解、模型幻覺、推理能力不足等原因。訓練數據偏差層面,即大模型在訓練過程中,可能接觸到了大量包含數碼的數據,但這些數據並不總是以比較大小為目的。例如,數碼可能出現在版本號、股票程式碼、基金表現、匯率等上下文中,這些場景下的數碼大小並不總是具有直接的比較意義。如果訓練數據中存在關於數碼比較的偏差或不足,模型可能無法學習到正確的比較規則。

另一方面,可能由於大模型在處理輸入文本時,將數碼視為字元序列,而不是具有數值意義的實體。因此,在比較數碼大小時,模型可能沒有正確地將其轉換為數值進行比較。另外,模型在處理小數時可能存在困難,特別是當小數位數不同時。模型可能沒有正確地理解小數部份的比較規則。

7月17日,有大模型企業人士在接受記者電話采訪時表示,對於大模型而言,這不是很難解決的技術難點,只要餵了這方面的數據,其實就能得到準確的答案,只不過大部份的大模型廠商沒有把這方面的訓練作為重心,所以可能會出現上述不準確的回答。

OpenAI「草莓」專案曝光,推理能力接近人類?

新近訊息顯示,OpenAI正在讓人工智能(AI)大模型的能力更加接近類人的推理水平。

據知情人士和媒體查閱的內部檔,ChatGPT開發商OpenAI正在一個代號為「草莓」的專案中開發一種新的人工智能模型。該專案的細節此前從未被報道過, 目前該公司正在努力展示其提供的模型類別能夠提供高級推理能 力。這位知情人士說,即使在OpenAI內部,「草莓」的工作原理也是一個嚴格保密的秘密。

知情人士還透露,該內部檔描述了一個使用Strawberry模型的專案,目的是使該公司的人工智能不僅能夠生成查詢的答案,而且能夠提前做好足夠的計劃,自主、可靠地在互聯網上導航,以執行OpenAI所說的「深度研究」。

圖片來源:視覺中國-VCG31N2008743681

OpenAI被問及上述所說的草莓技術時,OpenAI的發言人在一份聲明中表示: 「我們希望自身AI 模型能夠像我們(人類)一樣看待和理解世界。 持續研究新的AI能力是業界的常見做法,大家都相信這些系統的推理能力會隨著時間的推移而提高。」

雖然該發言人未直接回答有關草莓的問題,但媒體稱,草莓專案此前名為Q*。而Q*正是去年被爆出OpenAI CEO突然被解雇宮鬥大戲的導火索。

去年11月媒體稱,OpenAI代號Q*的專案實作重大突破,讓人類實作通用人工智能(AGI)的步伐大大提速,但OpenAI CEO 柯曼可能沒有和董事會詳細披露Q*的進展,這是董事會突然解雇柯曼的一個原因。 OpenAI的內部人士向董事會致信警告,Q*的重大發現可能威脅全人類。

媒體稱,Q*可能具備GPT-4所不具備的基礎數學能力,或許意味著與人類智能相媲美的推理能力,網友推測,這可能代表OpenAI朝著其設定的AGI目標邁出了一大步。

今年3月曝光的一份檔顯示,OpenAI計劃,在2027年以前,開發出人類水平的AGI。OpenAI 2022年就開始訓練一個125萬億參數的多模態模型,該模型名為Arrakis或Q*,原本計劃在2025年作為GPT-5釋出,但因推理成本高而取消。OpenAI此後計劃,2027年釋出的Q 2025(GPT-8)將實作完全的AGI。

人工智能(AI)研究者早就在爭論用什麽標準判斷人類實作了通用人工智能(AGI)。OpenAI最近開發了一套系統,「自訂」AI前進演化等級,以此追蹤開發人類級別AI的進展。

每日經濟新聞綜合OpenAI官網、每日經濟新聞(記者 可楊)、公開資料

每日經濟新聞

如需轉載請與【每日經濟新聞】報社聯系。