人工智能,被譽為是人類的未來。我們期待人工智能可以幫助醫生、心理學家、警察和軍人等工作,甚至取代駕駛員以及運動員。人工智能真的已經達到足夠智能的程度了嗎?人們真的可以相信人工智能的決定嗎?在人工智能領域實踐多年的程式設計師以及人工智能研究者,卻向人們發出了警示。

非政府組織演算法觀察成員馬蒂亞斯·斯皮爾坎普說:「數碼技術的快速發展讓我們以為,憑借數據和計算就能解決人類面臨的一切問題。這只是一種錯覺。」

真相一:獲得問答冠軍的人工智能,本質只是一個搜尋引擎

2011年,IBM公司為了宣傳自身技術,推出了【危險邊緣】特別節目,讓最優秀的人類冠軍與其新開發的人工智能沃森直接對決。現場,人工智能沃森以最快速度流利應答,在節目中輕松取勝,節目結果讓人們覺得,人工智能已然具備了理解人類語言的能力。

其實,人工智能沃森並不能真正與人類溝通,它本質上只是一個以網絡百科全書作為數據庫的搜尋引擎。

而在聯合國一個宣傳人類技術進步的活動中,也出現了人機對話的場景。

聯合國參會人士:「好的。我想再問你一個問題,世界上很多地方還沒有網絡,也沒有電,聯合國可以做什麽來幫助他們呢?」

機器人:「好訊息是人工智能和自動化可以用更少的資源獲得更好的結果,所以,如果人工智能的智慧水平能夠進一步提高並專註雙贏的結果,人工智能則可以幫助人們充分分配世界上現有的資源,包括食物、能源等等。」

而其後有節目報道,這段機器人的回答,其實也是提前準備好的。

真相二:人工智能轉譯器只能提供一般性答案

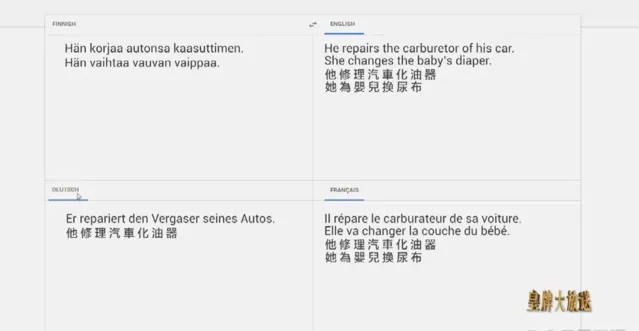

像谷歌轉譯那些自動轉譯工具,使用的資源是來自一些可免費存取的網站,例如一些政府部門、機構的官網或者網絡百科,人們早已將很多文字譯成了多種語言。人工智能轉譯器往往會自動運用人類最常用的詞組作為譯文,並不會根據特定情況進行分析,所以很多轉譯結果,也揭示了人們固有的刻板觀念。

比如,在芬蘭語中,代詞男他和女她都是用「hän」表示,但機器在轉譯修理汽車化油器的主語時,會自動轉譯為男他,在轉譯為嬰兒換尿布的主語時,會自動轉譯為女她。轉譯器自動生成可能性最高的結果,並不會參考任何個人經歷。

谷歌工程師弗朗索瓦•肖萊說:「例如歐洲議會語料庫,這些文本並不能代表你我之間的那種交流。系統永遠會向適中的情況靠攏,因為這是它們的運作方式。」

真相三:人工智能深度學習技術存在偏見和刻板印象

深度學習是指,機器透過人類輸入的各種數據資料進行自我學習,以幫助人類解決特定的問題。比如機器透過學習萬千張動物的圖片,來辨識不同的動物,除此之外,深度學習技術還有其他現實套用。在美國有十幾個州,案件審訊時都會參考一款人工智能軟件,它能幫助法官預測被告再次犯案的風險及可能性。這款人工智能軟件的數據,來自於美國警方的罪犯數據庫,系統采用一個秘密公式來分析罪犯的136項指標,最終,得出罪犯再次犯案可能性的總分,送出給法官。

一些嚴謹的記者將這款軟件對7000個犯人的評分,與他們真實的行為做了一個對比,結果發現,對嚴重犯罪行為的預測正確率僅為20%。一些記者還表示,軟件對黑人再次犯罪的預測結果,普遍比實際高,對白人再次犯罪的預測結果卻比實際低。

谷歌前研究員梅雷迪斯·惠特克說:「很多國家或地區的刑事司法智能系統,極有可能像美國一樣,帶有種族主義色彩,所以需要在數據中建立應對黑人偏見的設定。」

谷歌工程師弗朗索瓦·肖萊又舉了一個例子來講述人工智能系統偏見的來源:「這種偏見源於訓練期間所接收的數據,訓練數據可能本身存在偏見。請大家設想有這樣一個系統,它能夠檢查監控錄像,來判斷某個人是否可疑。要打造這種系統,首先需要標註員(真人),對監控錄像畫面進行標註,判定錄像中的某個人是否可疑。毫無疑問,在這個步驟中,標註員是基於主觀作出判斷的,這種判斷會存在潛在偏見。」

真相四:人工智能目前還不能幫助醫生診癥

延續【危險邊緣】節目中人工智能沃森的大熱,IBM緊接著研發了人工智能醫生。之後經過六年,又投入了100億美元,研發了一款專門用於治療癌癥的沃森腫瘤解決方案。

而這款軟件卻沒有預想中先進,需要醫生手動輸入患者數據。不僅如此,沃森只能提供美國標準的治療方案。根據醫生反映,對於那些復雜的病例,沃森根本毫無幫助,並沒有達到其宣稱的能力。

谷歌工程師弗朗索瓦·肖萊說:「醫學與現實世界息息相關,而現實世界是千姿萬態的,你遇到的每一個病例,都與之前你遇到的病例間存在細微的差異。因此,你必須根據每一個新病例來調整以前使用的診療方針。如果你的診療方針一成不變,其執行程式也一成不變,那麽它們就難以適用於新的病例。」

最後沃森腫瘤解決方案只被全球50家醫院購買。2021年,IBM公司還遭受了猛烈的批評,沃森被迫全部下架。

真相五:人工智能並無感知能力,只有回答,沒有表達

在人類的頭腦中,意義是透過體驗產生的:上下頜用力咬合、門牙穿透光滑的果皮、果汁滲出並順著喉嚨流下,種種體驗定義了什麽是蘋果。然而,對於電腦系統而言,蘋果只是一系列與文本數據相關聯的像素。

谷歌工程師弗朗索瓦·肖萊說:「我們可能認為深度學習模型能夠理解影像的內容。但實際上,深度學習模型只是將影像和文本聯系起來的一種方式,與人類看見圖片,並用語言描述其內容的方式是完全不同的。」

人工智能永遠無法體會腎上腺素飆升或淚如泉湧的真正感覺,它不懂什麽是害怕,不會起雞皮疙瘩,對痛苦或快樂沒有概念,無法欣賞抽象藝術,也沒有曾被壓抑的創傷。因此,人工智能也沒有什麽需要表達。

人工智能模仿的,僅僅是人類思維的結果,而並非過程。

真相六:人們有時無法了解人工智能得出結論的過程——不透明的黑匣子

深度學習源於控制論,控制論是小算盤學家從神經科學中獲得啟發,而形成的研究領域。深度學習系統類似於一個巨大的相連的網絡,借鑒了人類大腦中神經元的結構。在這個仿制的神經元網絡中有很多設定,能夠加強或衰減不同鏈路之間的訊號,直到最終訊號能夠解答人類的問題。

機器學習系統有著數以億計的不同設定,十分復雜,以至於連程式設計師自己也不知道,該用什麽判斷標準來檢測系統。所以他們想出了一個詞匯來描述這種復雜的設定:黑匣子。

美國杜克大學電腦科學研究員辛西婭·魯丁說:「黑匣子機器學習模型,是一種預測模型。它要麽復雜到人類無法理解,要麽屬於私有,也就是說,我們根本無法一窺其中的奧秘,也無法了解它們運算的方式。所以,我們不能用黑匣子模型來做出高風險決策。實際上,要做出更好的決策,我們的確需要了解這些預測模型的工作原理。」

真相七:「這是機器的決定」這種說法,有時是一些人逃避責任的方式

如今,一些人工智能互動界面在不斷被推廣,比如銀行人工智能客服、電訊公司人工智能客服。在這些友好智能互動界面背後,是一些數據處理協定框架,當中,有一些並不透明的決策系統,其實正在日益被推廣。

非政府組織演算法觀察成員馬蒂亞斯·斯皮爾坎普說:「我們可以看到,一些公司樂於推卸責任,他們會說,‘我們用復雜的機器系統協助工作’、‘是演算法出了錯,與我們無關’。這種辯解或借口完全讓人無法接受。」

谷歌前研究員梅雷迪斯·惠特克說:「如果你想逃避責任,並且希望做出困難決定後不會被追究責任,那麽就推給機器,這是很多人的一個選擇。」

真相八:全世界還沒有一台完全自動化的無人駕駛汽車

作為人工智能的代表技術,無人駕駛汽車揭示了人們對全自動化服務的幻想。人們希望人工智能可以隨時幫人們做出駕駛決策,既保證安全駕駛,又節省下人們的時間。

但這個已經投入了超過800億美元的產業,到目前為止,還沒有一台可以完全自動、無人駕駛的汽車,人類駕駛員需要隨時候命、準備介入。

谷歌工程師弗朗索瓦·肖萊說:「人們輕易就使用深度學習系統,然後以某種非常困難的事情為藍本,例如駕駛,打造出一個並不可靠的原型。但想要開發這種原型系統、使其足夠可靠、並且在實際套用中足夠高效,是相當困難的,能夠上路都相當不容易。」

真相九:為人工智能系統糾正、補漏的工作,正成為一種全球新經濟

過去十年裏,像無人汽車幕後駕駛員這類,圍繞人工智能進行的人為輔助工作,催生了一種全球新經濟。現在,全世界有數十萬工人,正負責為機器編制訓練數據,並監督、糾正機器的反應,或者直接取代機器進行人為操作,而他們的收入並不高。

2005年,全球科技巨頭亞馬遜公司創始人傑夫·貝索斯宣布,推出亞馬遜土耳其機器人,他當時坦率地承認,這是「人工的人工智能」,或可以稱之為假人工智能。其背後需要人類付出勞動,手動控制,從而來實作演算法運作。

亞馬遜土耳其機器人是一個求職平台,采用了被廣泛套用的自動化決策系統,但它卻陷入了一個悖論,因為這套人工智能系統,根本做不到完全自主,需要人在幕後協同操作。土耳其機器人這個名稱源於18世紀一台假的自動下棋機,機器的底座裏,其實有一位人類棋手正藏在裏面。

谷歌前研究員梅雷迪斯·惠特克說:「他們把行業裏本該閉口不談的事說了出來。」

真相十: 人工智能可能成為一群人控制另一群人的工具

一個截然不同的未來正在形成:現實情況是,並沒有一台機器足夠智能到可以取代人類,而人類卻正在不斷適應機器的某種標準化邏輯。

在呼叫中心裏,人類必須遵照機器的演算法來進行對話。通話程式會辨識人類對話中的關鍵詞,並確保預訂的方案得到執行,還會對員工及客戶的表述進行情緒分析。如果情況偏離正軌,系統會提示客服「要表示感同身受」等建議。對話結束後,系統還會對員工進行打分,如果得分低於預期水平,員工將會被自動解雇。

【人工智能或世紀挑戰】作者、哲學家艾歷·薩丁說:「這意味著一大批人需要被迫調整自己,來適應人機聯合運作。而這些系統設計的初衷,不就是為了最大化人的生產率,盡可能最佳化人們的生產嗎?為何如今人類卻沒了回轉的余地。在我看來,自動化是我們設定的其中一種形式或者說是騙局,用來約束普羅大眾。」

加拿大蒙特利爾大學電腦分析師、2018年圖靈獎獲得者約書亞·本吉奧說:「最令我感到擔憂的,不是電腦出錯,而是那些渴望權力,想要控制他人的人開始註意到這種強大的技術。」

編輯:黃博