西風 發自 凹非寺

量子位 | 公眾號 QbitAI

OpenAI的AI語音轉寫工具,那個號稱近乎「人類水平」的Whisper

,被曝幻覺嚴重——

100多小時轉錄,被工程師發現約一半都在瞎扯。

更嚴重的是,美聯社還爆料有醫療機構利用Whisper來轉錄醫生與患者的會診,

瞬間引發大量網友關註。

據悉,明尼蘇達州的曼卡托診所和洛杉磯兒童醫院在內的超過30000名臨床醫生和40個衛生系統已開始使用法國AI診療公司Nabla基於Whisper打造的工具。

而且他們已經轉錄了大概700萬次

醫療就診。

網友紛紛表示這就有點嚇人了。

值得一提的是,OpenAI之前早就警告過,該工具不應在「高風險領域」中使用

。

針對最新爆料,有OpenAI發言人回應,OpenAI會在模型更新中加入相應的反饋機制。

OpenAI被督促趕緊解決此問題

Whisper是OpenAI老早前推出的開源自動語音辨識(ASR)系統,於2022年9月釋出。

它采用簡單的端到端方式,基於編碼器-解碼器Transformer架構。輸入音訊將被分成30秒的塊,轉化為梅爾倒譜(音訊特征提取方式之一,log-Mel spectrogram),然後傳入編碼器。

經過68萬小時的多語言和多工監督網絡數據的訓練,Whisper可以進行多語言轉錄。

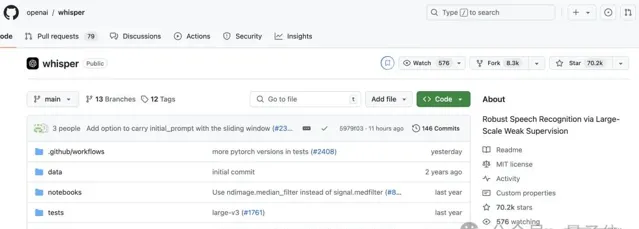

Whisper推出後得到廣泛套用,如今GitHub已攬獲70.2k標星:

據悉,它還被整合在ChatGPT的一些版本中,同時也是Oracle和微軟雲端運算平台的一項內建服務,而這些平台為全球數千家公司提供服務。

此外,僅在上個月,HuggingFace上的一個最新版本Whisper就被下載了超420萬次。HuggingFace社區的機器學習工程師Sanchit Gandhi表示,Whisper是最受歡迎的開源語音辨識模型。

而現在,據美聯社報道,很多研究人員和工程師反映,在工作中他們經常遇到Whisper產生的幻覺。

例如,密芝根大學的一位研究員在嘗試改進模型之前,發現其檢查的每10份音訊轉錄中有8份出現了幻覺。

一位機器學習工程師指出,在他分析的超過100小時Whisper轉錄中,大約一半出現了幻覺。

還有一位開發者表示,在他使用Whisper建立的26,000份轉錄中,幾乎每一份都發現了幻覺。

……

這種問題甚至存在於錄制良好的短音訊樣本中。

在最近的一項研究中,電腦科學家們在審查的超過13000個清晰音訊片段中發現了187個幻覺。

工程師和研究人員表示,他們從未見過其它任何AI驅動的轉錄工具像Whisper這樣頻繁地產生幻覺。

Whisper幻覺嚴重的原因目前尚未可知,但有軟件開發者表示,這些虛構內容往往發生在停頓、有背景聲音或音樂播放時

。

之前,OpenAI就有提醒:

不要在決策情境中使用Whisper,準確性上的缺陷可能導致結果出現明顯偏差。

然鵝,美聯社表示,這一警告並未阻止一些醫院或醫療中心使用Whisper等語音轉文字模型——

包括明尼蘇達州的曼卡托診所和洛杉磯兒童醫院在內,已經有超30000名臨床醫生和40個醫療系統已經開始使用由Nabla公司基於Whisper開發的工具。

Nabla CTO Martin Raison稱,該工具針對醫療語言對模型進行了微調,用於轉錄和總結患者的交流。

目前,該工具已被用於轉錄約700萬次醫療就診。

在得知Whisper可能會產生幻覺後,Nabla表示正在解決此問題,不過:

由於「數據安全原因」,Nabla的工具會刪除原始音訊

,無法將Nabla生成的AI文本與原始錄音進行比較。

此外,據了解,Whisper還被用來為聾人和聽力障礙者建立字幕。

Whisper幻覺嚴重問題被發現後,有人敦促OpenAI趕緊解決此問題。

今年2月離開OpenAI的研究員William Saunders也開麥了:

如果公司願意優先考慮,這似乎是可以解決的。如果你把它放出去,人們過於自信於它的功能,並將其整合到所有這些其他系統中,那就成了問題。

有OpenAI發言人回應稱,公司持續研究如何減少幻覺現象,並感謝研究人員的發現,同時補充道OpenAI會在模型更新中融入相應反饋機制。

參考連結:

[1]https://apnews.com/article/ai-artificial-intelligence-health-business-90020cdf5fa16c79ca2e5b6c4c9bbb14

[2]https://x.com/AP/status/1850150400424345858