作者 | 李水青

編輯 | 心緣

智東西7月30日報道,當地時間7月29日,蘋果釋出iOS 18.1開發者測試版,上線 Apple Intelligence的首個版本 ,同時47頁的 蘋果自研大模型技術報告 重磅釋出。

Apple Intelligence首個版本上線了以下AI功能:

1、Siri升級。 Siri喚醒後具備螢幕邊緣發光特效,能理解使用者表述不通順的指令,且能回答關於蘋果產品故障解決的相關問題。

2、寫作工具 升級。新版iOS提供蘋果的文本生成服務;同時支持AI生成郵件、資訊,語音轉錄摘要等功能。

3、檢視工具升級。 該版本提供更智能的圖片搜尋及電影回憶制作功能。

仍有不少蘋果在6月釋出的AI功能未出現在iOS 18.1開發者測試版(【蘋果AI一夜顛覆所有!Siri史詩級前進演化,內掛ChatGPT-4o,柯曼來了,馬斯克怒了】),蘋果稱計劃在明年推出,包括:

1、Siri的其他改進 ,包括個人資訊分析,聯動外部套用執行任務等。

2、影像視覺生成功能 ,包括表情符號的生成,以及自動清理照片等檢視相關能力等。

3、OpenAI旗下ChatGPT的整合等。

iPadOS 18.1、MacOS Sequoia 15.1也植入了相關Apple Intelligence新功能,不過它們目前都僅向每年支付99美元的註冊蘋果開發者開放。

在今天釋出的論文中,蘋果透露了其 兩款蘋果基礎模型 (Apple Foundation Model,簡稱「AFM」)。

論文連結:https://machinelearning.apple.com/papers/apple_intelligence_foundation_language_models.pdf

一個是 30億參數 的端側模型 AFM-on-device ,經最佳化可在iPhone和其他器材上高效執行;另一個是雲端模型 AFM-server ,尚未公布模型參數。

報告首次對AFM的 模型架構、訓練數據、訓練過程、推理最佳化及評估結果 進行了解讀,並提到背後模型的訓練采用的是累計 10240顆谷歌TPU ,而未提及輝達GPU。

根據論文描述,蘋果自研大模型在 指令遵循、文本總結 方面測試 超GPT-4 。

本次,蘋果iOS 18.1開發者測試版上線的Apple Intelligence功能,主要覆蓋Siri、寫作工具、郵件提要、照片自然語言搜尋等方面。

1、整個螢幕閃起光環,Siri變身

Siri的變化首先是新外觀,此前螢幕上出現的圓形光斑,被環繞螢幕的發光燈取代,以表示助手處於活動狀態。

當開發者不想大聲對Siri說話時,開發者可以從語音命令切換到鍵入:雙擊iPhone或iPad螢幕底部即可調出鍵盤,用於輸入Siri查詢和命令。

Siri已經能夠理解多個指令上下文。例如,開發者可以要求Siri建立日程,然後要求建立提醒,而無需重復前面說的話。

2、寫作工具上線,潤色語句、郵件提要

寫作工具是Apple Intelligence的一大賣點,支持開發者就語氣和措辭提出建議,校對文本並總結要點。

錄音轉錄功能也已經可以體驗,在iOS 18.1開發者測試版,語音備忘錄應用程式以及Notes套用已經內建了錄音轉錄功能。

寫作功能既適用於蘋果器材的內建應用程式,也可用於使用標準輸入文本系統的第三方應用程式。

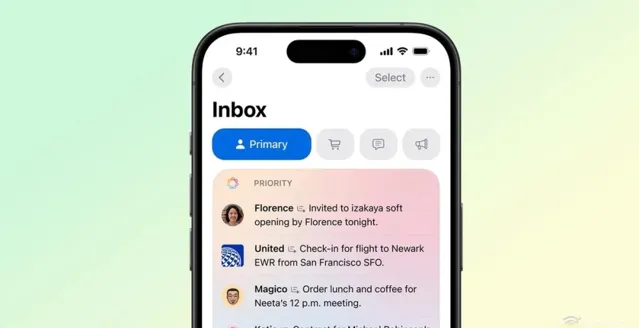

郵件套用現在會智能辨識優先郵件,並將在收件箱頂部出現提醒浮窗,以提醒開發者特定的截止日期,或避免忘記一些重要行動事項。

此外,新版本還支持專註模式,稱為「減少幹擾(Reduce Interruptions)」,該模式將使用AI辨識過濾重要的通知。

3、自然語言互動搜尋照片,AI生成短片

開發者已經能夠使用自然語言尋找影片和照片。比如查詢「我女兒吃芝士漢堡的照片」,蘋果將提供對應的搜尋結果。它應該可以更輕松地在影片中找到特定影像或確切時刻,而無需使用更通用的關鍵字。

新的電影回憶(Movie memories)功能可讓開發者輸入特定提示,使用照片套用中儲存的照片和影片制作電影。

開發者可以輸入自己的提示或使用Apple Intelligence建議的提示詞,獲得智能生成的電影,影片具有明確的章節和主題。

Apple Intelligence這些已上線的功能仍有一些使用限制。

目前,Apple Intelligence僅向每年支付99美元的註冊蘋果開發者開放,包括面向iOS、iPad和Mac的三個版本。開發者需要將器材區域設定為美國,語言設定為美國英語。

此外,此前6月報道曾提到,Apple Intelligence要求器材達到iPhone 15 Pro、iPhone 15 Pro Max或配備M1的iPad和Mac及以上配置。

相比於當下各家的AI手機,蘋果自研模型的一大特點,是推出在器材上執行的端側模型。

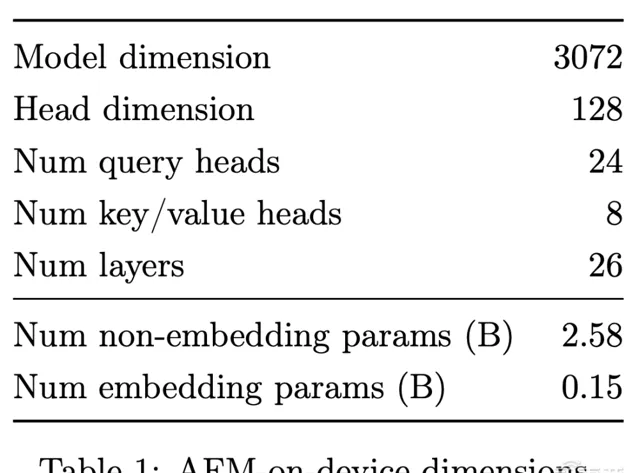

根據蘋果今日最新釋出的論文,該端側模型名為AFM-on-device,包含約30億參數,遠小於OpenAI和Meta等公司模型的千億參數級別。

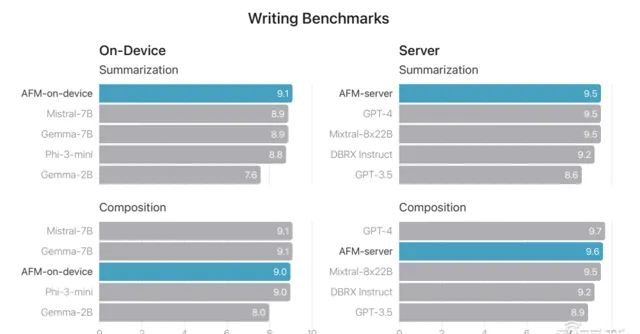

為了執行更復雜的任務,蘋果也開發了雲端模型AFM-server。雖然具體大小尚未透露,但它旨在使用名為「私有雲端運算(Private Cloud Compute)」的系統在蘋果的雲基礎設施中執行,以保護使用者數據。

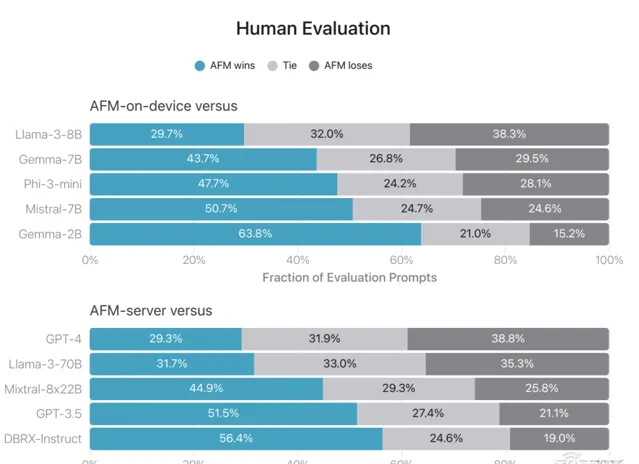

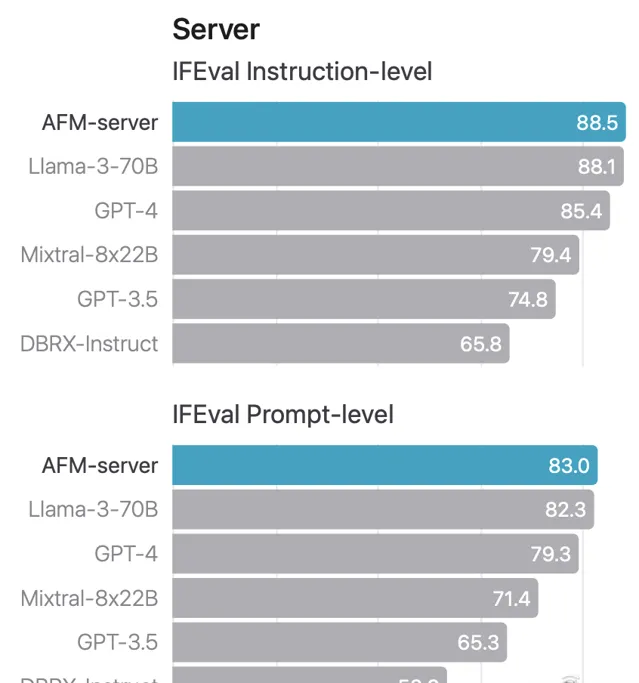

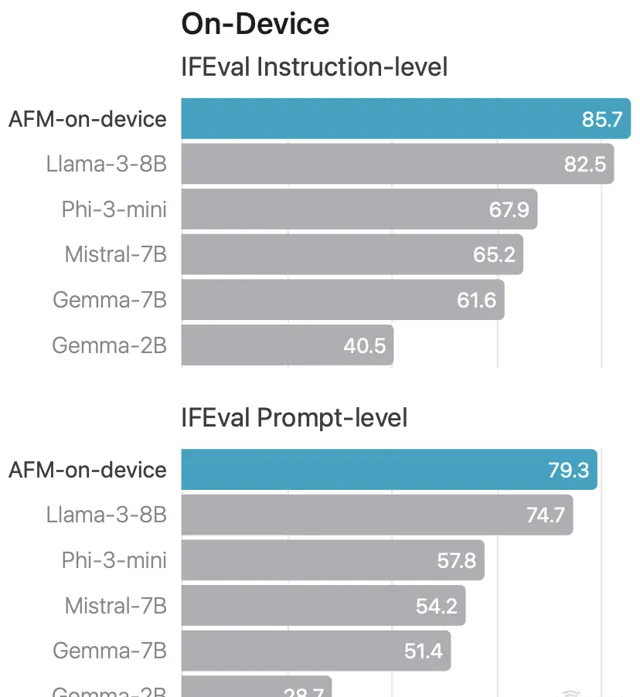

如下圖所示,AFM-on-device在人類測試中超越了Phi-3-mini、Mistral-7B、Gemma-2B等開源模型,接近Llama-3-8B的水平。

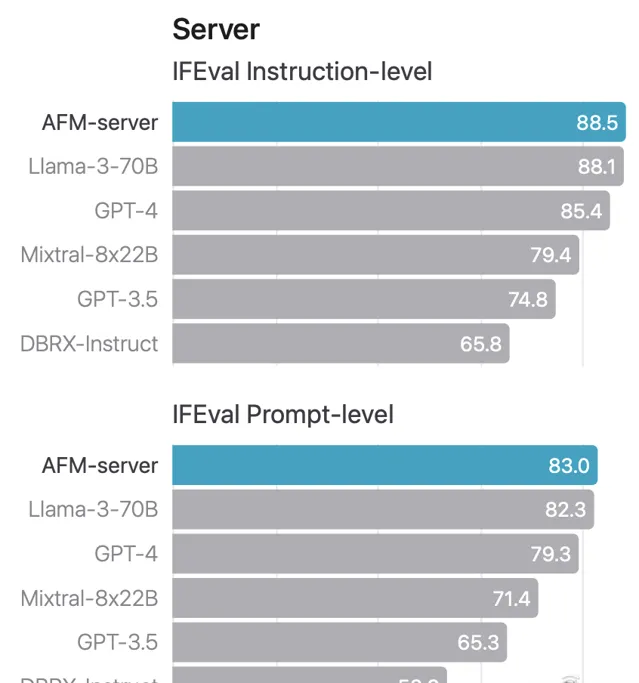

AFM-server在人類測試中超越Llama-3-70B、Mixtral-8x22B、GPT-3.5等閉源模型,接近GPT-4的能力。

同時,在指令遵循方面,AFM-server測試超GPT-4,AFM-on-device則超越了Llama-3-8B、Phi-3-mini等開源模型。

在文本總結方面,AFM兩個版本也實作領先。

在架構方面,這兩個基礎模型包括一個基於AFM語言模型的編碼模型,用於將智能融入Xcode,以及一個擴散模型,以幫助使用者生成一些視覺內容。

其中,AFM基礎模型是僅解碼器的密集模型,它們建立在Transformer架構之上,並做了一些設計最佳化,包括分組查詢註意力(GQA)、SwiGLU啟用函數等。

研究人員在論文中解釋道,Apple Intelligence由多個高效能生成模型組成,這些模型快速、高效、專門用於使用者的日常任務,並且可以根據使用者操作進行動態調整。

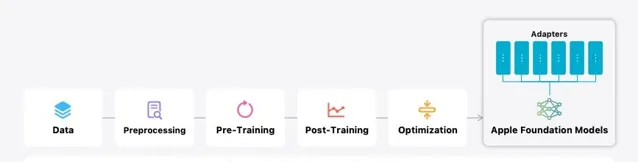

▲Apple Intelligence的架構

蘋果展示了其模型開發的流程,強調從數據收集到模型部署的每個階段,其都遵循負責任的AI原則。

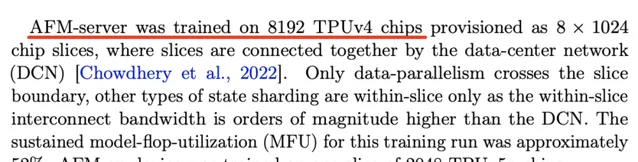

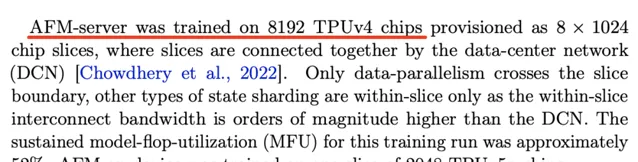

在模型訓練方面,蘋果雲端大模型采用了8192顆TPUv4芯片,端側采用了2048顆TPUv5p芯片,並未用到輝達GPU。

模型訓練後工作包括一系列數據收集和生成、指令調優和對齊創新,涉及監督微調(SFT)和基於人類反饋的強化學習(RLHF)兩個階段,提高模型遵循指令、推理和寫作方面的能力。

據稱,這些模型是在多樣化的數據集上進行訓練的,包括網頁、來自出版商的授權內容、程式碼儲存庫以及專門的數學和科學數據。蘋果稱其未使用私人數據訓練模型。

時隔一個月,蘋果終於上線了首批Apple Intelligence能力,在Siri、寫作工具、檢視檢索等方面首先更新;與此同時,蘋果兩款自研模型曝出,讓我們對Apple Intelligence的核心模型有了深入了解,並不是有媒體傳的「ChatGPT套殼」,展現出有別於其他手機玩家的差異化打法。

不過,當下Apple Intelligence能力僅部份開發者可以用到。據外媒報道,蘋果仍在修復許多新功能的漏洞,因此使用者將不得不等待才能測試這些功能。蘋果將會帶來什麽樣的AI手機體驗?我們拭目以待。