引言

Gp169 合金是中國航空發動機的骨幹材料,在航空發動機的高溫部件使用率超過 50% ,隨著航空發動機第四代和第五代的研制,對 Gp169 合金的使役效能也提出了更高的要求。 隨著冶煉工藝與成型制備技術的精進,Gp169 合金雖已基本滿足中國航空發動機的需要,但與國外 Inconel718 合金相比還存在著不小的差距,主要表現在冶煉工藝不合理或技術參數不精準造成的冶金黑斑以及合金組織均勻性較差造成的加工後的裂隙和淺坑[1]。

這些由於技術不成熟造成的缺陷很有可能成為應力集中的薄弱環節,成為破裂和腐蝕的根源。 因此,找到合金組織表面的缺陷對於分析這些缺陷的成因以及提高合金冶煉工藝有著重要的意義。 傳統的檢測都是由研究員使用掃描電鏡人工檢測組織表面存在的缺陷,這樣不僅效率低下,而且很容易由於視覺疲勞出現錯檢漏檢的情況。 傳統的機器視覺檢測方法如 Canny 邊緣檢測[2]、Prewitt 算子[3] 和小波變換[4]等透過手工設計提取特征,由於缺陷較小且有些缺陷顏色和背景相差不大造成魯棒性較差,檢測精度較低,無法滿足實用要求。

摺積神經網絡在提取特征方面有非常強大的能力,相比較手工提取的特征,摺積神經網絡提取的特征可以達到更好的效果[5]。 因此,該文將 RetinaNet[6] 模型套用於 Gp169 合金組織表面缺陷檢測上,並且針對 RetinaNet 網絡對小目標檢測不敏感的問題進行改進,提出了一種 CA - RetinaNet 檢測演算法。 首先, 在RetinaNet 網絡模型中引入了一種 CA-Resnet 結構代替原來的殘留誤差結構[7],增強網絡提取特征的能力;之後重新構建了特征金字塔網絡[8] 的底層結構,刪除了原來的 P7 有效特征層,重新構建了 P2 有效特征層,提高了網絡模型對於小缺陷的檢測能力。

1、模型設計

RetinaNet 結構上由特征提取網絡、FPN( 特征金字塔網絡)和兩個 FCN 子網絡共同組成。 ResNet 網絡負責提取影像的特征,FPN 針對提取到的特征進行多尺度語意融合以獲得表達力更強的特征圖,最後將這些特征圖輸入到兩個 FCN 子網絡中,從而完成目標框的分類和回歸任務。 由於 Gp169 合金組織表面缺陷形貌和一些偽缺陷接近並且大部份缺陷像素占比較少,因此使用傳統 RetinaNet 檢測演算法進行檢測效果並不理想。 該文提出的 CA-RetinaNet 網絡在 RetinaNet的基礎上,參照了 CA-Resnet 結構,並且重新構建了FPN 層,從而提高了缺陷檢測的準確率。

1.1、 CA-Resnet 模組

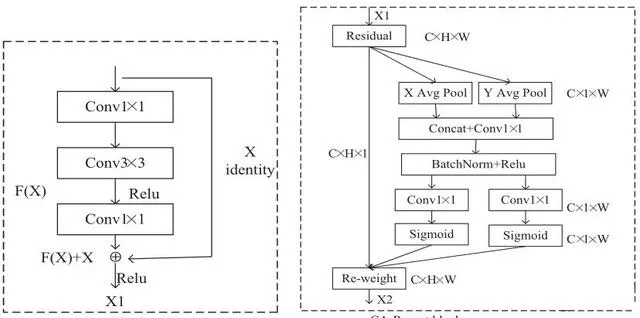

CA - Resnet模組是由Resnet 模 塊 和 CA[9](Coordinate Attention)模組兩部份構成的,其主要結構如圖 1 所示。

Resnet 模組又被稱為殘留誤差模組,其主要思想是提出了一種 shortcut 的形式將前後層直接相連,使得後層網絡也可以得到前層網絡提取到的資訊。 這種方法可以更好地學習輸入與輸出之間的殘留誤差 H(X) - X[7],使得神經網絡可以更好的被訓練,在一定程度上解決了網絡退化的問題。 但在使用 Resnet50 對合金組織表面缺陷進行特征提取時發現,較小缺陷在經過多次降采樣 後,特征逐漸消失。 為了解決這個問 題, 在Resnet50 中插入了CA模組。

CA 模組可以最佳化神經網絡學習到的參數,在強調有用特征的同時,抑制幹擾性背景特征,以此來增加神經網絡學習到的感興趣的目標權重。 其主要結構如圖 1 中 CA-Resnet 模組所示。CA模組主要分為Coordinate 信 息 嵌 入 和Coordinate Attention 生成兩個步驟。 Coordinate 資訊嵌入主要是為了註意力模組可以捕捉到精確的遠端空間互動資訊。 特征圖經過特征提取網絡後得到大小C ×W × H 的 X1 特征圖,而後使用尺寸為( H ,1) 和(1, W )的平均池化函數分別沿水平方向和豎直方向對每個通道進行編碼輸出大小為 C ×1× W 的特征圖。

Coordinate Attention 生成將以上的變換產生的兩個特征圖進行 concatenate 操作,接著使用一個共享的 1×1的摺積進行變換、經 BN 操作和 Relu 非線性變換後生成大小 C / r ×1×( W + H )的張量和,然後利用兩個一維摺積變換將張量和變換為具有相同通道數的張量輸入到 Sigmoid 啟用函數中,使用適當的縮減比來降低模型的復雜度,最後將學習到的權重與原始特征圖的每一個通道進行相乘,得到註意力權重的 X2 特征圖。

這樣 CA 模組不僅完成了通道權重的最佳化,同時也捕捉到了水平方向和豎直方向上目標的資訊。 比起 SE-Net[10](Squeeze-and-Excitation Networks) 只註重通道之間的關系,CA 模組將位置資訊與通道之間關系進行了互補,同時又避免了較大的計算開銷。 該文在CA-RetinaNet 網絡中使用 CA-Resnet 模組進行特征提取,對影像中的目標進行通道特征增強,提高了神經網絡提取特征的能力以及檢測精度。

1.2、 重建特征金字塔網絡

特征金字塔網絡是一種自頂向下且帶有側向連線的網絡,它可以融合低層網絡和深層網絡提取到的語意資訊,實作多尺度預測。 在摺積網絡提取影像的過程中,大的目標特征點容易得到保留,小目標特征點容易被跳過,特別是經過很多層摺積和池化之後,小目標的特征資訊會越來越少,這對於小目標檢測非常不利。

而特征金字塔網絡,在對特征點進行下采樣後重新進行上采樣,並且將下采樣與上采樣中長寬相同的特征層進行堆疊,這樣就可以保證小目標的特征與資訊不會完全遺失。

在 RetinaNet 網絡中,特征金字塔網絡由 P3 ~ P7五種尺度特征構成[11],其中 P3(75,75)和 P4(38,38)用來檢測小目標,P5(19,19)、P6(10,10)、P7(5,5) 用來檢測大目標。 該文所使用的數據集大都是中小類別的缺陷,而 FPN 網絡所產生的 P7(5,5)有效特征層卻是用來檢測大目標。 因此,在 CA-Retinanet 中刪去 P7有效特征層,重新計算 CA-Resnet 所提取到的 C2 特征圖,將 P3 有效特征層進行上采樣後與其融合得到一個新的有效特征層,該文將新建立起來的有效特征層成為 P2 有效特征層,用來檢測較小尺度的目標。 具體如圖 2 所示。

另外,為了配合 P2 有效特征層的檢測尺度,將 anchor 的尺寸從(32,64,128,256,512) 調整為(16,32,64,128,256),以便網絡更加精準地定位目標。

1.3、 Focal Loss 損失函數

Focal Loss 損失函數由常用的交叉熵損失函數(CE)變形而來,是為了平衡正負樣本而提出來的一種新的 loss 計算方案,其具有兩個特點:(1)控制正負樣本的權重。(2)控制容易分類和難分類樣本的權重。

其公式如下:

其中, y 表示真實值, Pt 表示估計概率, P 表示概率,透過設定 琢 值(0-1 之間)控制正負樣本對 loss 的貢獻,透過控制 Pt 的值來控制權重的大小, Pt 越大則權重較大, Pt 越小相應的權重也就越小,以此來抑制那些容易分類的樣本權重,提高難分類樣本的權重。 有效地解決了正負樣本不平衡的問題。

2、 實驗分析

2.1、 數據集

2.1.1、 數據集介紹

實驗采用的 Gp169 合金來自於中航上大高溫合金材料有限公司,采用真空感應-氣氛保護-真空自耗「三聯冶煉技術」及鍛造工藝生產的大棒材。 從Gp169 合金鍛件大棒上截取樣品長條,經線切割、熱鑲、磨樣、拋光後,使用配比為 20 ml 鹽酸+20 ml 無水乙醇+1.5 g 五水合硫酸銅的腐蝕溶液進行化學腐蝕[12],再采用日本產尼康 LV100ND 金相顯微鏡進行影像數據采集,共獲取1882 張圖片。 檢測的目標分別是由於技術原料原因造成的缺陷(defect)、在磨樣過程 中 造 成 的 劃 痕 ( scratch ) 以 及 沾 上 的 附 著 物

(attachment)。 圖片分辨率大小為 512×512, 使 用LabelImg 軟件對影像中的缺陷、劃痕以及附著物進行標註,數據標註格式為 PascalVOC 格式。 采集到的數據影像如圖 3 所示。

2.1.2、 小目標數據增強

小目標檢測一直是目標檢測領域中具有挑戰性的問題,特別是在缺陷檢測方面,小缺陷往往容易被忽略,這主要是因為小缺陷占比像素較少且標註面積占比較小,直接導致神經網絡在訓練的過程中會更加偏向於較大的物體。 該文參照文獻[13] 的思想,采用oversampling(過采樣)的方法改進離線數據增強方式。對於含有小缺陷的樣本進行 2 次復制並且修改名字,

相當於對小缺陷樣本進行三倍的過采樣,從而引起神經網絡的「註意」,提升小缺陷檢測的準確率。 該文使用的數據集中原始數據共 1 882 張圖片,采用過采樣離線數據增強方式進行小缺陷數據增強後共 3 482 張圖片,按照 8:2 的比例隨機劃分訓練集和驗證集。

2.2、 實驗設定

2.2.1、 實驗環境

實驗環境在 windows10 作業系統下,采用 pytorch的深度學習框架,並使用 NVIDIA GeForce RTX2080S(8G)進行訓練加速。

2.2.2、 實驗細節

網絡采用凍結訓練方式進行訓練,凍結次數設定為 50。 訓練時采用 Adam 最佳化器進行叠代最佳化,未解凍部份訓練輸入批次 batch_size = 8,學習率 learning_rate= 0.000 1,解凍部份訓練 batch_size = 4,學習率learning_rate= 0.000 01。 采用遷移學習訓練方式,匯入 ResNet 網絡預訓練模型,共計訓練 150 個輪次。

2.2.3、 評價指標

為了評估模型檢測的效果,采取 mAP(平均精度)對檢測結果進行評價。

其中,TP 是分類器認為是正樣本且確即時正樣本的例子,FP 是分類器認為是正樣本但實際上不是正樣本的例子,FN 是分類器認為是負樣本但實際上不是負樣本的例子。 AP 是利用不同的 Precision 和 Recall 的組合計算得到的平均精度,mAP 就是所有類的 AP 值求平均。

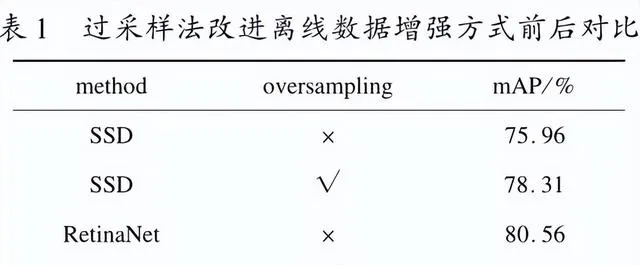

2.3、 過采樣法改進離線數據增強實驗

為了驗證過采樣法改進離線數據增強的有效性,分別在 SSD 模型上和 RetinaNet 模型上進行了實驗對比,實驗結果如表 1 所示。

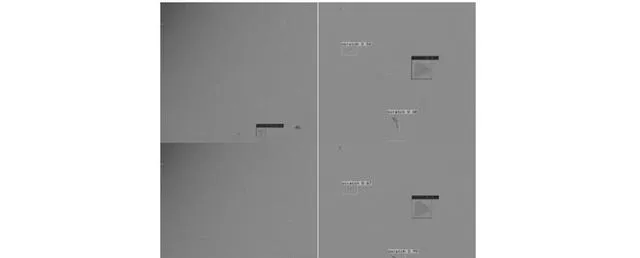

從實驗對比結果可以看到,采用 oversampling 後的模型在三個種類的檢測精度上均有所提高,不僅如此,采用 oversampling 後的模型在檢測結果的標註上也更加的準確。 以 RetinaNet 的檢測結果為例,使用oversampling 方法的 RetinaNet 模型能夠檢測出影像中更多的目標且置信度更高。 根據圖 4 中第一列檢測結果對比圖 可 以 看 到, 沒 有 使 用 oversampling 方 法 的RetinaNet 模 型 只 檢 測 出 來 1 個 目 標, 而 使 用oversampling 方法的 RetinaNet 模型可以檢測出來 2 個目標;根據圖 4 中第二列檢測結果對比可以看到,經過oversampling 方法後檢測的置信度分別為( scratcp:0. 67, defect: 0.99, scratcp: 0.90 ), 而 沒 有 經 過oversampling 方 法 檢 測 的 置 信 度 分 別 為 ( scratcp: 0. 56, defect: 0.99, scratcp: 0.68 ), 很 明 顯 經 過oversampling 方法後的模型檢測目標的置信度要更高一些。

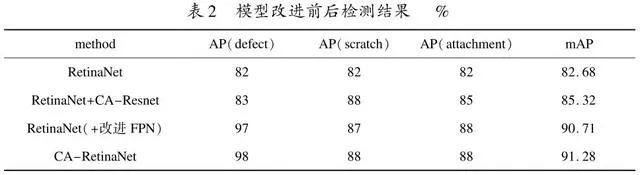

2.4、 模型改進前後實驗對比

為了驗證改進的模型對於 Gp169 合金組織缺陷檢測的有效性,分別在 RetinaNet 模型,RetinaNet 加CA-Resnet,RetinaNet 加改進 FPN 以及 CA-RetinaNet上進行實驗。 結果如表 2 所示。 由表 2 可以看出,針對 RetinaNet 做出的改進是非常有效的,CA-RetinaNet相比較 RetinaNet 的 mAP 提升大約 8.6% ;在加入 CA-Resnet 後模型 mAP 提升大約 2.64% ;對比改進前後特征金字塔網絡的檢測精度,可以看出 CA-RetinaNet 中的特征金字塔網絡有更好的特征提取能力,對比改進前後的特征金字塔 網絡的檢測結果,可以看到重構後的特征金字塔網絡擁有更好的特征提取能力,缺陷類AP 值大振幅提高。

在 Gp169 合金組織表面缺陷數據集的測試集中選取 200 張圖片進行檢測實驗,部份檢測結果如圖 5所示。 從圖中可以看出,原始 RetinaNet 模型僅僅可以檢測圖中少部份目標,而 CA-RetinaNet 幾乎可以檢測出圖中所有目標。

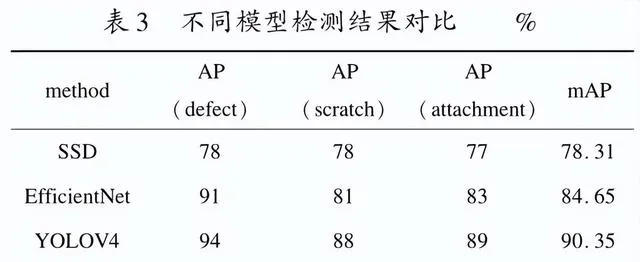

2.5、 不同目標檢測模型對比

為了進一步驗證所提方法的有效性,在過采樣後的 Gp169 合 金 組 織 表 面 缺 陷 數 據 集 上, 將 CA -RetinaNet 算 法 與 當 前 主 流 目 標 檢 測 算 法 SSD[14]、YOLO V4[15]及 EfficienNet[16]等演算法進行了對比,結果如表 3 所示。 由表 3 可知,CA-RetinaNet 檢測精度明顯高於當前主流檢測方法 SSD 以及 EfficientNet;和YOLO V4 相比,檢測精度較高一些。

3、 結束語

針對 Gp69 合金組織表面缺陷較小,形貌不易區分造成傳統原始 RetinaNet 檢測演算法錯檢漏檢等問題,提出以下改進方法:

(1)過采樣法改進離線數據增強方式,對小缺陷樣本進行 3 倍過采樣,不僅增加了目標的檢測成功率,而且檢測出來的目標置信度更高。

(2)提出一種 CA-RetinaNet 檢測演算法,一方面將CA-Resnet 結構引入到 RetinaNet 模型中,增強了網絡提取特征的能力,另一方面重新構建了特征金字塔網絡的結構。 透過在 Gp169 合金組織表面缺陷數據集上進行測試,CA-RetinaNet 演算法相較於原始 RetinaNet檢測演算法 mAP 提高了 8.6% ,與其他目標檢測演算法相比也有較大的優勢。

參考文獻:

[1]杜金輝,鄧群,曲敬龍,等.中國航空發動機用 Gp169合金現狀與發展[C] //第八屆(2011) 中國鋼鐵年會論文集.北京:中國金屬學會,2011:5.

[2] CANNY J.A computational approach to edge detection[J].IEEE Transactions on Pattern Analysis and Machine Intelli-gence,1986,PAMI-8(6):679-698.

[3]PREWITT J.Object enhancement and extraction[C] //Ob-ject enhancement and extraction picture processing and psy-chopictorics.New York:Academic,1970:15-19.

[4]FARGE M.Wavelet transform and their application to turbu-lence[J].Annu.Rev.Fluid Mech.,1992,24:395-457.

[5] 周曉彥,王 珂,李淩燕.基於深度學習的目標檢測演算法綜述[J].電子測量技術,2017,40(11):89-93.

[6]LIN T Y, GOYAL P, GIRSHICK R, et al.Focal loss fordense object detection[J].IEEE Transactions on Pattern A-nalysis & Machine Intelligence,2020,42(2):318-327.

[7] HE K,ZHANG X,REN S,et al.Deep residual learning forimage recognition[ C] //Proceedings of 2016 IEEE confer-ence on computer vision pattern recognition ( CVPR).LasVegas:IEEE,2016:770-778.

[8]LIN T Y,DOLLAR P,GIRSHICK R,et al.Feature pyramidnetworks for object detection[C] //2017 IEEE conference oncomputer vision and pattern recognition (CVPR).Honolulu:IEEE,2017:936-944.

[9] HOU Q,ZHOU D,FENG J.Coordinate attention for efficientmobile network design[C] //2021 IEEE conference on com-puter vision and pattern recognition (CVPR).[s.l.]:IEEE,2021.

[10] JIE H,LI S,GANG S.Squeeze - and - excitation networks[C] //2018 IEEE/ CVF conference on computer vision andpattern recognition (CVPR).Salt Lake City:IEEE,2018.

[11] 邱呂,任德均,郜明,等.基於改進 RetinaNet 的醫用塑瓶裝箱計數演算法[ J].電腦與現代化,2020 (12):99 -103.

[12] 蔣世川.Gp169 高溫合金熱變形行為及組織演變[J].鋼鐵釩鈦,2018,39(2):146-152.

[13] KISANTAL M,WOJNA Z,MURAWSKI J,et al.Augmenta-tion for small object detection[C] //9th international confer-ence on advances in computing and information technology.Rome:Institute of Research Engineers and Doctors,2019.

[14] LIU W,ANGUELOV D,ERHAN D,et al.SSD:single shotmultibox detector [ C] //European conference on computervision.[s.l.]:Springer,2016:21-37.

[15] BOCHKOVSKIY A,WANG C Y,LIAO H Y M.Yolov4:optimal speed and accuracy of object detection[ J].arXiv:2004.10934,2020.

[16] TAN M, LE Q.EfficientNet: rethinking model scaling forconvolutional neural networks[C] //Proceedings of the 2019international conference on machine learning.Long Beach:PMLR,2019:6105-6114.