一、

生成式

AI

推理

需求旺盛

,量化技术升级降低推理门槛

1.1 生成式 AI 模型 持续迭代 , 推理需求旺盛

生成式 AI 模型性能不断提升, 或处于 更 大规模 放量 前夕, 推理需求 有望高速增长 。 OpenAI 于 2022 年 11 月推出生成式 AI 应用 ChatGPT ,在不到两个月的时间内,月活跃 用户数突破 1 亿人。以 ChatGPT 为代表的生成式 AI 应用快速迭代、落地,模型推理的 算力需求逐渐显现。随着生成式 AI 模型参数和 Token 数量不断增加,模型 单次 推理 所需 的算力持续攀升。同时, ChatGPT 、 Gemini 、 Kimi 等聊天机器人的用户数逐步上升, Microsoft Copilot 、 Adobe Firefly 、 WPS AI 等办公助手持续落地, 用户侧的流量不断 上 升 , 推理算力需求有望高速增长。

推理算力 未来 有望 超过训练算力 , 最终 训练 芯片 与 推理芯片 数量 之比或达到 2 : 8 。 目前 生成式 AI 模型仍处于快速迭代 ,各厂商 相互追赶的阶段 ,随着模型性能的逐步稳定和应 用的陆续落地 , 算力的 推理需求 有望超过训练 需求。 而 推理需求与训练需求 在 计算量、 精度要求 以及 部署位置 上存在差异 。 一方面, 训练需求的 精度要求较推理需求更高, 因 此 训练芯片 也就要求有更高的精度范围,在高精度场景下同样需要具备较强的性能 。 另 一方面 , 训练芯片主要部署 在 数据中心(云侧),推理芯片则会兼顾云侧与边缘侧的算力 需求 。 根据施耐德电气的 测算 , 到 2028 年 人工智能 的 推理负载有望 占比 达到 85% 。 我 们认为: 考虑到云侧和边缘侧巨大的推理需求, 训练芯片与推理芯片数量之比或 将 达到 2 : 8 。

1.2 量化技术 有助于降低 推理的 算力 门槛

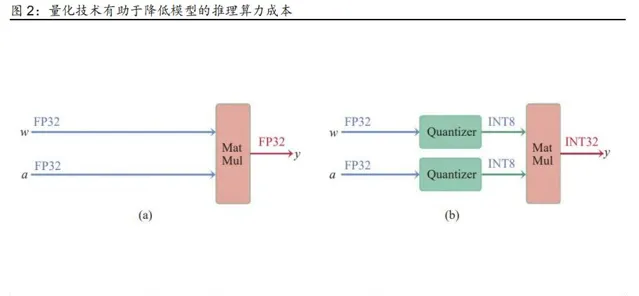

量化技术 ( Quantization ) 是决定 生成式 AI 推理成本的关键因素 , 量化技术的迭代升级 有望 降低 推理门槛 。 深度神经网络模型存在参数冗余 的 问题,所有参数 均 使用 32 位浮点 型数值 ( FP32 ) , 但 神经网络模型 实际 使用 的精度远不 到 FP32 所表示的范围 。 如果 针对 低位宽的数值计算进行优化,使用低数值进行大规模矩阵运算, 模型推理过程 会 有 明显 的 加速效果 。

模型量化 指的是 通过降低网络模型参数数值表示所需的位宽,在不影响模型任务性能情 况下达到降低 精度 和 内存容量的效果 。 假设 将一个参数全部是 FP32 的神经网络的权值 和激活值全部量化到 16 位整型数值 ( INT16 ) 或 8 位整型数值 ( INT8 ) ,其内存占用和 精度理论上均可减少至原 先 的四分之一 , 如果 部署的 处理器 低精度运算较快 ,则能够 有 效 加速 推理 过程 。 目前 INT8 量化 技术 已 比较 成熟, Google 的 TensorFlow 、 英伟达 的 TensorRT 、 Meta 的 PyTorch 等模型部署框架均已支持 INT 8 量化技术 。

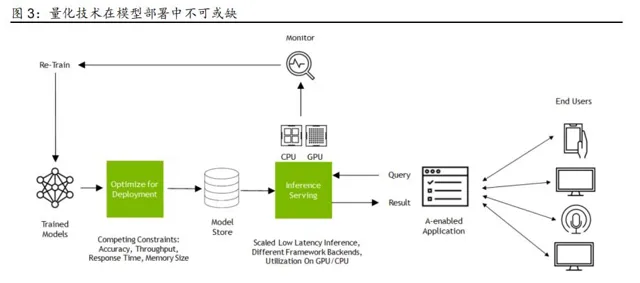

量化技术快速发展 ,为 CPU+ASIC 、 CPU+FPGA 等技术路线 的发展 ,以及国产算力 的 放量 提供了技术基础 。 人工智能模型 的量化技术 从最初的 FP16 量化 快速发展到 目前应 用最成熟的 INT8 量化 ,再到 正在进一步研究中的 INT4 量化 ,呈现出数据精度逐步降低, 内存或显存占用不断减少的趋势 。 这一趋势有助于 CPU+ASIC 、 CPU+FPGA 等技术路 线通过 软硬件 的优化提高推理能力 , 也有助于 国产算力 通过增加 低精度 计算单元等方式 , 以 较 成熟的制程 工艺实现 可用的推理算力。

二、 推理芯片 多种 技术路线齐头并进, 推动生成式 AI 落地

2.1 英伟达 、 AMD 长期 关注 GPU 的推理算力

英伟达和 AMD 的数据中心 GPU 产品 , 在关注训练场景的同时,也始终关注推理场景的 技术革新 。 2022 年以来, 英伟达 先后推出了 Hopper 、 Blackwell 两代 GPU 架构,较此 前的 Ampere 架构增强了 FP8 甚至是 FP4 精度下的 吞吐量 ,能够更高效地完成生成式 AI 模型的推理任务。 AMD 新 推出的 MI300X 也较 p00 提升了 FP 8 精度下的 计算能力 。 以 英伟达和 AMD 为代表的 数据中心 GPU 厂商 的 技术发展趋势,进一步表明 量化技术的迭 代 发展对 模型推理算力需求 有重要的 影响 。

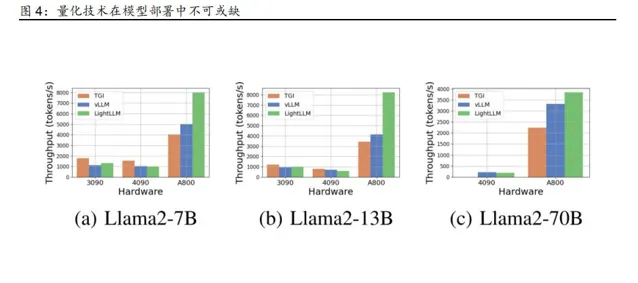

另一方面, 英伟达和 AMD 的消费级 GPU 产品,同样具备 接近 千亿参数量级的 生成式 AI 模型的推理能力 ,从侧面说明 推理芯片的 门槛相对较低 。 根据 公开资料, Llama - 2 7B 和 13B 模型能够成功 部署在 8 卡 英伟达 RTX 3090 服务器上, Llama - 2 70B 则能够在 8 卡英伟达 RTX 4 090 服务器 上 进行部署 。 尽管在推理性能上有一定的损失 ,但消费级 GPU 仍有完成 接近 千亿参数量级的生成式 AI 模型 的能力

2.2 海外 CSP 自研 芯片 ,或 将 另辟蹊径

谷歌、微软、亚马逊 、 Meta 等海外 CSP 企业 在 大规模采购 英伟达数据中心 GPU 的同 时, 也在积极自研用于 模型训练和推理 的 芯片 , 有望成为满足推理算力需求的另一种途 径 。 与英伟达和 AMD 的数据中心 GPU 类似 , 海外 CSP 自研芯片同样 关注 算力集群的 规模化和扩展性。 同时, 由于 面向 AI 场景的 算力 芯片与算法间 存在 紧密 联系 , 海外 CSP 重视 算法 与算力 芯片 间的 协同设计 , 通过 支持新一代量化技术的数据 精度、 部署 模型关 键算法的直接专用加速器 等方法,进一步 提高 推理 性能 。

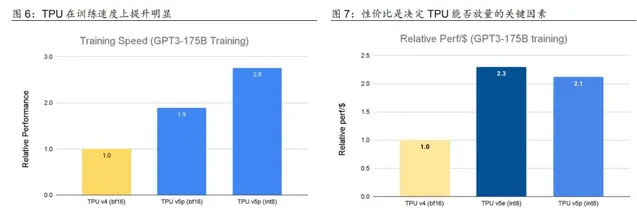

谷歌于 2023 年先后发布了 TPU ( Tensor Processing Unit ) v5e 和 TPU v5p 两款 ASIC 芯片,重点提升了训练 速度 和推理的性价比 , 并 对 PyTorch 、 TensorFlow 等先进 框架 进行了 集成 。 TPU v5e 和 TPU v5p 相较于 TPU v4 , 在 训练 速度上都有接近 2 倍左 右的 提升, 单位美元的 推理性能 也都 提升 2 倍 以上 。 以 TPU v5p 为例, 每个 Pod 由 8960 块 芯片组成, 芯片间 以 4800 Gbps 的 传输 速率 进行互连。 Gemini 1.0 在训练时 即 使用 TPU v4 和 TPU v5e 。 我们认为: 随着 TPU 性价比的进一步提升, 有望在推理芯片 市场扩大份额 ,加速生成式 AI 模型的落地进程 。

微软、亚马逊 、 Meta 同样 发力 自研芯片, 为 生成式 AI 的 训练和推理提供更多的算力选 择 。 微软于 2023 年 11 月推出 Azure Maia 100 , 目前正在 通过 搜索引擎 Bing 和 Office A I 系列 产品 进行测试 。 Azure Maia 100 采用台积电 5nm 工艺,拥有 1050 亿颗晶体管, 能够支持 低于 8 位数据类型。 亚马逊于 2023 年 12 月推出了 Amazon Graviton4 和 Amazon Trainium2 两款自研芯片 , 根据亚马逊云科技的测算, Graviton4 与 目前正在使 用的 Graviton3 处理器相比,性能提升 30% ,独立核心增加 50% 以上,内存带宽提升 75% 以上 。 Meta 也有望 推新款自研推理芯片 Artemis , 或 于 2024 年内完成 Artemis 在 Meta 自有数据中心的部署。 我们认为: 海外 CSP 企业 自研 ASIC 芯片的尝试 ,也从侧面 说明 面对生成式 AI 巨大的训练和推理需求,海外 CSP 企业 也期望 另辟蹊径, 探索 更具有性 价比 和计算效率的 算力解决方案 ,从而为多种技术路线的发展创造了可能性 。

2.3 国产推理芯片 市场潜力大 , 有望迎来重大机遇

国产 推理芯片快速发展, 已在推理 和部分训练 场景 下 落地 ,未来 有望 迎来重大发展机遇 。 以 Kimi 和 WPS AI 为代表的 C 端和 B 端应用 陆续落地 , 国内 的 推理 算力 需求 正在快速 上 升 。 衡量 算力 大小 的维度不仅包括 集群峰值 算力 的 大小, 也 要考虑 到 算力 在 实际 部署中 的使用效率 和优化 程度。 实际可使用的 算力 是 工程化 的 结果, 涉及 从芯片 到开发工具包 的多 个 层次, 对 算力 提供者的 工程 能力及案例 经验都有要求 。 国产推理芯片在多个场景 下的部署, 有助于 国产算力厂商 迭代优化自身产品, 根据实际需求优化 芯片设计及 对应 的 开发工具包 ,加速形成软硬件一体的 开发生态 。

以 运营商 和 国内互联网厂商为 代表 的 需求端正在加速建设 AI 算力, 有望推动 国内推理芯 片市场快速 放量 。 2023 年以来 ,通信运营商 已集中采购超 1.5 万台 AI 服务器, 采购项目 体现了 运营商对智算中心 建设 的重视,同时也反映了国内 推理 和训练 算力 已加速 部署。 在新建成的 AI 算力基础设施 中, 国产 AI 芯片的使用率较高 , 中国移动智算中心(呼和 浩特)部署的 AI 加速卡国产化率超 85% , 中国联通 则基于 华为昇腾 AI 基础软硬件 在北 京建立了 的 全国产化的智算中心 。 2023 年 , 百度订购了 200 台 8 卡 服务器 , 搭配 1600 块 昇腾 910B 。

运营商和国内互联网厂商的 持续部署,有助于 支撑 生成式 AI 应用在国内 落地, 从而在实际运用中 不断对推理芯片的性能迭代升级 。 寒武纪 面向模型训练和推理场景推出了 MLU370 , MLU370 采用 7nm 制程工艺 及 芯粒 ( C hiplet )技术, 通过 封装多颗 AI 计算芯粒( MLU - Die ) 增强计算性能 。 同时, 寒武纪 为 MLU 370 配备了 Cambricon Neuware 软件栈 和 推理加速引擎 MagicMind , 助力 开发 者 提升部署效率 。 目前 MLU 370 已 向 阿里云 等 客户 进行了批量交付 。 通过 深耕行业客户, 寒武纪 有望推动 MLU370 等 产品在更多标志性应用场景 实现商业化 落地,进一步拓展业 务覆盖范围和客户覆盖领域。

华为 于 2019 年发布 昇腾 910 芯片, 此后陆续发布了 升级版本 昇腾 910B 、昇腾 910C , 提升了 NPU 之间交换数据的能力, 对网络接口 进行了 升级 。 昇腾 910 在设计上 较为关注 低精度的 场景 , FP16 算力达到 256 T FLOPS , INT8 算力达到 512 TOPS 。 同时,华为 还 发布了 昇腾 Ascend C 编程语言 、 昇思 MindSpore AI 框架 等 配套软件栈 , 提供系列工 具及套件,支撑模型高效原生开发 ,构建较为完整的 软件生态 。

海光信息 研发的深算二号 已实现批量出货, 实现 LLaMa 、 GPT 、 Bloom 、 ChatGLM 等 生 成式 AI 模型的全面应用,与包括文心一言 在内的 大模型全面适配 。 沐曦、壁仞、燧原等 厂商也陆续推出了 满足推理 场景 需求的 计算 芯片 , 部分推理芯片 在 INT 8 精度下的 计算能 力 与 英伟达 对应产品较为接近 。 其中 , 部分厂商的推理芯片实现兼容 CUDA 架构 ,进一 步降低了 模型移植成本

我们认为: 生成式 AI 的发展是一个不断迭代升级的过程, 随着 国内 生成式 AI 模型的质 量持续提升,有望出现 更多 优质应用,从而带动 推理算力需求快速上升 。 在推理 场景下 , 算 力的性价比 显得更为重要 。 在供给端 有所 限制的情况下 , 国产推理芯片 有望受益于 国 内生成式 AI 应用的落地,迎来重大发展机遇。

本文仅供参考,不代表我们的任何投资建议。【 幻影视界】 整理分享的资料仅推荐阅读,如需使用请参阅报告原文。