虽然去年老黄靠着p00带头的AI芯片在企业端赚饱饱,也成为AI芯片首屈一举的龙头企业,不过,对于一般消费者来说,除非你要AI图像运算,否则NVIDIA的AI技术似乎离你还是很远。

不过,现在老黄要让一般消费者也能享受NVIDIA芯片带来的AI便利性了。

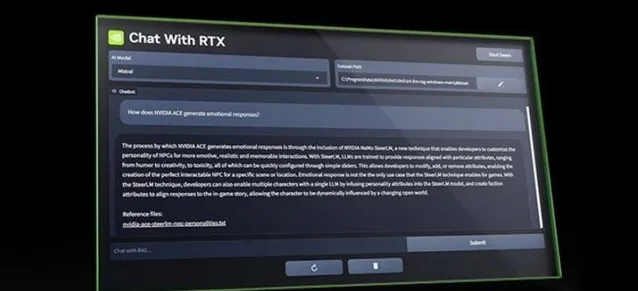

当人工智能聊天机器人的风潮开始兴起时,大多数人使用的是连接到云计算服务器的聊天机器人。不过,让聊天机器人在PC和智能手机上本地运行的趋势越来越明显。NVIDIA推出了一种新方法,让Windows PC用户可以创建自己的大型语言模型AI聊天机器人,并连接到本地端存储的内容。

NVIDIA称其为LLM Chat with RTX,现在该公司网站上提供了展示版。顾名思义,您的计算机必须配备NVIDIA GeForce RXT GPU才能运行这个本地端聊天机器人。以下是具体的硬件要求:

图形处理器 -NVIDIA GeForce RTX 30或40系列图形处理器或NVIDIA RTX Ampere或Ada代图形处理器,至少配备8GB VRAM

内存 - 16GB或更大

操作系统 - Windows 11

Geforce驱动程序 - 535.11或更高版本

下载并安装后,您就可以将"与RTX聊天"应用程序与您本地存储的内容(如文件、PDF文件、视频等)连接起来。然后,您就可以使用本地数据集向聊天机器人提问,这样聊天机器人就能为您提供答案,而无需筛选所有数据。

不过,虽然聊天机器人在本地端执行无需联网,但是如果要找答案的话,他还是可以上网帮你搜索,比方说RTX聊天工具可以在一些YouTube视频中寻找资讯。您只需将视频的URL复制到应用程序中,然后就视频内容提问。Chat with RTX会为您提供答案。

当然,像"与RTX聊天"这样的本地端LLM应用程序的最大特点是,您可以拥有一个人工智能聊天机器人,而不会将数据传输到公司的云计算服务器,以用于培训和其他目的。

不过,这样做的代价是,你需要一台相当强大的计算机来运行它。

NVIDIA将"与RTX聊天"应用程序标注为免费技术展示。这可能表明,该公司计划在未来某个时候将其转变为具有更多功能的付费或订阅型应用程序。