大多数人一想到人工智能,就会想到 ChatGPT 之类的聊天机器人、DALL-E 之类的图像生成器,或者用于预测蛋白质折叠结构的 AlphaFold 之类的科学应用。然而,很少有人认为物理学是人工智能系统的核心。但人工神经网络的概念确实首先是生物物理学、统计物理学和计算物理学这三个学科的物理学研究融合的结果。正是由于这项在 20 世纪 80 年代主要开展的开创性工作,人工智能和机器学习才得以广泛应用,并渗透到我们今天的日常生活中。

2024 年诺贝尔物理学奖授予约翰·霍普菲尔德 (John Hopfield) 和杰弗里·辛顿 (Geoffrey Hinton),以表彰他们在人工神经网络方面的开创性进展,这最终导致了我们今天所熟悉的生成式人工智能应用的爆炸式增长。

「人工智能」竟然与物理学有关,这一想法表面上可能有些牵强。你可能会问自己:「为什么计算机科学的突破会获得诺贝尔物理学奖?」当然,这是一个好问题,因为表面上看两者之间的联系并不明显。但是,让我们来看看物理学的三个不同分支领域:

· 生物物理学,

· 统计物理学,

· 和计算物理学,

最终会给出令人满意的答案。具体来说,机器学习的基础是统计物理学,而导致其诞生的理念——人工神经网络——则直接源于生物物理学。

人类大脑被普遍视为奇迹,成人大脑中估计有 860 亿个神经元,神经元之间的连接数量是成年人的 7000 倍。尽管许多人预测,在不久的将来,人工智能机器将拥有更多的连接和「神经元等价物」,但人类大脑的组成远不止神经元(包括大量神经胶质细胞),其复杂性尚未完全了解。

因此,人们推断,人们可以尝试创建一个「人造」大脑,或者至少是一个能够学习识别模式的东西,方法是构建一个行为类似的网络。出现的想法被称为人工神经网络。实际上,人工神经网络只是一种计算机模拟,但这种模拟具有以下特点:

· 你有可以接受特定值的节点,这些节点代表神经元,

· 节点之间存在连接,这些连接会根据节点是否一起受到刺激而增强或减弱,这代表了突触。

随着时间的推移,如果你一遍又一遍地刺激连接的节点,连接就会加强,而如果你在一个节点不刺激另一个节点时刺激它(反之亦然),连接就会减弱。

现在,试着想象一下回忆很久以前听到、看到或经历过的事情的过程。几个月前,我自己就有过这样的经历,当时我在看电视节目【别忘了歌词】的一集,当时他们播放了 Rick James 的歌曲【Super Freak】。这首歌我听过很多次,我敢发誓我知道所有的歌词,但当他们在以下歌词后停止音乐时:

「那个女孩现在非常狂野,她是一个超级怪胎,

是那种 ___ ___ ___ ___ ___ ___ ___ 「

我被难住了。我知道这首歌的所有歌词:那个女孩很古怪,那个女孩是个超级怪胎;每次我们见面时,我都很喜欢尝尝她的味道,但这并没有让我得到答案。我试着哼唱萨克斯独奏;但没用。然后我试着唱这段歌词,之后,我的大脑意识到,那个女孩现在很狂野,那个女孩是个超级怪胎,就是 你在新浪潮杂志上读到的 那种女孩。然后我惊呼道:「哦,我的天,我是世界上最聪明的人!」

里克·詹姆斯(本名詹姆斯·安布罗斯·约翰逊二世)的墓碑,由本文作者于 2023 年拍摄:几个月后他开始创作【别忘了歌词】。

刚才发生了什么?你有这种感觉吗?作为一个有大脑但记忆力不完美的人,这说明了我们的记忆是如何运作的:通过刺激大脑的相关部分,即在形成记忆时和之前回忆起这些记忆(或信息)时受到刺激的部分,你可以触发大脑中「找到」你正在寻找的模式的部分的刺激。这个重要概念被称为关联记忆:你的大脑不仅存储模式,而且当你「记起」之前发生的事情时,它会试图重新创建这些模式。通过观察你大脑中的单个神经元,这一点是无法明显的发现的;这是一种需要大脑中各个部分协同作用的突发行为。

这个伟大的想法启发了约翰·霍普菲尔德:他是一位物理学家,之前曾研究过分子生物学问题,后来对神经网络产生了兴趣。在思考神经元同时放电的集体行为时,他使用了与其他表现出类似集体行为的物理系统进行类比:流动流体中形成的涡流以及磁化系统中原子和分子的方向。霍普菲尔德推测神经元的集体行为可以产生计算或学习能力,然后试图通过在人工神经网络中展示这一点来证明它。

自然神经元通过各种突触相互连接,随着突触连接的加强,神经元更有可能同时激发:这是大脑学习时发生的现象。人工神经网络将这些神经元建模为编码有特定值的节点,节点的连接性可以增强或减弱,这取决于它们是否采用彼此相同或不同的值。

霍普菲尔德首先创建了一个人工神经网络(同样,这只是一个计算机程序),其中有大量节点,每个节点只能采用两个值之一:0 或 1。(或者,与磁自旋类似,自旋向上或自旋向下。)就像许多磁性材料的情况一样,相邻节点(或原子/分子)的自旋值会影响相关节点(即原子/分子)的值,该神经网络中节点的值部分由连接节点的值决定。就像磁化材料趋向于平衡配置或能量最小化的配置一样,霍普菲尔德对他的人工神经网络进行了编程,以根据一系列预编程模式将所有节点上的能量最小化:您可以将其视为「训练」数据集。

另一种思考方式是想象你有一个网格,比如说,长 14 个元素,高 19 个元素:总共 266 个元素。你一开始有一个「输入模式」,就其本身而言,它可能看起来什么都不像。但是,如果你有一系列参考模式(你可能称之为「已保存」模式),则可以将输入模式与所有可能的参考模式进行匹配,以查看哪一个是最接近的匹配。这可能会迭代进行,一步一步地优化你的输入模式,以更好地匹配接近的参考模式。即使在你的输入模式有噪声、不完美或部分被删除的情况下,你通常也可以恢复与你的输入模式最匹配的最佳、最正确的已保存模式。

Hopfield 模型的理念是,存在一系列可能的输出:对于任何一组输入,都可以得出解决方案。即使在输入有噪声、损坏或其他不完美的情况下,最优选的「谷值」也将对应于保存的模式之一,根据算法和训练数据,该模式与输入模式最匹配。

Hopfield 网络能够执行这种相当原始的模式匹配,这将为寻找不完整或损坏的数据与「真实」参考数据集之间的匹配铺平道路,这种匹配在图像分析领域仍有应用,包括对象识别和计算机视觉。尽管如此,Hopfield 的原始模型从根本上受到被视为可能答案的任何一组单独的「保存模式」的限制;它本质上不是生成性的,而只能进行模式匹配。

这就是今年另一位诺贝尔物理学奖得主杰弗里·辛顿 (Geoffrey Hinton) 的工作意义所在。它不关注特定的个体模式,而是将其概括为包括模式的统计分布:包括实际上不属于任何参考数据集的模式。(例如,如果您的参考集仅包含字母表中的 26 个字母,您可能还会期望统计分布中的字符代表多个字母连在一起,例如 æ。)您可能希望以某种前所未见的方式从数据中平均得出多个可能的解决方案,例如文本中的点「t」或交叉「i」。

辛顿的第一个重大进步是用第一个真正的生成模型——玻尔兹曼机取代了原始的霍普菲尔德模型。

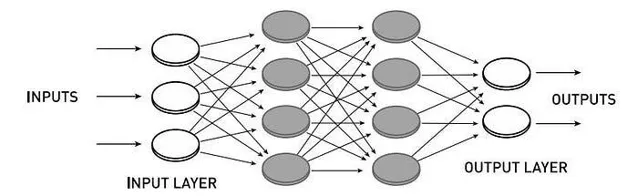

在 Hopfield 网络中,所有节点都相互连接,节点之间的连接具有权重。在玻尔兹曼机中,有可见节点层(输入和输出),它们之间有隐藏节点网络。在受限玻尔兹曼机中,同一层的节点之间没有连接,只有相邻的不同层的节点之间有连接。

在玻尔兹曼机中,你仍然有一个输入或一组输入代表你的初始数据,你仍然会得到一个输出或一组输出代表你的计算机程序最终会读出的内容。然而,在输入层和输出层之间,可能存在各种隐藏层:隐藏节点(这些节点不仅不属于任何参考数据集,而且在任何时候都不是人类(或程序员)输入的节点)将输入与输出分开。这些隐藏层允许将更一般的概率分布纳入分析,这可能导致任何简单的算法都无法发现的意外输出。

虽然这种类型的计算机(玻尔兹曼机)由于计算资源利用效率低下而应用有限,但它促使 Hinton 和其他合作者想到了一种更精简的模型:受限玻尔兹曼机,其:

· 将输入连接到隐藏层,

· 其中隐藏层在连接到输出之前先连接到另一个隐藏层,

· 然后调用反向传播,隐藏层可以相互通信,

· 最终收敛到最佳最终输出。

这一进步极其重要,原因十分深刻:它证明了具有隐藏层的网络可以通过这种方法进行训练,以执行之前被证明在没有这种隐藏层的情况下根本无法解决的任务。

这个前馈网络(无反向传播)的示例是受限玻尔兹曼机的示例:其中输入层和输出层之间至少有一个隐藏层,并且节点仅连接在不同层之间:而不是同一层的节点之间。

通过限制不同类型的节点(输入-隐藏、隐藏-输出)之间的连接,但禁止同一类型的节点(输入-输入、输出-输出或同一层的隐藏-隐藏)之间的连接,计算速度和效率显著提高。隐藏节点的重要性和功能已不容否认。

很快,这项新技术开始得到成功应用。银行现在可以自动将支票上的手写数字(0、1、2、3、4、5、6、7、8、9)分类,无需人工干预。图像、语言甚至临床和医学数据中的模式都可以被识别;早期未曾预料到的进步之一是能够识别图像中的「角落」特征。如今,近乎即时和近乎通用的语言翻译几乎已经成为一种理所当然的技术,但它的根源要归功于霍普菲尔德和辛顿。

后来,其他方法被证明能够取代基于受限玻尔兹曼机的预训练,节省更多的计算时间,同时仍然能够实现深度和密集人工神经网络的相同性能。

这是 iask.ai 针对整数的查询截图,以及其严重错误的响应。正确答案是 -5,这需要输入几个额外的提示才能诱导 AI 做出正确响应。

然而,仍然有大量的应用具有实际的积极价值。人工神经网络擅长于:

· 即使对于最复杂的数学函数来说,它也是极好的函数逼近器,

· 近似多体量子系统,精确模拟需要极高的计算量,

· 非常好地模拟原子间和分子间的作用力,从而能够对某些类别的材料及其应表现出的特性做出新的预测,

· 并可扩展到复杂的物理系统。

物理系统应用非常广泛,包括基于物理的气候模型、寻找可指示加速器对撞机中新粒子(包括希格斯玻色子)的粒子轨迹、从南极的 IceCube 探测器绘制中微子中的银河系、识别人类搜索算法遗漏的凌日系外行星候选者,甚至用于处理用于构建事件视界望远镜的第一张黑洞事件视界图像的数据。

事件视界望远镜 (EHT) 合作项目拍摄的两个黑洞大小对比:位于梅西耶 87 星系中心的 M87* 和位于银河系中心的人马座 A* (Sgr A*)。尽管梅西耶 87 的黑洞由于时间变化缓慢而更容易成像,但从地球上看,银河系中心周围的黑洞是最大的。人工神经网络对于分析和处理用于恢复这些图像的数据至关重要。

或许最深刻的是生物和医学应用——也许具有讽刺意味的是,这又回到了生物物理学,而生物物理学是人类对人工神经网络产生兴趣的科学。AlphaFold 可以仅基于底层氨基酸序列预测性地计算完全折叠的蛋白质结构,包括三级和四级结构。使用人工神经网络的机器学习可以大大提高基于乳房 X 线检查图像的乳腺癌早期检测率(而不会增加假阳性率)。它是我们拥有的用于纠正患者在接受 MRI 扫描时身体任何部位发生的自愿和非自愿运动的最佳工具。

虽然肯定会有一大批把关不放、持反对态度的物理学家大喊「这是计算机科学,甚至不是物理学」,但重要的是要记住,同样的事情也曾被说过:

· 化学物理学,

· 生物物理学(生物物理学),

· 计算物理学,

· 统计物理学,

以及物理学的所有其他分支领域。人们也曾以类似的理由嘲笑诺贝尔奖授予原子钟和计时。对于那些这样想的人,我想说:仅仅因为这个领域是你不感兴趣的物理学的一个方面的结果,并不意味着它不是物理学,当然也不意味着它不值得获得诺贝尔奖。我们是否将人工智能、机器学习和人工神经网络用于社会的利益或弊端并不是重点。重点是,这种强大的新技术正变得越来越普遍,正是物理学的洞察力导致了它的诞生和它能力的许多巨大飞跃。我们接下来要怎么做,完全不在诺贝尔委员会的掌控之中,就像炸药和高爆炸药的发明者诺贝尔本人无法控制他的发明以后会如何使用一样。对于全人类来说,下一步该怎么做,取决于我们自己。