本文由半导体产业纵横(ID:ICVIEWS)综合

随着Blackwell芯片出货量的增加,客户采用液冷的意愿也会提升。

业内人士称,液冷解决方案的通用快速断开装置(UQD)供应已趋于紧张,这可能成为AI服务器液冷增长的主要瓶颈。

服务器ODM厂商指出,Nvidia的Blackwell AI芯片,包括B100和B200,将于今年开始出货,但GB200解决方案要到2024年底或2025年才会开始量产。

B100、B200客户目前大多仍采用风冷散热设计,不过据ODM厂商反映,液冷渗透率持续提升,预估随着Blackwell芯片出货量的增加,客户采用液冷的意愿也会提升。

扩大产能以应对液体冷却需求的增加

相关企业纷纷扩大生产,迎接液冷新时代。散热模块厂商晶晨科技计划将水冷板月产能从3万片提升10倍至30万片。

Auras 在泰国设立新工厂,以响应客户的地缘政治担忧和要求。该工厂预计将于第三季度开始量产。除了扩大冷板的本地产能外,Auras 还计划在本地生产冷却分配单元 (CDU) 和冷却液分配歧管 (CDM),计划月产能约为 2,000-3,000 套。

散热模组厂AVC在近期财报电话会议上指出,其中国及越南工厂的冷板模组月产能约为11.5万台,若以冷板计算,则月产量约42万台,AVC计划年底前将产能扩大50%。

AVC 还计划将 CDU 的月产能扩大至 1,000 台,将 CDM 的月产能扩大至 30,000 套。AVC 强调,这一计划产能可根据客户订单需求灵活调整。

热能技术公司高力热处理因客户对液冷产能需求增加,正扩大台湾中坜厂区产能,预计第三季末CDM月产能将从1,000台增至2,000台,年底将增至4,000台,行内CDU年产能也将在年底达到2,000台。

上述厂商均对液冷需求抱有较高期待,主要原因在于中国与欧盟的运算效率与数据中心PUE规范,但最重要因素还是Nvidia解除了对芯片厂商散热规格自我限制。

液冷快速增长导致UQD短缺

在大家热切期盼液冷时代来临之际,UQD成为成长的最大瓶颈,散热模块厂指出,近期UQD供货吃紧,虽然液冷目前市占率只有个位数,但未来若上升至两位数,UQD恐将一票难求。

UQD供应商多来自欧美,如美国大厂Parker Hannifin与CPC、瑞士Staubli International、丹麦Danfoss、瑞典Cejn等,台湾连接器零组件大厂Lotes也积极入市,并已开始送样。

安博科技董事长梁志坚指出,由于液冷最看重的是避免泄漏,而UQD是最容易发生泄漏的元件,因此UQD的供货是液冷元件中最紧张的。这不仅是技术问题,相关厂商也有专利保护,安博科技正在研究如何突破这些专利壁垒。

业界表示,UQD厂商有专利保护,但同时也需要经过层层验证,包括OCP认证、客户端验证等耗时耗力,加上现有欧美厂商无扩充产能意向,将成为液冷快速发展的主要瓶颈。

Supermicro 是成长最快的液冷厂商之一,创始人兼首席执行官梁见后指出,过去 30 年,液冷仅占服务器市场的 1%,但他预估 2025 年渗透率将跃升至 30%。

液体冷却成为潜在解决方案,人工智能繁荣给电网带来压力

生成式人工智能的快速发展推动了数据中心前所未有的扩张,引发了人们对其对电网影响的担忧。这些耗电设施可能会导致停电并增加能源成本。

据电力研究所估计,到2030年,数据中心可能消耗美国9%的电力,是目前的两倍。一个大型数据中心的用电量相当于数十万户家庭的用电量。

人工智能不断增加的电力需求尤其令人担忧。早期的人工智能模型消耗的电量是谷歌搜索的十倍,而较新的芯片对能源的需求甚至更高。专家警告称,未来人工智能的发展可能会受到我们产生足够电力的能力的限制。

一些国家面临严峻挑战。例如,到 2026 年,爱尔兰可能会有 30% 的电力用于数据中心。在美国,数据中心的用电集中在 15 个州,其中得克萨斯州和弗吉尼亚州最多。加利福尼亚州的情况危急,预计新建的数据中心可能会产生超过核电站发电量的电力需求。

数据中心:巨大的能源消耗和液体冷却的兴起

人工智能的计算需求正在推高服务器温度和碳排放,从而导致冷却系统需求大幅增加。冷却系统占数据中心总电力消耗的 40%,是仅次于服务器本身的第二大电力消耗来源。

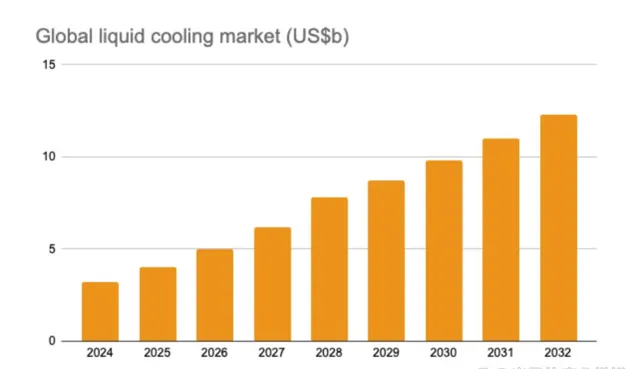

全球服务器冷却市场预计将从 2024 年的 200 亿美元增长到 2027 年的 900 亿美元。数据中心的液体冷却系统预计将从 1% 增加到 22%,市场价值在未来三年内从 3.17 亿美元增长到 78 亿美元。

使用水或冷却剂来冷却服务器的液体冷却解决方案正日益流行。新技术包括浸入式冷却(将整个服务器机架浸入非导电液体中)和直接液体冷却(在服务器周围循环水)。虽然目前比空气冷却系统更昂贵,但液体冷却可以将数据中心的功耗降低 10% 或更多。

研究公司 Global Market Insights 预测,全球数据中心液体冷却市场规模将从 2022 年的 21 亿美元增长到 2032 年的 122 亿美元。Uptime Institute 的一项调查发现,16% 的数据中心经理认为液体冷却将在 1-3 年内成为数据中心的主要冷却方法,而 41% 的人认为这将需要 4-6 年。因此,混合冷却方法在短期内更有可能出现。

数据中心风冷系统管理领域的领导者Upsite Technologies指出,虽然技术在不断进步,但短期内不太可能实现100%液冷数据中心,液冷设备仍然需要风冷来散热。

虽然液体冷却也更高效,但难以大规模实施,而且需要大量的前期投资。空气冷却成本较低,但效率较低。因此,混合冷却设施正变得越来越受欢迎,以最大限度地发挥液体和空气冷却的优势。

数据中心能源危机引发紧急行动呼吁

由于数据中心对环境的影响,它们受到越来越多地关注。世界各国政府都在实施法规,以控制其能源消耗和碳足迹。中国的「绿色数据中心」指南以及德国、新加坡和日本的类似举措就是这一趋势的例子。

施耐德电气等行业专家强调,需要采用全面的环境指标来评估数据中心的可持续性。这包括能源使用以外的因素,例如水资源和废物产生。

美国政府正在向大型科技公司施压,要求他们投资清洁能源,并认识到生成人工智能不断增长的电力需求对环境产生的重大影响。

寻找合适的电源:数据中心和能源挑战

数据中心需要多样化的能源组合,以平衡可靠性和可持续性,满足不断增长的需求。

太阳能和风能等可再生能源因其低碳足迹而颇具吸引力。然而,它们对天气条件的依赖可能导致输出不稳定,因此不适合作为数据中心的唯一电源。建造冗余设施来弥补这种不一致性可能是必要的,但成本很高。

核电成为一种潜在的解决方案。传统核电站提供可靠的基载电力,产生对数据中心运营至关重要的稳定电力。此外,全球核电市场预计将在未来十年实现稳步增长。

核能领域的创新提供了更多有希望的可能性。小型模块化反应堆 (SMR) 正在开发中,作为传统核电站的更小、更安全、更具可扩展性的替代品。虽然仍处于研发阶段,但 SMR 有可能直接部署在数据中心,提供专用的清洁能源。

然而,SMR 的广泛应用面临重大障碍。监管和制造方面的挑战可能会使其商业部署推迟数年。美国政府正在积极探索解决方案,包括与科技巨头合作以降低成本并简化流程。

减少数据中心能源需求的另一种方法是优化人工智能工作负载。通过将一些人工智能任务从云端转移到具有较小、资源密集度较低的人工智能模型的本地设备,可以降低总体能耗。

数据中心的未来发展需要多管齐下。采用多元化的能源组合,包括核能等可靠能源,同时积极寻求 SMR 等可再生和创新解决方案至关重要。此外,优化本地设备上的 AI 工作负载可以进一步促进数据中心的可持续发展。

*声明:本文系原作者创作。文章内容系其个人观点,我方转载仅为分享与讨论,不代表我方赞成或认同,如有异议,请联系后台。