好多时候,之所以用人工神经网络去模拟热物理性质,是因为缺少对应类别物质的恰当物理模型。这人工神经网络是由多层通常高度相互连接的神经元构成的。

这些神经元层会把输入(不管是来自其他神经元还是训练数据)收集起来,放进激活函数里,然后把转换完的信息传给其他神经元(或者是网络的输出层)。

要是增加神经元还有互连,或者选更复杂的激活函数,那人工神经网络的灵活性差不多能无限提升。多层的人工神经网络叫做深度神经网络。人工神经网络能搞定复杂的组件描述符。

比如说,分子图能当成所谓的图形神经网络(GNNs)的输入。GNNs 还被拿来模拟混合物的热物理性质。在这个领域使用人工神经网络的情况,像预测气体溶解度以及混合物的体积特性。

好多来自监督学习的其他办法,都已经成功地用在模拟热物理性质上了。

像支持向量机和随机森林这些,为了简单点,咱在这就不再更详细地说这些方法了。

选择包含相关信息的合适组分描述符这事儿,在热物理性质的监督学习里挺明显的。不同复杂程度和类型的组件描述符都用在这上面了,大概能分下面这些类:

监督学习和无监督学习最根本的不同就在于,无监督学习不需要那种有标签的训练数据。

要是图里展示的这个方案没人监督,ML 算法不会晓得映射预先指定的描述符 d ,而是会自己去发现一组给定数据里的结构 y 数据,之后能拿来做预测。

所以啊,无监督学习能让人开发出混合物的模型,而且不用依靠任何有关纯组分的明确信息。

在所示的这个情境里,无监督学习的运用能算作特征学习的一种,就像推荐系统里那样(比如视频流供应商和在线零售商使用的这类系统)。

无监督的 ML 算法能从用户的行为里把用户特征(还有电影或者商品的特征)给提取出来,而且不需要任何有关用户(或者电影、商品)的额外信息。

在混合建模里,学到的特征属于纯组分的特征。不过呢,和监督学习一对比,无监督的 ML 算法并不需要相关特征事先就知道,也不需要是在物理上能看得见摸得着的。

反过来讲,要是相关特征是潜在的,藏在混合数据里头,能从这里把它们找出来。

无监督的特征学习不是要先选成分描述符,而是能产生一种新的这类描述符,直接从混合数据里学。

矩阵完成方法(MCMs)构成了一种特别有意思的混合物热物理性质的特征学习手段。

这些模型挺有意思的,原因在于二元混合物(给定状态点那种)的性质数据能轻松地按矩阵形式去排列,一行代表一种成分,一列代表另一种成分。

因为实验混合物的数据不多,矩阵老是被稀疏地占着;所以,对缺失条目的预测属于矩阵补全的问题。

到现在为止,MCMs 已经能成功用来预测二元混合物的一些不同热物理性质了,像活度系数、亨利定律常数、自扩散系数这些。

还有吸附这一块,虽说实验数据库范围太小,占用率常常都不到 10%,可它们还是获得了很出色的预测性能,而且比物理基准方法还好。

这些 MCM 学习的潜在特征能当成一种新的纯组分描述符(单纯由混合物数据来确定)。

它们能跟物理纯组分描述符产生关联,还能让人明白在分子层面描述混合物里组分行为的关键要素

注意哈,就像上面说的那样,把无监督学习用到模型的输出上可不是常见的情况,而是个例外。它用在模型的输入上的时候更多。

在模拟热物理性质的时候,这就相当于基于 ML 的组分描述符分析,比如说,用它来识别并减少冗余,或者降低输入参数空间的维数,这种办法还能用来分析现有的数据集。

这种分析能够把系统的依赖性给揭示出来,进而产生认知方面的后果。

讨论中提到把 ML 用到热物理性质建模的诸多具体难题,天然就制约了纯数据驱动的 ML 在这个领域取得成功。

不过呢,往好的方面想,咱们这个领域在领域知识这块特别充足,像高度发展的物理模型都包含在里面。

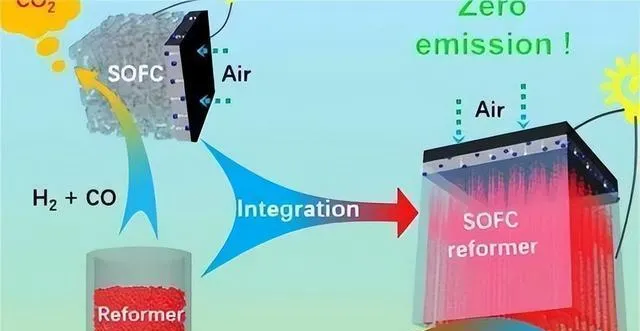

所以,特别重要的事儿就是把这些知识跟 ML 弄一块儿,创建出混合模型。

混合模型或许能把两个方面的好处结合起来:在 ML 方面,算法以及复杂训练策略有着很高的灵活性;在物理学方面,遵循物理定律,还有相关的预测能力。

接下来的小节里,咱们讲了四种把 ML 和物理建模结合起来的通用办法,还有最近研究里的例子。

应对实验数据稀疏性难题的直接手段,就是在 ML 模型的开发以及训练里纳入物理模型生成的数据。

这种方法示意性地呈现出来。

一个重要的问题存在于这种混合当中,那就是不同类型数据的加权情况。

要是给物理模型的结果加了太多的权重,弄出来的混合模型就会重现物理模型,而不是实验数据。

这种方法有时会拿来预测混合物的热物理性质。另外,用最大似然预测去拟合物理模型,并且只拿物理模型的结果去训练 ML 模型,这事儿已经被举报了。

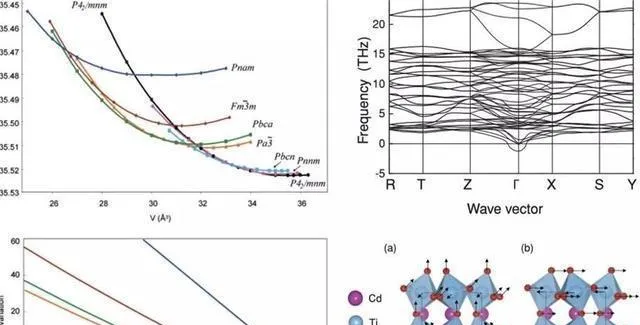

表明了这种混合手段对亨利定律常数的预估,针对溶质 i 在溶剂 j 中的情况,在 298 K 这个条件下,物理模型是 PSRK EOS ,而 ML 模型是一个 MCM 。

PSRK 模型的合成数据并非像实验数据那样被使用,而是先用来生成 MCM 参数的信息。

然后在贝叶斯框架里把它跟实验数据拟合,跟物理基准测试一比,这种混合办法有了很明显的改进。

另外一种开发混合模型的策略是运用所谓的集成办法,它的想法是把多个弱学习器组合起来,从而得到一个强学习器。

讲了一个模型并行互连的办法。

这种方案在 ML 文献里叫装袋,其结果能够通过不一样的方式进行组合。

一个挺简单的办法是加权平均,不过呢,也能像这样,比如说,查看两个模型是不是在特定范围内一致,只有在这种情形下,才接受预测。

这种增强的办法已经顺利地用在预测活度系数和自扩散系数上,其方法的变种,像是多个 ML 模型依次相互连接来预测气体溶解度或者传输属性的情况,也有被报道过。

展现出了这种推进方式的成果。

任务在于预测自扩散的系数

溶质 i 在溶剂中无限稀释 j ,所以要在 SEGWE 模型的残差上训练 MCM ,让它学会怎么纠正这些预测。

然后把学到的校正用到 SEGWE 结果上,再把这个结果跟单独的 SEGWE 结果作比较,就表明跟物理基准模型相比,这样的混合有了很明显的改进。

boosting 方法实质上是有帮着改进物理模型的可能的,原因在于它能给出有关物理模型系统性弱点的全面又有条理的信息。

另外一种杂交的办法是把 ML 方法嵌入到物理模型里头(好比说,通过 ML 算法去学习,然后预测物理模型的参数)。维持物理框架能够留住物理建模的长处。

要是符合一致性的标准,还有预测的能力;另外,人们能够运用 ML 方法的灵活性。

用 ML 方法来开发分子模拟的力场,这是把 ML 嵌入到物理模型中的一个情况。

基本的想法就是开展量子化学计算,ML 算法能从这些计算里学到力场,接着就能拿来对材料的属性进行模拟。

好多近期的出版物都采用了这种办法。另外,还有一些讲用人工神经网络去预测状态方程参数的报告。

另外一个重要的嵌入例子是借助 MCMs 去预测相互作用。

因为好多物理模型都依照这个概念,所以它的适用范围挺广的。

展示了基于这种思想的混合模型的典型结果,此模型是把 MCM 嵌入到 UNIQUAC 模型里,用来研究二元混合物的组分之间的对相互作用参数的结构。

接着就用推断出的结构去预测那些新的、以前没研究过的组分组合的相关参数。

这种办法让 UNIQUAC 能用到没有数据的混合物里,这一般是做不到的,原因在于相互作用参数得跟感兴趣组分的每个二元组合的数据相匹配才行。

把这种混合方法得出的结果跟系统推广的物理金标准做个比较,基团贡献法对 UNIFAC (Dortmund)做了修正,同样,混合模型的表现要比物理基准模型好。

MCM 成功地被用来预测 UNIFAC 相互作用矩阵里缺失的参数。

这种办法的好处是,把 MCM 嵌入到 UNIQUAC 模型里,物理模型就能一直具备对状态点(像温度和组成)还有性质进行统一归纳的本事,也能拥有从二元混合物向外推算到多组分混合物的能力。

同时,MCM 能让模型对没研究过的二元混合物做出预测。

在这种混合模型里,MCM 能通过不同的办法建立,特别有意思的是,在混合模型中恢复相互作用能量的对称性是有可能的。

这在 UNIQUAC 方程的原始公式里没被考虑到,只引入了两个(不对称的)可调参数,而非一个,这是 ML 和建模里认知问题密切相关的又一个例子。

最后要说的一点也挺重要,能照着跟中所示策略互补的那个策略来,把物理知识放到 ML 算法里面。

这种方法被示意性地进行了描述。

一个关键问题在于保证结果能符合物理定律;还有个问题是想办法增强预测的能力。

在 PINNs 里,模型的损失函数(纯数据驱动的 ann 中,就只看模型结果跟训练数据的偏差)还加上了一个用来惩罚跟显式物理知识有偏差的项。

当下,PINNs 主要是把(已知的)微分方程直接放到损失函数里,再借助自动微分算法。所以,在 PINN 训练的时候,这个模型得重现训练数据;同时,还得给出符合给定微分方程的结果。

虽说用 PINNs 去模拟热物理性质好像挺有盼头,可它们很少被这么用。

PINNs 有个天生的毛病,就是属于软约束的办法。这意思是,它只能大概满足约束条件,而不是精确满足。在表示数据和遵循约束这两方面,始终存在一个权衡。

所以啊,弄出来的模型在一定程度上偏离了约束(这里说的是物理理论),每回都得搞清楚这种差别能不能行。

就算从实际操作的层面来说,这些差异没啥坏处,可它们或许会让模型不那么容易被接受。

所以啊,严格落实物理边条件那种硬约束的办法(得直接改动算法架构)挺有意思的,可在这方面的研究还特别少。

在科学与工程的实际操作里,把 ML 算法中的领域知识严格落实是构建 ML 模型的一个大难题。

这些限制的引入会对结果产生怎样的影响,这还是个没答案的问题。

丧失灵活性到底是有害处呢,还是对预测有好处?另外,从实践以及认识论的层面来讲,选择去执行啥样的规则,这是个挺有意思的问题。