还在犹豫什么?好运的机会稍纵即逝!赶紧关注我,一起开启幸运之旅吧!祝您财运亨通,心想事成!

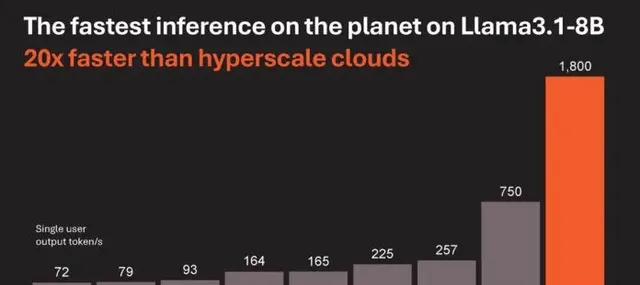

晶圆级AI芯片WSE-3性能公布:80亿参数模型上每秒生成1800个Token

Cerebras与Nvidia:一场关乎AI未来速度的「 SRAM 对 HBM 」之战

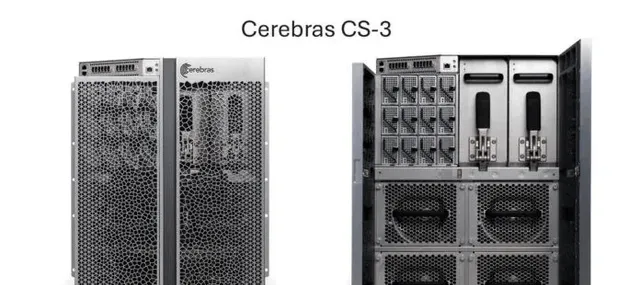

**一场芯片界的「速度与激情」正在上演。**主角是新晋实力选手Cerebras Systems和老牌巨头Nvidia。这两家公司,一个手握着晶圆级AI芯片WSE-3,另一个则拥有GPU王者p00,正围绕着AI推理速度展开着激烈的角逐。这场比赛,不仅仅是技术之争,更是关乎AI未来发展方向的路线之争。

一、 80亿参数模型,每秒生成1800个Token:Cerebras向Nvidia发起挑战

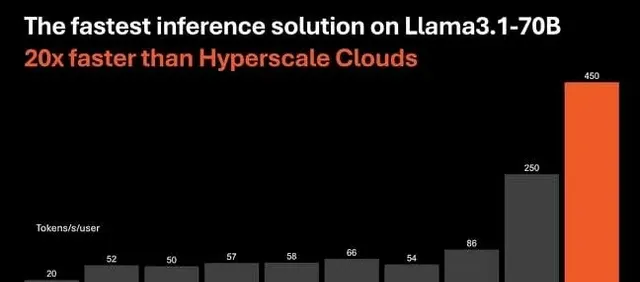

故事要从今年3月说起,Cerebras Systems发布了第三代晶圆级AI芯片WSE-3,其性能较上一代WSE-2翻了一番。最近,在Hot Chips 2024大会上,Cerebras Systems公布了WSE-3在AI推理方面的惊人表现:在Llama3.1-8B模型上,WSE-3的推理速度比使用NVIDIA p00的微软Azure等公司快了20倍!

这怎么可能?

秘密就在于WSE-3采用了44GB的片上SRAM,而p00使用的是HBM3e内存。虽然HBM3e拥有更大的容量,但SRAM的速度优势在AI推理中体现得淋漓尽致。Cerebras Systems首席执行官Andrew Feldman自豪地宣布,WSE-3在运行Llama 3.1 8B模型时,每秒能够生成超过1800个Token,而性能最好的基于英伟达p00的实例每秒只能生成超过242个Token。

这就好比两辆赛车,Cerebras的赛车虽然油箱小,但发动机强劲,加速迅猛;而Nvidia的赛车虽然油箱大,但发动机动力不足,只能望「 SRAM 」兴叹。

二、SRAM与HBM:谁才是AI推理的未来?

Cerebras Systems的成功,也引发了业界对于AI芯片内存选择的思考:SRAM和HBM,究竟谁才是AI推理的未来?

**支持SRAM的一方认为,**AI推理更依赖内存带宽,而非单纯的计算能力。SRAM凭借其速度优势,能够大幅提升AI推理的速度,尤其是在处理大型语言模型(LLM)时,SRAM的优势更加明显。

**而支持HBM的一方则认为,**SRAM虽然速度快,但容量有限,难以满足日益增长的LLM对内存容量的需求。HBM虽然速度稍慢,但其大容量能够更好地支持更大规模的AI模型训练和推理。

这场争论,就像是一场关于「速度」与「容量」的辩论,目前尚无定论。

三、Cerebras的野心:颠覆AI行业的「拨号时代」

Cerebras Systems并不满足于仅仅在AI推理速度上超越Nvidia,他们的目标更加远大:颠覆整个AI行业!

Feldman认为,WSE-3的超高推理速度,将为AI应用开辟新的机遇,就像宽带的兴起一样,将AI带入一个全新的「宽带时代」。他举例说,如果AI模型的推理速度足够快,就可以基于多个模型构建代理应用程序,而不会因为延迟变得难以为继。

Cerebras Systems的野心,无疑给整个AI行业注入了一剂强心剂。

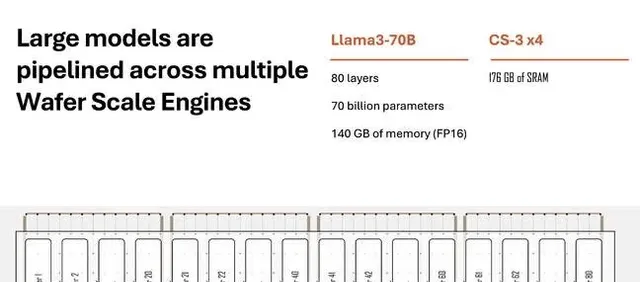

Cerebras Systems也面临着一些挑战。例如,WSE-3的SRAM容量有限,难以支持更大规模的AI模型;Cerebras Systems的生态系统尚未完善,需要吸引更多的开发者和合作伙伴。

Cerebras Systems能否成功挑战Nvidia的霸主地位,颠覆AI行业的「拨号时代」?让我们拭目以待!

你认为SRAM和HBM,谁才是AI推理的未来?欢迎留言讨论!

本文创作初衷在于传播正能量,无任何侵犯他人权益的意图。如有侵权,请联系我们,我们将积极配合处理。