在这个人工智能飞速发展的时代,你是否曾经好奇过,计算机是如何学会翻译语言、识别图像,甚至进行合理对话的呢?

2024年的诺贝尔物理学奖,就颁给了两位为机器学习奠定基础的科学家:约翰·霍普菲尔德(John J. Hopfield)和杰弗里·辛顿(Geoffrey E. Hinton)

。他们运用物理学的工具,构建了能够存储和重构信息、自主发现数据特征的方法,

为今天强大的人工神经网络铺平了道路

。

图源:Johan Jarnestad/瑞典皇家科学院

从大脑到机器:模仿自然的智慧

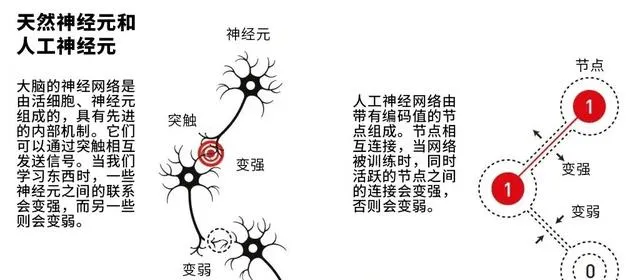

人工神经网络的灵感来源于我们的大脑。 就像大脑由数十亿个神经元通过突触相连一样,人工神经网络由大量的「节点」通过「连接」组成。每个节点就像一个神经元,可以存储一个值;而连接的强弱则类似于突触的强度,决定了信息传递的效果。

图源:Johan Jarnestad/瑞典皇家科学院

霍普菲尔德的联想记忆:

在「能量景观」中存储信息

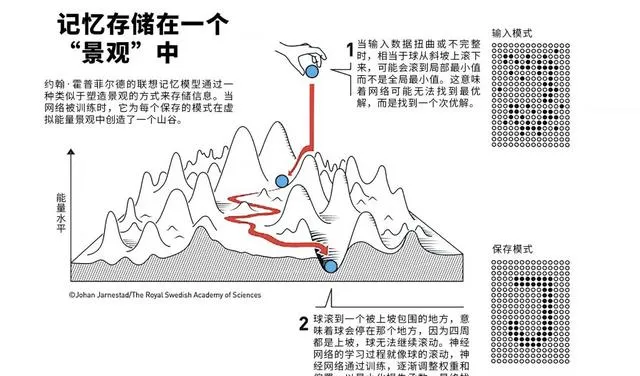

1982年,物理学家约翰·霍普菲尔德提出了一种革命性的网络结构,被称为「 霍普菲尔德网络 」。这个网络能够存储多个模式(比如图像),并且在给定不完整或有噪声的输入时,能够重构出最相似的存储模式。

霍普菲尔德的灵感来自物理学中描述磁性材料的理论。他将网络的状态比作一个「能量景观」,每个存储的模式就像景观中的一个山谷。当网络接收到新的输入时,就像在这个景观中滚动一个球,最终会停在最接近的山谷中,也就是找到了最相似的存储模式。

这种方法 非常适合处理有噪声或部分缺失的数据 ,比如恢复受损的图像或识别手写字符。

图源:Johan Jarnestad/瑞典皇家科学院

辛顿的玻尔兹曼机:

自主学习的突破

霍普菲尔德的网络主要用于存储和检索信息,杰弗里·辛顿则更进一步,希望机器能像人类一样自主学习和分类信息。1985年,辛顿和同事提出了「 玻尔兹曼机 」,这个名字源于19世纪物理学家路德维希·玻尔兹曼的方程。

玻尔兹曼机通常由两层节点组成:可见层用于输入和输出信息,隐藏层则影响整个网络的功能。这种结构允许网络 不仅能识别已知模式,还能生成新的、相似的模式 。比如,它可以在看过多张猫的图片后,生成一张新的、看起来像猫的图像。

更重要的是, 玻尔兹曼机能够通过例子学习 ,而不需要明确的指令。给它看足够多的猫和狗的图片,它就能学会区分这两类动物,甚至识别它从未见过的新图片。

图源:Johan Jarnestad/瑞典皇家科学院

从理论到实践:机器学习的革命

霍普菲尔德和辛顿的工作为机器学习奠定了理论基础,但真正的革命是在2010年左右开始的。得益于海量数据的可用性和计算能力的巨大提升,今天的人工神经网络已经发展成为拥有数十亿甚至上万亿参数的「 深度神经网络 」。

这些网络 被广泛应用于各个领域 ,从语言翻译到图像识别,从推荐系统到科学研究。例如,它们帮助物理学家在海量数据中寻找希格斯粒子,协助天文学家发现系外行星,甚至在预测蛋白质结构和设计新材料方面发挥重要作用。

展望未来:机遇与挑战并存

机器学习的迅速发展不仅带来了巨大的机遇,也引发了广泛的讨论,特别是在伦理和安全方面。如何确保AI技术的公平性和透明度?如何防止它被滥用?这些都是我们需要认真思考的问题。

2024年的诺贝尔物理学奖不仅是对霍普菲尔德和辛顿个人成就的肯定,更是对跨学科研究重要性的强调。他们的工作展示了,当物理学的深刻洞见与计算机科学的创新相结合时,能够产生多么令人惊叹的成果。

信息来源:诺贝尔官网新闻稿

编译:果壳翻译班

快来关注,不要错过!

本文来自果壳,未经授权不得转载.

如有需要请联系[email protected]