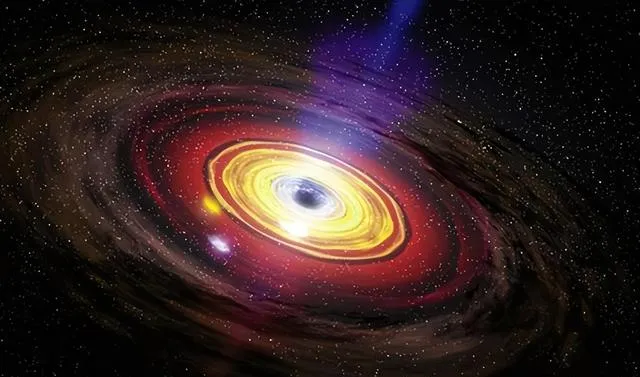

黑洞一直以来都是科学家们的「禁忌」,因为它吞噬的不仅是光,还有我们对宇宙的认知。但是你知道?

霍金辐射的发现让我们对黑洞有了全新的理解,甚至可以把它看作一台超级计算机,正在处理和存储宇宙间的信息。想知道黑洞究竟是如何「工作」的,以及它如何与宇宙的计算能力挂钩?

黑洞的霍金辐射改变了传统对黑洞的认知,表明信息并非完全消失。我们知道,传统上科学家对黑洞中的信息一直持消极态度,因为根据广义相对论的预测,任何坠入黑洞的物质都会被压缩到无穷,形成点状结构,也就是所谓的奇点。

物理学失去对奇点的描述能力,就好像在这个点上失去了一切信息一样,所以科学家很早就认为,黑洞吞噬的不仅仅是物质,还有信息。

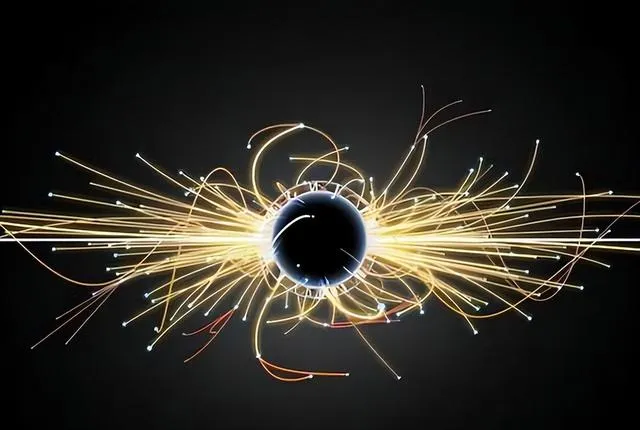

直到霍金提出霍金辐射之后,人们才第一次看到黑洞会主动释放某种东西。根据霍金的理论,虚拟粒子在产生的时候会以成对的方式出现,其中一个掉进了黑洞之中,另一个由于碰撞不到任何物质,所以有逃离的机会。

离开原来的轨道之后,它便成了一种真实的物质,虽然规模微乎其微,但是它携带了能量和信息,这些信息原本是黑洞吸收物质时获得的,现在随着辐射的产生被重新释放出来。

这样一来人们的认知发生了根本性的转变,在量子力学的帮助下,科学家开始认为黑洞其实是在处理和记录信息,只是我们一直无法从中获取到我们想要的信息罢了。

这也不是很奇怪的事情,在物理学中就连输入信息都要受到限制,只有少数情况下能够做到完全自由。

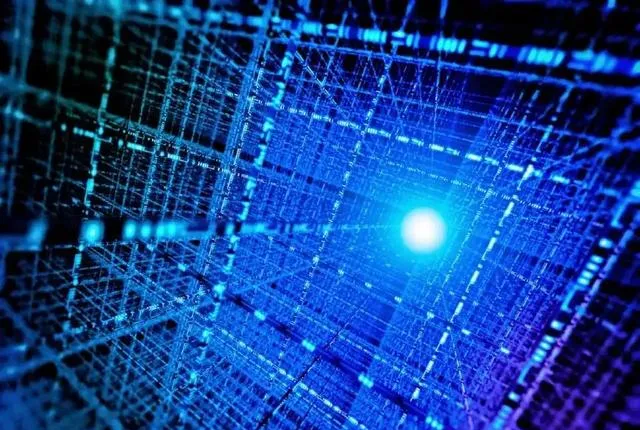

根据最新研究成果表明,宇宙本身具备运算的能力,而这个宇宙运算的能力和它的能量密切相关,同时还受到信息比特数的影响。

科学家计算得出的结果非常夸张,最多宇宙可以进行的运算次数是10的123次方。当我们听到这个数字的时候可能并不觉得它有多大,但是如果拿来做比较的话就会发现它的可怕之处。

例如人类创造出来的超级计算机,在最短时间内完成了所有运算任务,没有一颗灰色物质可以使用了,于是我们把运算任务交给宇宙来完成,宇宙得到这个程序之后表示轻松愉快,一万年不到就已经把所有运算做完了。这时候宇宙拿出10^123次方这个数字时,我们才会意识到自己和宇宙之间的差距。但是这里面还有一个问题没有被解决,那就是黑洞。

黑洞吞噬一切,包括光线、物质等等,那么当黑洞将这些信息存储起来进行计算之后,又通过什么样的方式将这些信息输出呢?从直观上来看,黑洞应当是和信息一起吞噬的物质,就像信息被限制在时空泡沫当中一样。那么这个时空泡沫到底是什么样子呢?

我们不能确定时空泡沫和黑洞本身的结构是一样的,因为它们有着自己独特的运动规律和模式。但是随着我们对量子计算机的研究深入,在量子力学方面有了新的突破之后,人们终于可以想象出黑洞处理信息的模式了。

量子运算同样需要能量,而且我们发现了一种可以影响量子信息比特的方式:外加磁场。例如对于自旋上有两个状态的质子来说,我们可以通过外加磁场来让它完成状态的翻转。如果把这个过程想象成一种计算,那么只要输入一定量的能量就可以完成。

假设黑洞也是通过这种模式来进行计算和处理信息的话,那么当宇宙规定输出信息时无法从黑洞中心传递能量时,则会从外围开始向中心投放能量。虽然中心接收不到这些能量,但对于黑洞来说其计算能力是不变的。这样一来人们就成功构建了模型:把黑洞视为压缩到极小体积的电脑。

电脑中存储着各种程序和数据,而宇宙中则储存着各种物理定律和运动规律。按照信息熵和比特数之间的关系以及霍金辐射产生规律来看也是非常吻合的。

根据熵公式我们知道,物质状态越高则其熵值越大;而根据霍金当年证明霍金辐射产生时缺乏携带信息这一点来看,则霍金辐射应当是基于熵为核心来产生的。

统计力学告诉我们,在某个体系中如果存在温差,则高温处粒子熵减小;低温处粒子熵增加。而总的熵值不会减小,在两者之间形成平衡。

由于霍金辐射是随机产生且不携带信息的,所以根据概率论来看大概率是低熵状态的粒子离开了黑洞,而高熵状态的能量则被保留了下来。

这些能量中同样包含着大量的信息,在被释放出来之后又重新归入了高熵状态,并不能影响自己被储存起来时所经历的过程。但是在处理信息时遵循的规则越多,则说明这类信息越不重要。

这一点在物理世界中同样适用,在高熵状态下被囊括进去且无法影响自己所处状态方向的信息显然比那些能够影响自己状态方向且得到翻转机会的信息要弱得多。

根据霍金当年提出来的思想体系构建我们发现:存储在黑洞中心更深处的信息正在得到处理,而外围边缘仅仅是被用来存放这些暂时没有用处、影响不大、不能影响自己命运转向但又不能被消灭规则约束必须保存下来的资料。

时空被证明不是连续无缝的,而是由无数个微小单元组成的:时空泡沫。如果我们把这些泡沫看作黑洞输入信息时受限制必须经过的通道,则每个泡沫中最多只能够存储一个单元(bit)的信息。

当然前提是:我们假设这个时空泡沫非常小,并且规定其中除了传递信息之外不能有别的物质存在。这样一来黑洞输入信息时就会受到存储空间不足的限制。

黑洞可被视为压缩到最小体积的电脑,假设我们将宇宙比作一个电脑,那么其中运行着各种程序:也就是物理定律。

而这些程序所需操作的对象就是数据:即我们所知道的信息。按照计算机原理来说,数据越多、程序越复杂则物理运算所需时间也就越长。

而黑洞作为宇宙中最顶尖的存储设备,其内部也在处理各种各样复杂程度不等的信息。

根据霍金当年提出来的思想体系我们知道:黑洞存储容量和其表面积成正比。也就是说质量越大、存储信息所占比重越大。

但是表面积毕竟是有限的,在存储大量信息之后剩下来执行运算和处理任务的空间显然就要少很多。

但问题在于:根据我们上面提到的模型,在处理信息时更消耗存储空间、表面积;而剩下来表面积更小、无法满足运算需要。这样一来黑洞似乎陷入了困境:即使存储足够多、足够重要的数据;却无法在处理时正常输出。

因为输出端缺少表面积;而表面积已经用完整个结构体上只能执行计算。那么如何解决这个问题呢?此前我们提到过:科学家把整个宇宙比作一个超级无敌大电脑。

按照计算机原理来说:只要程序没有错误、数据足够进入则是可以正常运行并且输出结果的;输出端只需要满足电流通过就可以。

虽然电流强弱能够影响硬件设备工作效率;但只要有电压存在;那么通过长时间工作总能得到结果。

而对于黑洞来说:虽然整体表面积很大很大;但内部结构并没有发生改变;依然按照原先恒定不变。

假设黑洞确实和时空一样;也是由无数微小单元组成;那么只需要把这些单元暂时拉扯开不就可以存储更多数据了吗?

等数据处理完毕之后;再把这些单元恢复原状不就可以了吗?整体运行输出便没有任何问题;只是过程发生了一些变化罢了。但是即便如此黑洞依旧处于无法输出信息的困境。

因为根据霍金当年提出来思想体系建立模型:资料越重要越深处被存储;而霍金辐射无法携带任何信息。

那么即便资料被处理完毕并且存储在更深处;也永远无法影响外部数据(暗含物理定律规则)被释放出来。

此后霍金也改变了自己关于黑洞处理和输出信息方面的看法;认为这恐怕是物理学中唯一无法实现逆向操作控制输入输出的地方;似乎打破了物理学中因果关系稳定性原理。

但直到今天我们依然没有找到解决问题得方法;即便是通过量子计算机模拟得出结论:暗示我们应该在某一个方向上寻找突破。