雖然去年老黃靠著p00帶頭的AI芯片在企業端賺飽飽,也成為AI芯片首屈一舉的龍頭企業,不過,對於一般消費者來說,除非你要AI影像運算,否則NVIDIA的AI技術似乎離你還是很遠。

不過,現在老黃要讓一般消費者也能享受NVIDIA芯片帶來的AI便利性了。

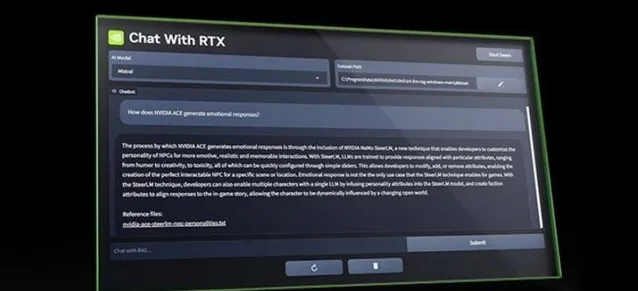

當人工智慧聊天機器人的風潮開始興起時,大多數人使用的是連線到雲端運算伺服器的聊天機器人。不過,讓聊天機器人在PC和智慧型手機上本地執行的趨勢越來越明顯。NVIDIA推出了一種新方法,讓Windows PC使用者可以建立自己的大型語言模型AI聊天機器人,並連線到本地端儲存的內容。

NVIDIA稱其為LLM Chat with RTX,現在該公司網站上提供了展示版。顧名思義,您的電腦必須配備NVIDIA GeForce RXT GPU才能執行這個本地端聊天機器人。以下是具體的硬體要求:

圖形處理器 -NVIDIA GeForce RTX 30或40系列圖形處理器或NVIDIA RTX Ampere或Ada代圖形處理器,至少配備8GB VRAM

記憶體 - 16GB或更大

作業系統 - Windows 11

Geforce驅動程式 - 535.11或更高版本

下載並安裝後,您就可以將"與RTX聊天"應用程式與您本地儲存的內容(如檔、PDF檔、視訊等)連線起來。然後,您就可以使用本地數據集向聊天機器人提問,這樣聊天機器人就能為您提供答案,而無需篩選所有數據。

不過,雖然聊天機器人在本地端執行無需聯網,但是如果要找答案的話,他還是可以上網幫你搜尋,比方說RTX聊天工具可以在一些YouTube視訊中尋找資訊。您只需將視訊的URL復制到應用程式中,然後就視訊內容提問。Chat with RTX會為您提供答案。

當然,像"與RTX聊天"這樣的本地端LLM應用程式的最大特點是,您可以擁有一個人工智慧聊天機器人,而不會將數據傳輸到公司的雲端運算伺服器,以用於培訓和其他目的。

不過,這樣做的代價是,你需要一台相當強大的電腦來執行它。

NVIDIA將"與RTX聊天"應用程式標註為免費技術展示。這可能表明,該公司計劃在未來某個時候將其轉變為具有更多功能的付費或訂閱型應用程式。