機器人的新腦袋

有研究者提出將「蟲子」腦袋裝進機器人裏,這一概念在移動機器人領域引起了熱議。近幾年大模型時代的浪潮下,谷歌的Transformer架構已成為行業主流。然而,一家名為Liquid AI的初創公司,正是由MIT電腦科學與人工智慧實驗室的前研究人員建立,他們的目標則是突破生成式預訓練Transformer(GPT)模型的局限。Liquid AI推出的多模態AI模型「Liquid Foundation Models」(LFM)為此而生,這是一種全新的生成式AI模型,其1B、3B和40B版本在多種條件下都能展現出頂尖的效能,同時顯著減少記憶體占用和提高推理效率。

LFM的驚艷表現

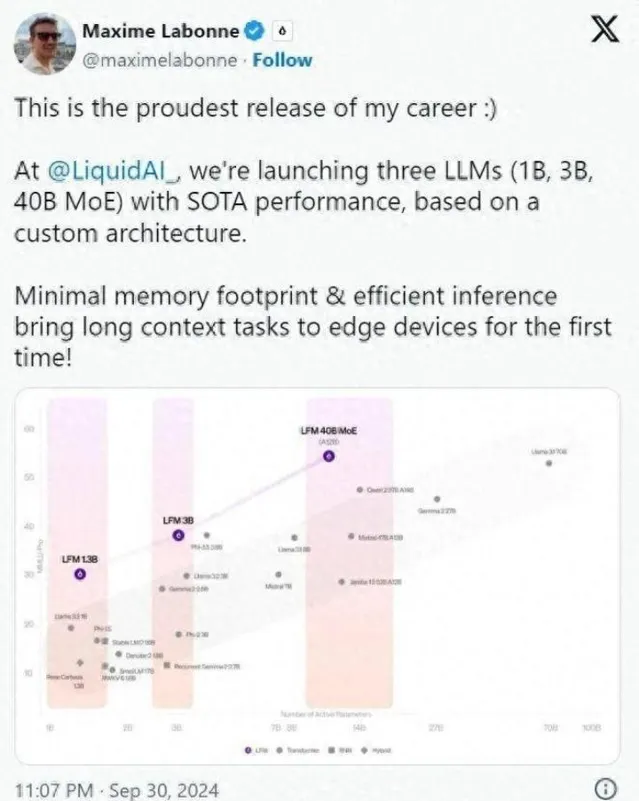

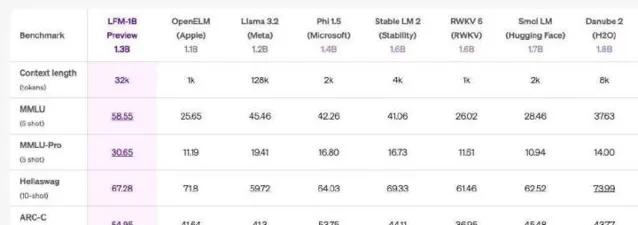

Liquid AI的後訓練主管Maxime Labonne在社交媒體上表達了對LFM的自豪感,認為其核心優勢在於可以超越傳統的Transformer模型,而記憶體占用則相對較少。這讓不少人感到驚喜,有人甚至評論LFM是Transformer的「終結者」。LFM系列中的LFM-1B規模在多項基準測試中表現斐然,獲得了最高分,成為同類產品中的佼佼者。

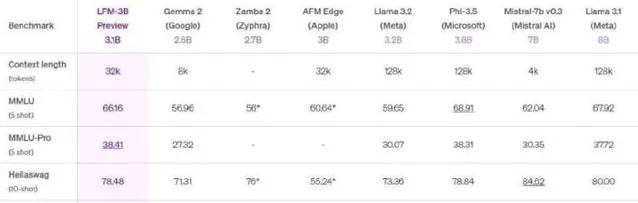

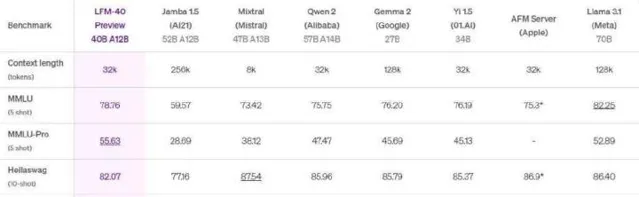

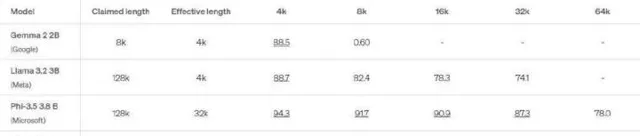

在與Meta的Llama和微軟的Phi模型的對比中,LFM 1.3B展現出強大的效能,位居第三方基準測試的頂峰。LFM-3B同樣表現優異,在與其他標稱為3B的Transformer、混合模型和RNN模型的對比中,表現排名第一。為了適應行動裝置及其他邊緣文本套用,LFM-3B成為了理想選擇,能夠在功耗更低的情況下實作更高的效率,而LFM-40B模型則在大小和輸出品質之間創造了新的平衡。

記憶體效率的優勢

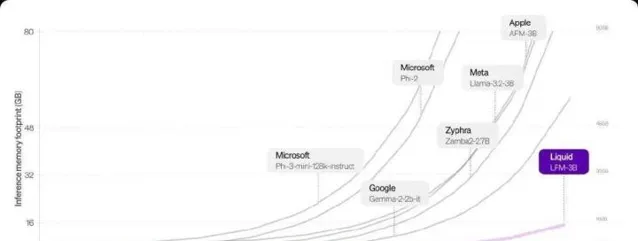

LFM模型在記憶體占用上顯示出顯著優勢,尤其是在處理較大的輸入時。在基於Transformer的模型中,長度越長的序列,記憶體需求呈線性增長,但LFM透過高效壓縮輸入可以在硬體上處理更長序列。以LFM-3B為例,它的記憶體需求僅為16GB,而Meta的Llama-3.2-3B則需要超過48GB。

這種記憶體的高效利用讓LFM在長上下文任務中的表現愈發出色。對於開發者來說,這意味著更多的套用場景,比如文件的分析與摘要、與聊天機器人更深入的互動等。Liquid AI的模型不僅在效能基準上與傳統模型競爭激烈,同時在操作效率上也為各種套用提供了完美的解決方案。

Liquid AI的顛覆性技術

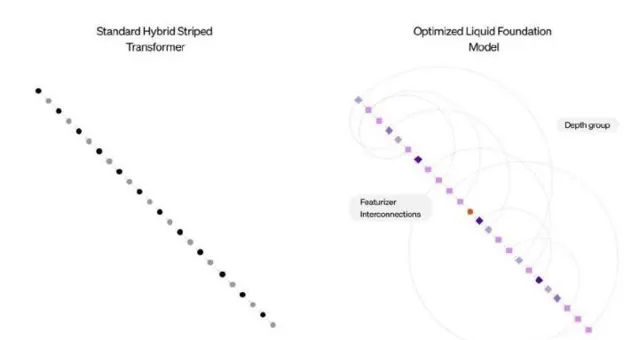

Liquid AI的發展得益於一系列全新的計算單元,這些單元的設計根植於動態系統理論以及訊號處理的基礎上。研究顯示,傳統的深度學習模型往往依賴數千個神經元來完成復雜任務,而Liquid AI的液態神經網路(LNN)證明較少的神經元也能實作相似的效果。LFM保留了這種靈活適應的優勢,讓推理過程中的調整變得更加高效。

尤其是在處理多達100萬個token時,LFM-3B在記憶體使用上的表現優於不少著名的AI模型。其他模型在處理長上下文時,記憶體消耗迅速上升,但LFM-3B卻保持在較低水平,因此非常適合需要大量順序數據處理的場景,比如聊天機器人和文件分析。

從線蟲到創新

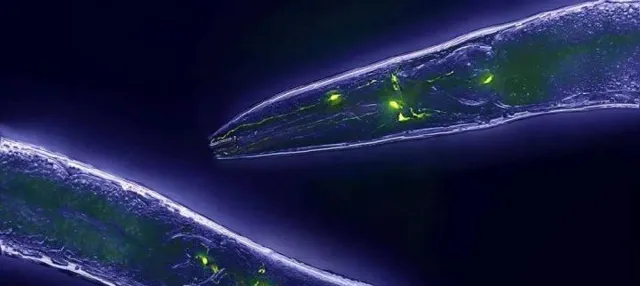

Liquid AI這一創業公司自2023年成立以來,便與OpenAI等其他語言模型公司展開競爭。其創始人之一Daniela Rus是MIT CSAIL的主管,借助其科研背景,團隊致力於開發基於生物神經機制的創新技術。秀麗隱桿線蟲這一生物模本的研究為Liquid AI打下了基礎。

線蟲雖然大腦簡單,但在復雜行為的學習和適應環境上表現優於現有許多AI系統。受此啟發,Liquid AI研發了液態時間常數網路,將神經元工作原理與數值計算結合,形成更為高效的計算模型。這種模型不僅在多個領域展現出其潛力,更因其較小的規模和更高的可解釋性而被廣泛關註。

小結

Liquid AI的崛起標誌著AI領域的一次重要創新,將復雜的生物神經結構與電腦技術相結合。新的液態神經網路在處理效率和記憶體占用上的優勢為未來的套用提供了更廣闊的可能性。雖然當前模型尚不完美,但透過持續的最佳化和使用者反饋,它有望在基礎模型領域發揮重要作用。希望未來這條來自小蟲子的道路能夠帶來更加驚艷的科技成果!