IT之家 7 月 20 日訊息,如今小語言模型開始升溫,許多廠商開始推出適用於手機等輕量級裝置的「小模型」,本周 Hugging Face 便公布了「SmolLM」小語言模型家族,其中包含 1.35 億、3.6 億及 17 億參數模型,IT之家附計畫如下(點此存取)。

據介紹,這些模型號稱是以精心策劃的高品質訓練數據集訓練而成,號稱在 Python 程式編寫效能上相當強大,團隊指出他們重點最佳化了模型所需的 RAM 用量,「即使是在 6GB RAM 的 iPhone 15 上也能執行」。

在訓練方面,Hugging Face 團隊首先建立了一款名為 SmolLM-Corpus 的數據集(數據集地址點此存取),該數據集主要包含 Python 教學內容 Python-Edu、Web 教育內容 FineWeb-Edu 以及使用 Mixtral-8x7B-Instruct-v0.1 和 Cosmopedia v2 兩款模型生成的常識內容,token 量總計 6000 億。此後 Hugging Face 團隊便使用 SmolLM-Corpus 數據集訓練了「SmolLM」小語言模型。

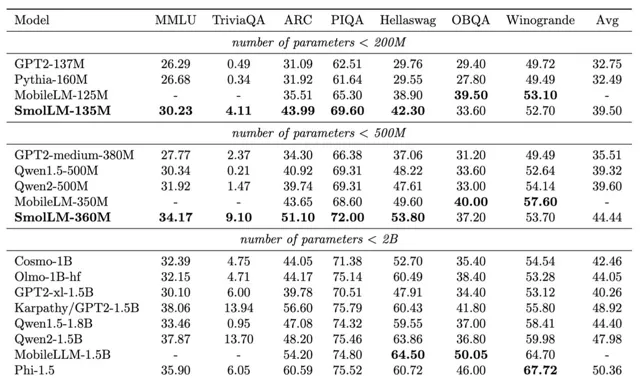

Hugging Face 團隊將開發出的 SmolLM 模型與相同參數量的其他模型進行了基準測試,其中 SmolLM-135M 在多項測試中超越了小於 2 億參數的其他模型;而 SmolLM-360M 的測試成績優於所有小於 5 億參數以下的模型,不過某些計畫遜於 Meta 剛剛公布的 MobileLLM-350M;SmolLM-1.7B 模型則超越了所有參數量小於 20 億參數的模型,包括微軟 Phi-1.5、MobileLLM-1.5B 及 Qwen2。