本文即將刊載於【中國科學院院刊】2024年第11期「政策與管理研究」

程學旗 1,2* 陳薇1,2* 沈華偉1,2 山世光1,2 陳熙霖1,2 李國傑1,2

1 中國科學院計算技術研究所 智慧演算法安全重點實驗室

2 中國科學院大學 電腦科學與技術學院

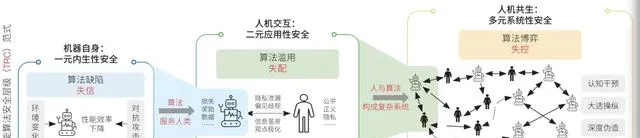

智慧演算法是指實作智慧的計算過程所體現的方法,大多具備數據驅動、不確定性計算、模型推斷難解釋等特性,而這些特性同時也給智慧演算法套用帶來了潛在的安全風險。文章首先探討智慧演算法安全的內涵。具體地,智慧演算法安全的內涵依據人機融合的程度,由演算法自身的一元內生性安全,延伸到演算法服務於人時的人機二元套用性安全,最終拓展為人機共生的復雜社會系統中多元系統性安全,故據此提出智慧演算法安全層級範式(以下簡稱「TRC範式」),分別涵蓋內生決策可信(trustworthiness)的一元安全目標、套用服務可管(regulatability)的二元安全目標和系統風險可控(controllability)的多元安全目標。進一步,基於當前實作TRC範式中的技術難點與智慧演算法可信、可管、可控的目標,文章提出實作智慧演算法安全需要重點突破的不確定性演算法的可信域判定、黑箱模型的透明化監測與人機共生智慧系統的風險臨界點感知3個重大科學問題。最後,圍繞TRC範式的「度量—評估—增強」技術體系,提出7項研究方向建議與4方面智慧演算法安全相關的發展建議,並展望其助力實作人機共治的未來願景。

人工智慧 (AI) 技術經過幾十年的發展,正在進入一個技術創新與顛覆式套用模式頻現的爆發期,人工智慧倫理與安全問題受到廣泛關註。 達特茅斯會議之前,科幻作家阿西莫夫提出了「機器人三大定律」,關於人工智慧的倫理與安全問題在這之後的很長一段時間主要集中在哲學和科幻領域。21世紀,以大數據融合深度學習為代表的統計學派占據了人工智慧技術主流,人工智慧的倫理與安全問題開始凸顯。近年來,生成式大模型在文本、影像、視訊、自然語言處理等領域產生系列現象級套用,人工智慧的倫理與安全問題快速出現,受到社會廣泛關註。例如,2019—2021年,美國國家公路交通安全總署統計共發生807起自動駕駛車禍案件,其中超過90%的案件涉及啟用Autopilot功能的特斯拉車輛撞擊帶有明顯標識的靜止車輛、公路隔離墩甚至行人;2018年9月,廣州市共查處外賣騎手交通違法近2000起,主要原因是外賣騎手為趕在平台AI演算法設定的限制時間內送達外賣而采取超速、逆行等危險駕駛行為;2016年,社交媒體平台Facebook在美國大選期間被俄羅斯機構利用AI演算法投放約8萬條政治輿論相關的貼文,劍橋分析公司非法使用8700萬臉書使用者的數據並利用AI演算法針對性地發送政治宣傳廣告。

針對日益嚴峻的人工智慧安全問題,各國政府在積極探索有效治理模式。 中國2021年以來先後釋出了【新一代人工智慧倫理規範】【可信人工智慧白皮書】【互聯網資訊服務演算法推薦管理規定】與全球首部針對生成式人工智慧的法規【生成式人工智慧服務管理暫行辦法】;並於2023年10月釋出【全球人工智慧治理倡議】,圍繞人工智慧發展、安全、治理3方面系統闡述了人工智慧治理的中國方案,提出11項倡議。美國白宮2023年10月首次針對AI釋出行政令,涵蓋建立AI安保、私密保護、人權保護、促進創新等多方面內容。歐洲2023年11月召開首屆全球AI安全峰會並簽署【布萊特利宣言】,確認解決人工智慧對人權保護、透明度和可解釋性、公平性、問責與監管機制、道德偏見、私密和數據保護等問題的必要性和緊迫性;歐盟理事會於2024年7月公布【人工智慧法案】,該立法遵循「基於風險」的方法,風險等級越高,管控越嚴格。

人工智慧領域的學者們呼籲重視人工智慧存在的安全風險。 2022年6月,第24屆中國科協年會釋出十大前沿科學問題,資訊領域唯一一個問題是「如何實作可信可靠可解釋人工智慧技術路線和方案?」。2023年3月,1000余名人工智慧領域學者簽署公開信,呼籲立即暫停訓練比GPT-4更強大的AI模型,為期至少6個月。2023年5月,圖靈獎獲得者Geoffrey Hinton教授從谷歌離職,原因是「為了自由地討論人工智慧的風險」,該事件引發社會各界對強人工智慧何時實作、其是否會取代人類等人工智慧倫理安全問題的大討論。

本文認為社會上對人工智慧安全性的恐懼主要來自科幻電影和媒體的誇張宣傳,認為智慧機器將會有自主意識,完全脫離人的控制,甚至成為新的物種征服人類,這只是一些人的猜測,目前還沒有科學依據,在可預見的未來,還不構成真正的安全威脅。對於長遠未來可能存在的安全問題,各國政府和前沿研究的學者們已經開始探討在人工智慧研究和開發過程中加強倫理道德的規範和引導,確保自主智慧的發展符合人類的價值觀和利益。本文更加關註當前AI套用過程中已經存在且愈演愈烈的問題。

盡管各國政府和國內外學者高度重視人工智慧安全,但對處於人工智慧核心的智慧演算法安全內涵理解尚未深入,實作演算法安全治理的技術路徑尚不明晰。本文旨在以計算的視角,梳理智慧演算法安全的需求,明確智慧演算法安全的內涵,並針對智慧演算法安全的目標,探討關鍵科學問題,提出潛在關鍵技術及其套用。這對在智慧化時代確保人類自身安全、保障使用者權益、維護社會穩定,最終實作人機共治,具有重要意義。

1 智慧演算法安全的內涵

智慧演算法

演算法是指將資訊進行變換的計算過程所體現的方法。 高納德(Donald E. Knuth) 教授定義演算法為求解特定型別問題的運算序列的一組有窮規則,並具備有窮性、確定性、輸入、輸出、能行性5個特征。

智慧演算法在本文中定義為實作智慧的計算過程所體現的方法。 智慧演算法大多具有數據驅動、不確定性計算、模型推斷難解釋等典型特征。智慧演算法的設計者基於少量知識設計參數化模型,依賴數據訓練模型參數。電腦在訓練階段基於隨機叠代計算更新模型,在推斷階段使用訓練所得模型面向具體任務產生輸出(圖1) 。基於多種任務來源的數據,智慧演算法所訓練的模型具有執行多種任務的能力。由於智慧演算法利用了大量數據中蘊含的知識,設計者所需的知識明顯減少,在此意義上稱其具備「智慧」。

圖1 智慧演算法的特點

智慧演算法目前以深度學習為典型代表,其不確定性與智慧的關系值得深入思考。 基於隨機數據學習的計算每一步叠代的機理是確定的,但經過多步叠代後的計算規則人類難以理解,規則意義上的確定性大大降低。與智慧演算法相比,傳統演算法的設計者依據特定知識設計確定性的計算規則,並由電腦執行產生輸出。故基於規則的計算如果能自發生成新的規則即可以減少對知識的依賴,在這種情況下,傳統演算法可以進階為智慧演算法。

智慧演算法的計算不確定性、結果復雜難解釋等特性使得對其安全風險進行管控極具挑戰。 近年來,基於多模態大模型的智慧演算法顯著提升了多工執行能力,與人類互動的障礙大大減小,套用場景急速擴大。與此同時,智慧演算法中模型判定與生成的不確定性結果對人類產生的不良影響也日益凸顯。以大語言模型為例,基於數據驅動的機率生成模式,可能生成與現實世界事實不一致的幻覺內容,產生錯誤;大模型的訓練、推斷機理復雜難解釋,模型的漏洞隱性難發現,在惡意者對抗攻擊下,可能出現推斷錯誤,導致歧視或泄露使用者私密等現象。

智慧演算法安全的內涵

智慧演算法安全研究致力於降低智慧演算法對人類產生的風險,研究如何度量、評估、增強智慧演算法的安全程度。 智慧演算法套用領域廣泛,正在與人類自身活動互動融合。人機融合的程度越深,風險形成的過程越復雜,科學問題的挑戰越大,安全治理技術的要求越高。因此,本文將演算法安全需求場景中人機智慧互動的程度劃分為演算法內生一元、人機互動二元與人機共生多元3個安全層級。

1. 演算法內生一元安全層級 。演算法作為生產工具幫助人類在物理空間的已有任務上提升執行效率、減小人類投入,或降低對生態環境的不良影響。例如,智慧農耕演算法提升糧食產量,智慧排程演算法減少能源消耗,自動駕駛演算法降低人類駕駛負荷,科學智慧演算法加快科學發現的行程等。此類任務中,演算法往往具備內在的適用邊界,當任務執行不當時會觸發物理世界中的事故。例如,自動駕駛車禍導致人民生命財產安全事故,自動交易演算法異常導致經濟損失,大模型幻覺導致錯誤決策等。

2. 人機互動二元安全層級 。在網路化套用中,大量演算法依托平台為使用者提供互動式智慧服務。例如,搜尋推薦演算法為使用者提供快速準確的資訊獲取服務,外賣平台演算法為消費者、商家、快遞員提供即時、高效的配置方案,視訊遊戲類演算法為使用者提供電子類別休閑娛樂服務等。在這些套用中,演算法作為智慧服務提供方,可能由於損害使用者權益而觸發服務產品的風險。例如,搜尋演算法泄露使用者私密,外賣平台導致快遞員疲於奔命,資訊推薦演算法導致使用者陷入資訊繭房等。

3. 人機共生多元安全層級 。演算法透過物理空間和網路空間與人類共同參與社會活動,形成人類智慧和機器智慧交織的人機共生系統。例如,帶有智慧體的社交平台,智慧演算法參與的金融交易系統,有人—無人系統共同參與的軍事演習等。此系統中,演算法可能由於透過行為傳導而觸發系統性安全風險。例如,基於社交平台的選舉操控,基於網路空間的社會認知賽局等。

智慧演算法3個安全層級依次巢狀,演算法內生一元安全層級是人機互動二元安全層級中機器在物理域對人提供的局部服務,人機互動二元安全層級是人機共生多元系統的人機二元局部互動系統,故單個智慧演算法會面臨跨層次的安全風險。例如,智慧駕駛的主要風險中,自動駕駛演算法不穩定導致的交通事故屬於演算法內生一元安全層級,演算法泄露使用者私密數據的風險屬於人機互動二元安全層級;互聯網服務平台中,排程決策演算法導致司機、騎手權益受損屬於人機互動二元安全層級,在突發極端情況下交通擁塞導致演算法可用性下降屬於演算法內生一元安全層級;社交平台被用於政治幹預產生社會認知風險屬於人機共生多元安全層級,平台使用者面臨私密泄露和資訊繭房等風險屬於人機互動二元安全層級。

智慧演算法安全層級(TRC)範式

智慧演算法3個層級關註的安全風險型別和產生原因不同:一元場景中關註由演算法內生缺陷導致演算法效能不可信,二元場景中關註由演算法套用中的濫用誤用導致演算法服務不可管,多元場景中關註由人機演算法賽局對抗導致系統演變不可控。智慧演算法安全的目標是實作智慧演算法一元內生決策可信 (trustworthiness) 、二元服務套用可管(regulatability) 、多元系統風險可控(controllability) ,即智慧演算法安全層級範式(以下簡稱「TRC範式」)(圖2) 。

圖2 智慧演算法安全層級(TRC)範式

一元內生性安全限定於機器自身,聚焦於智慧演算法內生缺陷導致的演算法決策失信。 人類設計智慧演算法的最初目的是順利實作其預期功能,其達成任務目標的能力僅由演算法自身決定,而與其如何被使用無關。在一元安全的範疇內,演算法的風險來自演算法自身缺陷所導致的失能或失效,體現為在遇到數據環境被動性變化或主動性對抗攻擊時功能失效或效能下降。因此,內生性安全著眼於智慧演算法在可變及對抗環境下的決策效能,其目標是構建效能穩健可靠的智慧演算法,實作智慧演算法內生機理可信。

二元套用性安全關註智慧演算法濫用誤用導致的演算法行為與使用者權益的失配。 隨著演算法的智慧水平逐漸接近人類智慧,其與人類的互動也日益緊密,影響日益顯著。演算法的風險主要源於其行為與人類社會的普遍價值觀(如公平、公正、私密等) 不一致,例如互聯網服務可能導致的歧視、私密泄露、觀點極化等道德或倫理失範和混亂問題。演算法套用性安全的目標是技術向善,在智慧演算法服務使用者的同時,避免損害個體和公眾的權益,確保技術創新與社會價值觀的和諧共融,實作智慧演算法的套用服務可管。

多元系統性安全著眼於人機共生系統中因演算法賽局對抗導致復雜社會系統的演化不可控。 智慧演算法的快速發展,促使復雜社會系統人機智慧融合,模糊了人機邊界,重構了社會結構與組織關系。與此同時,智慧演算法的自主決策演變可能會導致復雜社會系統呈現組織結構坍塌、傳播鏈式反應、系統臨界態不確定等失序、失控現象。演算法在某些任務上,如內容生成和傳播等,具有超越人類智慧的能力,這使得社會系統存在被演算法幹預的風險。隨著社會系統中的系統賽局強度升級,系統性風險開始顯現,例如偽造政治謠言、惡意宣傳、社會認知操控、有人—無人系統失控等。實作人機共生系統安全的可能路徑包括透過復雜社會系統的可計算建模,辨識與調控復雜社會系統風險的相變點,實作智慧演算法的社會風險可控。

智慧演算法安全層級範式與其他領域的聯系

TRC範式可以涵蓋已有的相關概念 (表1) 。

表1 TRC範式與現有相關概念的關系

1. 可信演算法與TRC範式的關系: 智慧演算法的可信性一般指演算法能被使用者或社會認為是可信賴的、可依賴的,包括演算法的魯棒性、公平性、可解釋性、私密性、可審計性等,其定義包含於TRC範式之中。

2. 負責任演算法與TRC範式的關系: 智慧演算法的負責任性一般指演算法的行為符合道德、法律要求,避免對人類、環境或社會造成危害或不良影響,其定義包含於TRC範式之中。

3. TRC範式中的系統性: 現有相關概念僅適用於描述演算法本身,故不適用於系統性安全層面。

智慧演算法安全是涉及社會域安全的一門新興學科,與其他安全類學科有一定的聯系 (圖3) 。在數位化早期階段,物理世界數位化是主體任務,物理電磁空間安全是關鍵,著重解決通訊安全、電磁安全與頻譜控制等難題;隨著互聯網的發展,人機互聯推動資訊域與物理域融合,網路與資訊保安問題凸顯,網路安全與資訊系統安全成為重點。當前社會已經進入智慧化時代,萬物互聯,「物理—資訊—社會」三元空間融合,演算法成為影響智慧社會執行的核心引擎之一,智慧演算法安全成為新的安全挑戰。這種挑戰的出現是資訊社會發展演進的必然結果,不同於以往主要關註物理域和資訊域的物理安全以及網路資訊保安,智慧演算法安全的關註點更加聚焦於由智慧演算法帶來的社會域問題,需要重新審視和構建安全保障的策略和措施。

圖3 智慧演算法安全與其它安全類學科的關系

2 智慧演算法安全的科學問題

基於對智慧演算法及其內涵的理解,本文認為智慧演算法安全的核心挑戰是確定性的安全要求與不確定性計算的智慧演算法及其難以度量的社會域風險三者之間的矛盾。 基於智慧演算法安全內涵,結合目前的技術難點與核心挑戰,面向TRC範式的不同層次,提出智慧演算法在安全「度量—評估—增強」技術鏈條的相應挑戰。

1. 針對內生性安全 ,度量是任務執行的功能指標,評估目前主要是試驗性方法,增強方面也主要是啟發式增強方法;

2. 針對套用性安全 ,度量的部份權益維度可計算,例如私密性、公平性,但缺乏統一的價值觀度量與計算方法,靜態、平均情形評估技術居多,即時、最壞情形監測技術欠缺;

3. 針對系統性安全 ,由於系統演化規律未知,可計算的社會安全度量尚未建立。

因此,TRC範式的技術難點依次為,內生性安全評估的理論判定,套用性安全評估的監測技術,系統性安全度量中的可計算方法。考慮到TRC的層級巢狀關系,每個技術難點的解決以其前一個難點的解決為必要條件。綜上,總結如下智慧演算法安全的3個關鍵科學問題。

1

不確定性演算法的可信域判定問題

智慧演算法包含不確定性計算,具有數據驅動、模型復雜、機理不清晰等特點。模型的不穩定性使得演算法決策的精準性和穩定性難以兼得;數據的不完備性使得關聯統計失效,導致演算法決策偏差;套用場景的突變性使得演算法場景先驗假設失效,導致演算法行為失控。如何實作對高復雜、強不確定性智慧演算法的可信域判定和增強,是保障智慧演算法內生性安全的關鍵科學挑戰。

2

黑箱模型的透明化監測問題

智慧演算法具有模型黑箱和結果難解釋等特性,演算法風險評估僅能透過演算法的外顯行為進行。智慧演算法黑箱體現為數據黑箱 (使用數據不透明) 、模型黑箱(決策機制不透明) 和目標黑箱(設計意圖不透明) ,從而導致監管方和演算法營運方存在資訊不對稱。如何僅透過演算法執行過程中的外顯行為反向推斷演算法的內在機理,實作演算法透明監測,是保障智慧演算法套用性安全的關鍵科學挑戰。

3

人機共生智慧系統的臨界點感知問題

智慧演算法促使復雜社會系統人機智慧融合,模糊了二者的邊界。傳統復雜系統理論缺乏對社會系統的可計算建模,不能滿足社會系統風險演化相變的臨界態分析需求。如何建模感知測繪、資訊生成、資訊傳播,辨識與調控復雜社會系統安全風險的相變點,是保障智慧演算法系統性安全的關鍵科學問題。

3 研究方向建議

圍繞智慧演算法安全相關基礎理論、關鍵技術及套用需求,中國科學院計算技術研究所部署設立了智慧演算法安全重點實驗室,旨在重點突破TRC範式面臨的重大科學問題,服務國家在智慧演算法安全治理和網路空間社會治理兩大需求。開展上述方向研究,不僅需要學術界綜合利用多學科交叉理論技術,更需要產業、政府部門提供實際套用和業務需求,各方共同構建新一代人工智慧安全治理框架。本部份依據智慧演算法安全的TRC內涵,針對前述3個科學問題,建議體系性地加強7項關鍵理論與技術研究,以期得到相關領域研究者與社會各界的關註,共同推動智慧演算法安全的持續發展。7個研究布局建議依據TRC範式體系性的提出,不僅為已出現的研究領域提供了新的研究思路並將它們聯系起來,同時指出了學術界仍未關註到的研究領域。

1

可信判定理論為智慧演算法安全的基礎理論支撐6項關鍵技術

針對智慧演算法面臨的模型不穩定、數據不完備、場景突變等挑戰,研究建立深度學習的數學原理,形成對模型在最佳化過程中收斂性的判定;研究建立因果學習理論,形成模型對不完備數據適應力的判定;研究建立可信學習理論,形成對模型在可變及對抗環境中泛化性的判定。

2

可信機制嵌入技術為安全增強提供基礎性方法

針對環境被動性變化導致的安全問題,研究先驗知識嵌入技術,實作對智慧演算法內生機理的安全增強;針對環境中主動性對抗攻擊導致的安全問題,研究防禦機制嵌入技術,實作對智慧演算法防禦能力的加固增強;基於價值觀可計算度量技術,建立可信價值觀嵌入方法,實作套用性安全增強。

3

社會域風險可計算度量技術為套用性安全建立度量標準

旨在衡量演算法與每一個使用者互動的過程中,是否符合倫理道德和法律的合規性。針對套用場景多變和人類價值觀 (例如法律法規、道德標準等) 難以量化所造成的度量困難,透過建立度量大模型,對演算法套用中出現的風險案例進行基於語意的評價。

4

智慧演算法黑箱監測技術可向內支撐內生性安全評估、向外延展到系統性安全評估

基於模型碰撞的意圖辨識,推斷模型內在機理,為套用風險判定奠定重要基礎;基於使用者模擬的風險發現,從宏觀層面發現演算法導致的私密泄露、繭房、公平性等套用風險;基於紅隊測試的案例生成,面向特定的度量指標,構造或挖掘違反度量指標的樣例,作為判定的取證樣例。

5

價值觀對齊技術依據可計算度量技術和可信嵌入技術,實作智慧演算法套用性安全增強

包括事前的全域對齊訓練與事後的局部對齊編輯相結合的範式。在模型釋出前,根據度量模型,透過監督微調、人類反饋強化學習、AI反饋強化學習、基於規則的獎勵模型等方式進行智慧演算法和價值觀的對齊訓練;在風險發生後,根據找到的違反度量指標樣例,透過對齊編輯、神經元定位及修復等方式,修復特定性錯誤。

6

人機共生智慧系統演化模擬技術為開展系統性安全研究建立前提

建立復雜社會認知模擬系統,並設計賽局效用度量及其動態評估方法。建立微觀個人化與宏觀群體化相結合的社會域安全度量可計算方法,探索觀點、立場、情感、價值觀等因素的量化體系,形成體系化的復雜系統賽局效用評估標準與評估模型。提出對真實系統進行模擬對齊的方式,評估智慧演算法系統性安全。

7

人機共生智慧系統臨界點感知與調控技術是系統性安全評估與增強的核心技術

透過脆弱點發現與多模態可控內容生成相結合,增強演算法賽局下的系統性安全。探索智慧演算法對復雜社會系統相變點的幹預機制,構建社會系統脆弱點感知發現和系統風險調控的關鍵技術鏈,形成具備對演算法惡意介入社會系統的防禦手段以及演算法介入的社會系統調控手段,實作復雜社會系統風險相變點的辨識與調控。

4 智慧演算法安全建議與未來展望

隨著人工智慧技術的快速發展並在不同行業領域廣泛產生顛覆性的套用,智慧演算法的安全問題也愈發成為人工智慧開發中的關鍵瓶頸。既需要結合實際需求場景解決智慧演算法所引發的數據、模型、套用等實際問題,也需要重視智慧演算法安全的基礎理論研究以及學科建設工作。雖然科技發展伴隨安全風險,但相信憑借各方的高度關註、全球協作、持續不懈,這把人工智慧倫理與安全的達摩克利斯之劍,將最終被人類所駕馭。在中國加速推動新一代人工智慧發展的戰略布局中,要重視與智慧演算法安全相關的4個方面工作。

1

夯實基礎理論

智慧演算法安全的核心矛盾以及3個科學問題對經典的計算復雜性理論、復雜系統理論、人工智慧安全與倫理研究提出了全新挑戰,如何在計算視角下推動這些理論的發展,並最終匯聚夯實智慧演算法安全的理論基礎是關鍵。相關理論研究不僅是建立智慧演算法安全的基石,也將促進傳統計算理論在智慧化時代變革發展。

2

促進學科交叉

智慧演算法安全將傳統的資訊保安拓寬到更廣泛的社會域人機共生智慧系統安全。相關研究涉及計算、智慧、安全、倫理、法律及社會科學相關的多個學科領域,需要跨學科交叉共同研究,建立基於多學科基礎的技術解決方案。與此同時,要推動國內外同行交流合作,共同形成全球人工智慧的治理框架並理性發聲,從而在新一輪科技革命中掌握一定話語權。

3

推進演算法安全產業閉環

借助商業模式創新,提升演算法安全技術突破在演算法服務中的套用速度與品質。鼓勵提供演算法安全服務的企業,透過演算法可信增強技術與演算法合規輔導服務,為企業節省安全維護成本、提升業務品質、實作商業價值,進而獲取相應的商業報酬。依托於核心技術突破,借助商業模式的推動,靈活快速地推動科技成果的落地套用。

4

加快人才培養

智慧演算法安全是一個全新的、快速發展的學科領域,應加快培養該領域的科研團隊力量,為優秀青年學者提供穩定的科研資源支持。同時,應盡快制定本領域研究生培養方案,探討在電腦、人工智慧和大數據相關學科領域設立智慧演算法安全本科專業的培養方案。

致謝:本文離不開智慧演算法安全重點實驗室研究團隊和中國科學院戰略性先導科技專項參與成員的長期共同論證和科研經驗積累。在此感謝蘇度、徐冰冰、李家寧、曹婍、孫飛等為本文作出的貢獻,受文章篇幅限制,不能一一列出成員姓名。

程學旗 中國科學院計算技術研究所研究員,主要研究領域:大數據分析系統、社會認知計算、智慧演算法安全。

陳 薇 中國科學院計算技術研究所研究員,主要研究領域:機器學習基礎理論與方法、可信機器學習、智慧演算法安全。

文章源自: 程學旗, 陳薇, 沈華偉, 等. 智慧演算法安全:內涵、科學問題與展望. 中國科學院院刊, 2024, 39(11): 1-10.DOI: 10.16418/j.issn.1000-3045.20240720004.