晶圓級AI芯片WSE-3效能揭曉:80億參數模型每秒生成1800個Token

WSE-3 磁盤式人工智慧芯片的效能公告:每秒透過 80 億個參數模式生成 1800 個字元。

今年 3 月,Cerebras Systems 推出了第三代人工智慧芯片 WSE-3,其效能是前代產品 WSE-2 的兩倍,可用於訓練業界最大的人工智慧模型。在最近舉行的 Hot Chip 2024 會議上,Cerebras Systems 詳細介紹了該芯片的人工智慧功能。

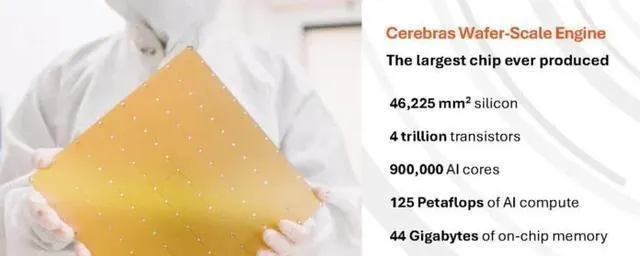

根據官方數據,WSE-3 采用基於台積電 5nm 工藝的 12 英寸晶圓制造,芯片面積為 46,225 平方公釐,擁有 4 萬億個晶體管、90 萬個人工智慧內核、44 千兆字節片上 SRAM、21 PB/s 的記憶體頻寬和 214 PB/s 的結構頻寬,峰值效能為 125 FP16 PetaFLOPS。WSE-3 的峰值效能為 125 FP16 PetaFLOPS,是其前身 WSE-2 峰值效能的 1 倍。

相比之下,WSE-2 芯片的表面積同樣為 46,225 平方公釐,采用 7 奈米台積電工藝,擁有 2.6 萬億個晶體管、85 萬個人工智慧內核、40GB 片上 SRAM、20 PB/s 的記憶體頻寬和高達 220 PB/s 的結構頻寬。

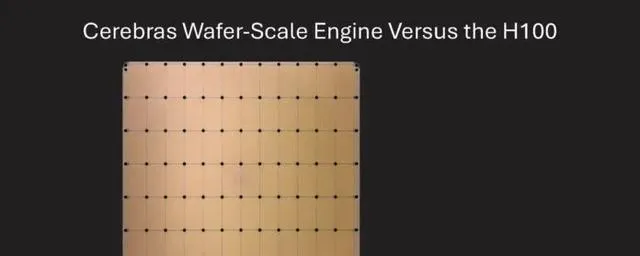

與輝達™(NVIDIA®)的 p00 相比,WSE-3 的面積增加了 57 倍,內核增加了 52 倍,片上記憶體增加了 880 倍,記憶體頻寬增加了 7000 倍,結構頻寬增加了 3715 倍(p00 的 HBM3e 僅為 4.8 TBps)。

在 Hotchpotch 2024 會議上,Cerebras 詳細介紹了 WSE-3 在執行大規模人工智慧模型方面的效能。

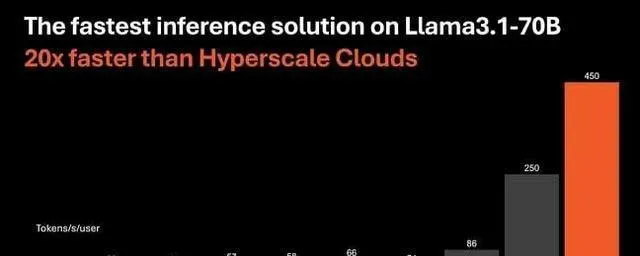

Cerebras聲稱,Llama 3.1-8B的推理速度是微軟Azure等使用輝達p00的公司的20倍。值得註意的是,在許多現代生成式人工智慧工作負載中,推理效能通常更多受益於記憶體頻寬,而非計算能力本身:記憶體頻寬越高,模型推理速度越快。

據 Cerebra Systems 執行長安德魯-費爾德曼(Andrew Feldman)介紹,WSE-3 使用具有 16 位分辨率和 44GB 片上 SRAM 的 Llama 3.1 8B,每秒可生成超過 1800 個字元,而基於輝達™(NVIDIA®)p00 的最高效能例項每秒只能生成超過 242 個字元。字元數

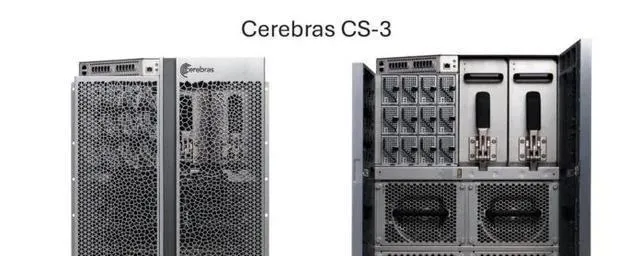

與此同時,Cerebras 推出了基於 WSE-3 的 CS-3 超級電腦,能夠訓練多達 24 萬億個參數的人工智慧模型,與 WSE-2 和其他基於現代人工智慧處理器的超級電腦相比,這是一個重大進步。該超級電腦支持 1.5 TB、12 TB 或 1.2 PB 的外部記憶體,可將大量模型儲存在單一邏輯空間中,無需分區或重新配置,從而簡化了訓練過程,提高了開發人員的效率。

Cerebras的最新軟體框架內建了對多模態模型、視覺轉換器、專家融合和擴散以及PyTorch 2.0等最新人工智慧模型和技術的支持,是唯一一個為動態和非結構化稀疏性提供內建硬體加速的平台,與輝達DGX-100計算系統相比,訓練速度最多可提高8倍。與輝達 DGX-100 計算系統相比,最高可提高 8 倍。

此外,透過使用分布在四個 CS-3 加速器上的 700 億個喇嘛 3.1 大參數,它還實作了每秒 450 個字元的速度。相比之下,p00 加速器每秒最多只能處理 128 個字元。

費爾德曼認為,寬頻等這些發展將為人工智慧帶來新的機遇。他說,"我認為我們正處於通用人工智慧時代,"他指的是通用人工智慧的早期套用,在這些套用中,呼叫響應可能會出現明顯的延遲。

他認為,如果處理請求的速度足夠快,就可以建立基於多個模型的代理應用程式,而不會因為延遲而難以為繼。Feldman 認為具有效能優勢的另一個套用是,LLM 可以分幾個階段叠代響應,而不是只提供第一個響應。如果標簽的處理速度足夠快,就可以在後台進行進一步處理。

在使用 16 位分辨率的 Lama 3.1 8B 時,WSE-3 每秒可生成超過 1,800 個字元,但如果系統不受計算限制,生成字元的速度會更快。

該產品標誌著 Cerebras 的改變,它以前主要專註於人工智慧培訓。現在,它專註於人工智慧推理,但硬體並沒有太大變化:據費爾德曼稱,它使用相同的 WSE-3 芯片和 CS-3 系統進行推理和訓練。

"費爾德曼解釋說:"我們已經擴充套件了編譯器的功能,可以同時在芯片上安裝多個層。

SRAM 的速度更快,但會增加 HBM 的容量。

與 HBM 相比,SRAM 記憶體在效能方面具有明顯優勢,但在容量方面卻落後於 HBM。對於大型語言模型 (LLM) 而言,44 GB 的容量並不算大,而對於 WSE-3 目標的大容量批次處理而言,必須考慮鍵值緩存所占的大量空間。

Metan 的 Llama 3 8B 型號是 WSE-3 的理想方案,因為 16 GB 型號(FP16)適合整個芯片的 SRAM 記憶體,為鍵值快取留下了約 28 GB 的空間。

據 Feldman 稱,WSE-3 不僅吞吐量非常高,而且可以擴充套件到更大的批次規模。關於可延伸性和支持使用者特定令牌吞吐率的能力,具體細節沒有透露。"我們目前的批次規模經常波動。我們預計第四季度的批次規模將達到兩位數,"Cerebras 說。

當被問及更多資訊時,Feldman 回答說:"由於實施規模尚未確定,我們目前不想提供更多細節。該系統架構設計用於處理大批次數據,我們希望在未來幾周內能夠實施。

與現代圖形處理器一樣,Cerebras 透過將模型並列到多個 CS-3 系統來解決這一問題,特別是透過使用流水線將模型層分成多個系統。

就需要 140 GB 記憶體的 Llama 3 70B 而言,該機型的 80 層被劃分為四個 CS-3 系統,透過乙太網路鏈路相互連線,因此數據必須透過這些鏈路,從而導致效能下降。

由於單個 WSE-3 只有 44 千兆字節的 SRAM 記憶體,因此必須將多個加速器組合起來才能支持更大的模型。

不過,費爾德曼認為,節點之間的延遲並不像人們想象的那麽大:"延遲是真實存在的,但它非常小,因為訊號透過芯片的所有其他層時,延遲是分布式的。"最終,訊號只占總延遲的 5%。"所以只占 5%左右"。

據 Cerebras 估計,在大型模型中,例如最近推出的擁有 4500 億個參數的 Lama 3 模型,12 套 CS-3 系統每秒可處理約 350 個字元。

使用速度更快的片上 SRAM 替代 HBM 並不是什麽新鮮事,Cerebra 的競爭對手 Groq 也采取了同樣的做法。

Groq 的語言處理單元(LPU)實際上使用的是片上 SRAM 記憶體,不同之處在於,單個 Groq LPU 的 SRAM 記憶體容量較小,這意味著需要在光纖上連線更多加速器,以支持大型設計。

Cerebras 稱,需要四台 CS-3 才能以每秒 450 個字元的速度執行 Lama 3 70B,Gruk 稱,需要 576 個 LPU 才能達到每秒 300 個字元的速度,而 Cerebras 參照的人工智慧分析公司 Gruk 估計的數位略低,為每秒 250 個字元。

費爾德曼還指出,Cerebras 可以在沒有量化的情況下做到這一點。Groq 聲稱使用 8 位量化實作了減少模型大小、計算開銷和記憶體負荷的效能目標,但準確性略有下降。

但是,僅僅比較效能而不考慮總成本是不公平的;畢竟,單個晶圓級 WSE-3 芯片的成本也遠遠高於 Groq LPU 的成本。