衡宇 發自 凹非寺

Transformer大模型尺寸變化,正在重走CNN的老路!

看到大家都被LLaMA 3.1吸引了註意力, 賈揚清 發出如此感慨。

拿大模型尺寸的發展,和CNN的發展作對比,就能發現一個明顯的趨勢和現象:

在ImageNet時代,研究人員和技術從業者見證了參數規模的快速增長,然後又開始轉向更小、更高效的模型。

聽起來,是不是和GPT哐哐往上卷模型參數,業界普遍認同Scaling Law,然後出現GPT-4o mini、蘋果DCLM-7B、谷歌Gemma 2B如出一轍?

賈揚清笑稱,「這是前大模型時代的事兒,很多人可能都不咋記得了:)」。

而且,賈揚清不是唯一一個感知到這一點的人, AI大神Kappa西也這麽覺得 :

大模型尺寸的競爭正在加劇……但是卷的方向反著來了!

模型必須先追求「更大」,然後才能追求「更小」,因為我們需要這個過程,幫咱把訓練數據重構成理想的、合成的格式。

他甚至拍著胸脯打賭,表示我們一定能看到又好、又能可靠地思考的模型。

而且是參數規模很小很小的那種。

連馬斯克都在Kappa西的評論區連連稱是:

以上,大概可以稱之為「大佬所見略同」。

展開說說

賈揚清的感慨,要從只在最強王座上短暫待了一天的LLaMA 3.1說起。

那是首次實作「最強開源模型=最強模型」,不出意外,萬眾矚目。

However,賈揚清在這個時候提出了一個觀點:

「但我認為, 行業會因小型垂直模型而真正蓬勃發展 。」

至於啥是小型垂直模型,賈揚清也說得很清楚,比如以Patrouns AI的Iynx(該公司的幻覺檢測模型,在幻覺任務上超過GPT-4o)為代表的那些很棒的中小模型。

賈揚清表示,就個人喜好而言,他本人是非常喜歡千億參數模型的。

但現實情況裏,他觀察留意到,7B-70B參數規模之間的大模型,大家用起來更順手:

它們更容易托管,不需要巨大的流量即可盈利; 只要提出明確的問題,就能得到品質還不錯的輸出——與和之前的一些看法相反。

與此同時,他聽說OpenAI最新的、速度很快的模型也開始變得比「最先進的」大模型尺寸更小。

「如果我的理解是正確的,那麽這絕對表明了行業趨勢。」賈揚清直接表明了自己的觀點,「即在現實世界中,使用適用的、具有成本效益、且仍然強大的模型。」

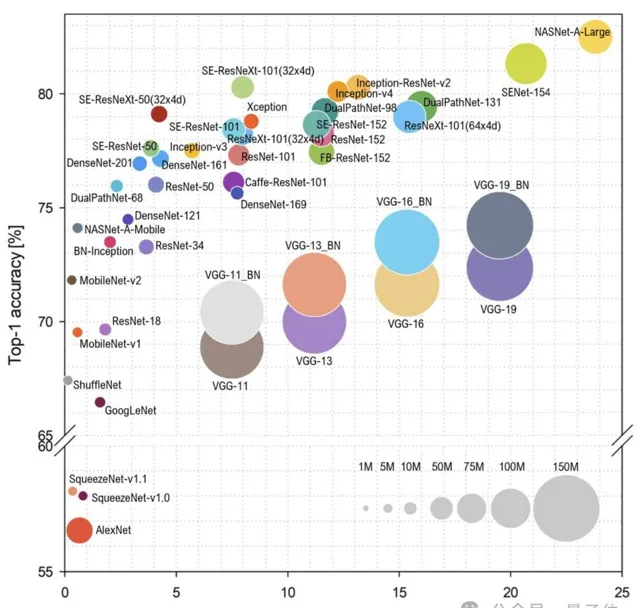

於是乎,賈揚清簡單梳理了CNN的發展歷程。

首先,是CNN的崛起時代。

以AlexNet(2012)為起點,開啟了大約三年的模型規模增長時期。

2014年出現的VGGNet就是一個效能和規模都非常強大的模型。

其次,是縮小規模時期。

2015年,GoogleNet把模型大小從「GB」縮小到了「MB」級別,即縮小了100倍;但模型效能並沒有因此驟減,反而保持了不錯的效能。

遵循類似趨勢的還有2015年面世的SqueezeNet模型等。

然後的一段時間,發展重點在追求平衡。

後續研究,如ResNet(2015)、ResNeXT(2016)等,都保持了一個適中的模型規模。

值得註意的是,模型規模的控制並沒有帶來計算量的減少——其實,大夥兒都願意投入更多的計算資源,尋求一種「同等參數但更高效」的狀態。

緊接著就是CNN在端側起舞的一段時期。

舉個例子,MobileNet是谷歌在2017年推出的一項有趣的工作。

有趣就有趣在它占用的資源超級少,但是效能卻非常優異。

就在上周,還有人跟賈揚清提到:「Wow~我們現在還在用MobileNet,因為它可以在裝置上執行,而且在出色的特征嵌入泛化(Feature Embedding Generality)。」

最後,賈揚清借用了來源於Ghimire等人的【A Survey on Efficient Convolutional Neural Networks and Hardware Acceleration】裏的一張圖:

並再一次發出自己的疑問:

大模型尺寸,會遵循與CNN時代相同的趨勢來發展嗎?

網友怎麽看?

其實GPT-4o mini這樣走在大模型發展道路上「不大反小」的例子不在少數。

當上述幾位表達出這樣的觀點後,立馬有人點頭如搗蒜,還拿出了一些別的類似例子,證明他們看到了相同的趨勢。

有人立馬跟上:

我這兒有個新的正面例子!Gemma-2就是把27B參數大小的模型知識蒸餾成更小的版本。

還有網友表示,開發更大的模型,意味著能給後續幾代更小、更垂直的模型的訓練「上強度」。

這個叠代過程最終會產生所謂的「完美訓練集」。

這樣一來,較小的大模型在特定領域,能與現在參數巨大的大模型一樣聰明,甚至更聰明。

一言以蔽之, 模型必須先變大,然後才能變小。

大多數討論此觀點的人,還是對這個趨勢比較認同,有人直言「這是一件好事,比‘我的模型比你的模型大’參數競賽更實用和有用。」

但是,當然了!

翻遍網路評論區, 也有人發出不同的聲音。

比如下面這位朋友就在賈揚清推文底下留言:

Mistral Large(背後公司Mistral AI)、LLaMA 3.1(背後公司meta)和OpenAI,持有最強競爭力模型的公司,目前可能都正在訓練更大的模型。

我沒發現有「更小型號模型搞定技術突破」的趨勢喲。

面對這個問題,賈揚清倒也及時回復了。

他是這麽說的:「沒錯!我說大模型尺寸可能在走CNN的老路,絕對不意味著號召大家停止訓練更大的模型。」

他進一步解釋道,這麽說的本意是,隨著技術(包括CNN和大模型)落地實踐越來越廣,大家已經開始越來越關註價效比更高的模型了。」

所以,或許更高效的小·大模型,能夠重新定義AI的「智慧」,挑戰「越大越好」的假設。

你贊同這個觀點不?

參考連結:

[1]https://x.com/jiayq/status/1818703217263624385

[2]https://x.com/fun000001/status/1818791560697594310

[3]https://www.patronus.ai/

[4]https://twitter.com/karpathy/status/1814038096218083497

— 聯系 作者 —

— 完 —

年度AI主題策劃 正在征集中!

歡迎投稿專題 一千零一個AI應 用 , 365行AI落地方案