美國商務部負責為美國政府、公司和廣大公眾開發和測試技術的機構--國家標準與技術研究院(NIST)重新釋出了一個測試平台,旨在測量惡意攻擊--尤其是"毒害"人工智慧模型訓練數據的攻擊--會如何降低人工智慧系統的效能。

這個模組化、開源的網路工具於2022年首次釋出,名為Dioptra(取自經典的天文和測量儀器),旨在幫助訓練人工智慧模型的公司和使用這些模型的人評估、分析和跟蹤人工智慧風險。NIST 表示,Dioptra 可用於對模型進行基準測試和研究,還可提供一個通用平台,讓模型在"紅隊"環境中面臨模擬威脅。

"測試對抗性攻擊對機器學習模型的影響是 Dioptra 的目標之一,"NIST 在一份新聞稿中寫道。"這個開源軟體就像生成可供免費下載的孩子一樣,可以幫助包括政府機構和中小型企業在內的社群進行評估,以評估人工智慧開發者對其系統效能的宣稱。"

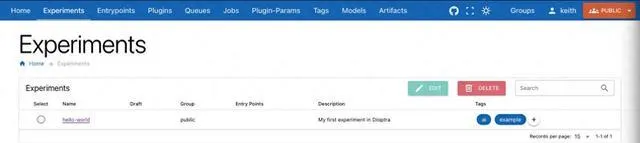

NIST DioptraDiatropa的界面截圖

Dioptra與NIST和NIST最近成立的人工智慧安全研究所的檔同時亮相,這些檔提出了減輕人工智慧某些危險的方法,比如人工智慧如何被濫用來生成未經同意的色情內容。在此之前,英國人工智慧安全研究所(U.K. AI Safety Institute)也推出了"檢查"(Inspect)工具包,該工具包同樣旨在評估模型的能力和整體模型的安全性。去年 11 月,英國在布萊切利公園舉行的人工智慧安全峰會上宣布,美國和英國將繼續合作,共同開發先進的人工智慧模型測試。

Dioptra 也是喬-拜登(Joe Biden)總統關於人工智慧的行政命令(EO)的產物,該行政命令(除其他事項外)要求 NIST 協助進行人工智慧系統測試。與此相關,該行政令還制定了人工智慧安全和安保標準,包括要求開發模型的公司(如蘋果公司)在向公眾部署模型之前,必須通知聯邦政府並分享所有安全測試的結果。

正如我們之前所寫,人工智慧基準很難制定--其中最重要的原因是,目前最復雜的人工智慧模型都是黑盒子,其基礎設施、訓練數據和其他關鍵細節都被建立模型的公司保密。英國研究人工智慧的非營利性研究機構艾達-拉芙蕾絲研究所(Ada Lovelace Institute)本月釋出的一份報告發現,僅靠評估不足以確定人工智慧模型在現實世界中的安全性,部份原因是現行政策允許人工智慧供應商有選擇性地選擇進行哪些評估。

NIST 並未斷言 Dioptra 可以完全消除模型的風險。但該機構確實提出,Dioptra 可以揭示哪些型別的攻擊可能會降低人工智慧系統的效能,並量化這些攻擊對效能的影響。

然而,Dioptra 的一個主要局限是,它只能在可下載和本地使用的模型(如 Meta 不斷擴充套件的 Llama 系列)上開箱即用。像 OpenAI 的 GPT-4o 這樣受 API 限制的模型,至少目前還不能使用。