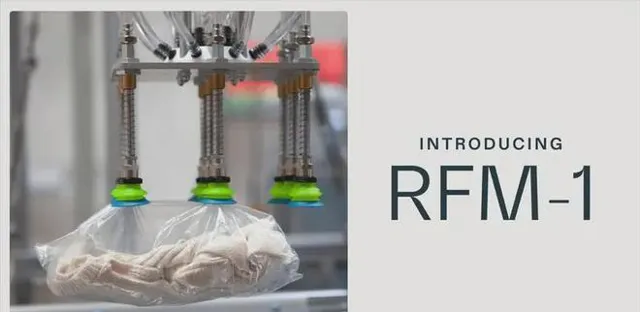

在人工智慧飛速發展的今天,ChatGPT、Midjourney等AI工具正將人類的想象力轉化為海量數位內容。但由於缺乏真實世界的物理常識,這些模型仍難以勝任需要精準操控的實體任務。不久前,加州大學柏克萊分校著名教授Pieter Abbeel及其團隊研發出一款名為RFM-1的機器人"大腦",有望填補數位世界與現實世界的鴻溝,推動智慧制造跨越式發展,被評價為 「開啟機器人基礎模型新紀元」。

▍海量異構數據「餵養」,機器人擁有通用技能

由Abbeel及其學生創辦的機器人公司Covariant推出了全新的機器人基礎模型RFM-1。該系統利用公司積累的大量機器人運算元據,結合網路上的影像、文本等海量資訊進行訓練,使機器人獲得了一系列通用技能。

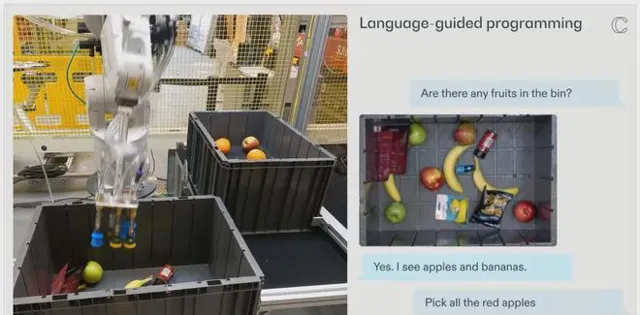

RFM-1能辨識影像、傳感器數據、自然語言,並將它們對映到合適的機器人動作。即使面對全新物體如香蕉,它也能迅速理解如何拿取。而且,你可以用口語化指令如「pick up the yellow fruit」來控制機器人,就像對話聊天機器人一樣簡單自然。

RFM-1甚至能想象出執行任務的過程。輸入初始場景和目標,它會生成一段模擬視訊,展示如何操縱物體、預測結果,體現了對物理世界的理解。Covariant CEO Peter Chen評價道:「我們成功將數位領域積累的洞察力轉移到了現實世界。」

▍語言互動引導操作,人機協作更高效

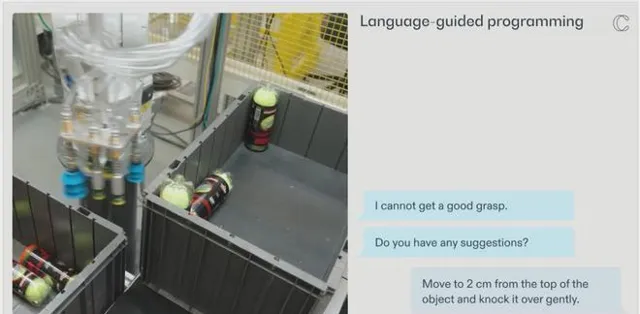

在傳統的機器人編程中,工程師需要用復雜的程式碼一步步定義機器人行為,開發周期長且缺乏靈活性。而基於RFM-1,操作員可直接用自然語言指導機器人。

例如,如果需要機器人對貨物進行分揀,只需用英語描述「將紅色的盒子放進2號箱」之類的指令,RFM-1就能快速編譯成可執行的機器人動作序列。據悉,借助語言互動,新任務的開發時間有望從數周縮短到數分鐘。

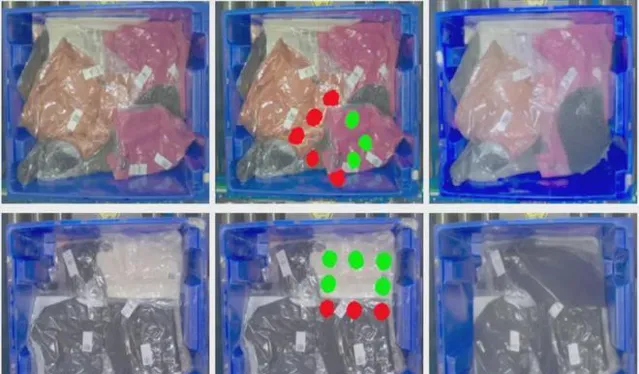

不僅如此,RFM-1還能主動向人類求助。當遇到拿取物體等困難時,機器人會嘗試分析原因,並向人類operators尋求幫助。人類給出移動或碰撞物體等建議後,RFM-1能將其轉化為可行策略,並套用到後續嘗試中。透過這種人機協作,復雜任務的執行效率有望大幅提升。

▍多模態世界模型構建,機器人更懂行

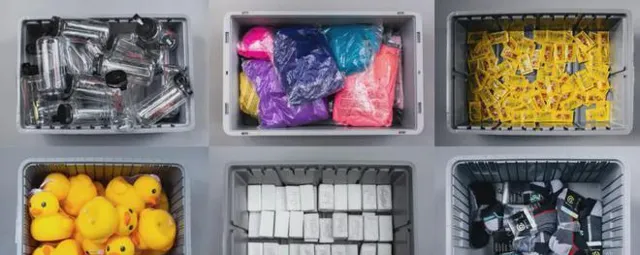

作為通用智慧體,RFM-1需建立起對物理世界的整體認知。Covariant為此專門收集了包含視覺、觸覺、語言的多模態機器人數據集,用於訓練RFM-1構建層次化的世界模型。

透過學習視訊序列生成,RFM-1掌握了低層次的物理規律,如剛體、鉸鏈的運動特性等。輸入初始畫面和動作序列,它能預測出未來的場景。在更高層次上,RFM-1還能對機械臂的操控效果做出判斷,比如夾取特定物體後,料箱內剩余物品的排布等。這種物理推理能力反過來又強化了視覺運動技能的學習。

目前,受限於計算資源,RFM-1構建的世界模型在時空分辨率上還比較粗糙。但隨著數據的持續采集和模型架構的最佳化,相信未來它能以更精細的粒度模擬真實環境。這將助力機器人去適應更多復雜多變的套用場景。

▍機遇與挑戰並存,未來仍需努力

盡管RFM-1展現出了誘人的套用前景,但距離大規模產業化部署仍有相當長的路要走。

首先是安全性問題。RFM-1目前還主要在倉儲物流等容錯率較高的領域進行測試。而在制造業、家政服務等對精度和穩定性要求更高的場合,可能還需要更多的工程驗證。

其次是場景適配問題。Covariant計劃未來大幅擴充訓練數據量,以覆蓋更廣泛的物體型別、環境條件。但即便如此,通用模型在落地特定行業時,仍然需要針對性的微調和客製化開發。目前整體任務規劃邏輯還是由傳統程式碼控制,如何與RFM-1靈活整合也是一個挑戰。

最後,機器人研發成本高昂,商業化道路漫長。當前RFM-1在運算效率、感知精度等方面的提升空間仍然很大。同時,AI研發人才供給有限,硬體部署成本不菲,產業爆發尚需時日。

盡管如此,Abbeel團隊依然堅信,RFM-1代表了機器人基礎模型的新起點。「如果機器人能預見未來,它就能規劃行動。」Abbeel如是說。未來,類似RFM-1這樣集環境理解、任務規劃、運動控制等於一體的「機器人大腦」,有望帶來自動化水平的整體躍升,為智慧制造、服務業帶來新的增長動能。我們拭目以待。